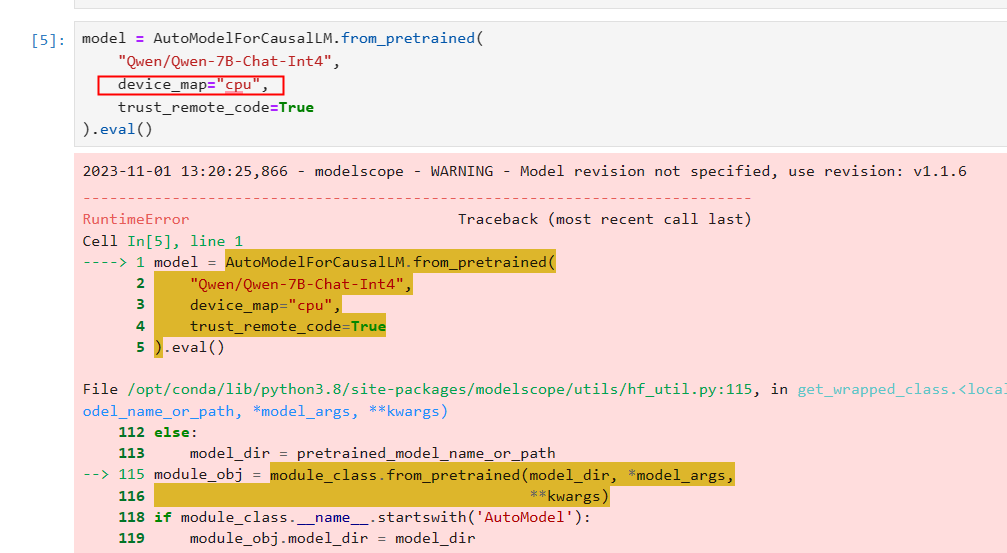

ModelScope中,cpu不能部署量化的模型么,

,optimum和auto-gptq这两个包都已经装好了

,optimum和auto-gptq这两个包都已经装好了

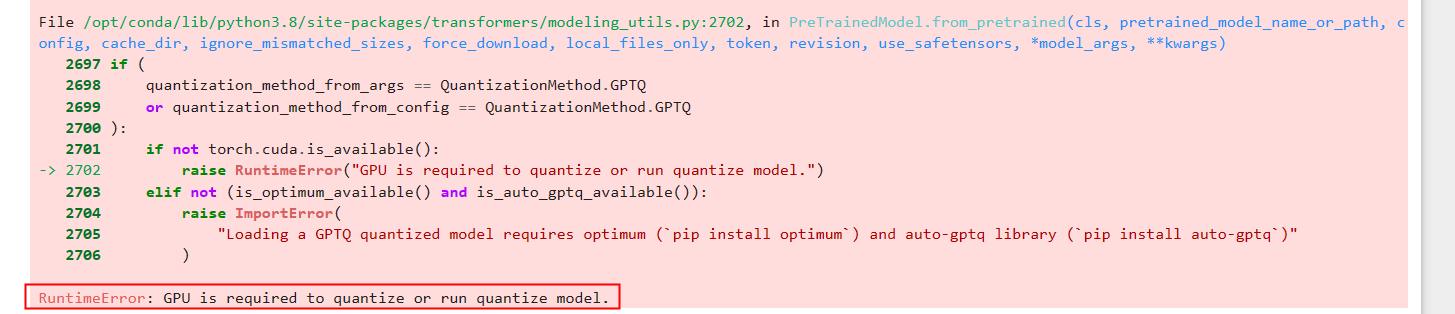

不完全是这样的。虽然 ModelScope 侧重于使用 GPU 推理,但也支持 CPU 推理。在 CPU 上部署量化模型有一些限制和注意事项,需要考虑如下几点:

在ModelScope中,CPU确实可以部署量化的模型。如果您没有GPU硬件,也可以在CPU上进行推理,但需要注意的是,推理速度可能会更慢。同时,您可以在ModelScope平台上针对模型部署信息进行配置,包括部署模型版本、部署地域、部署卡型、部署显存等。

对于您已经安装的optimum和auto-gptq包,这两个包都是基于GPTQ算法的大语言模型量化工具包,使用它们可以更方便地进行模型推理和训练。安装完成后,您可以在Transformers中运行GPTQ模型,例如:从transformers模块导入AutoModelForCausalLM,然后使用from_pretrained方法加载预训练的模型。如果您使用的是CUDA 11.7或11.8,还可以通过pip install auto-gptq --extra-index-url命令来快速安装与PyTorch 2.0.1相兼容的AutoGPTQ的预构建轮子文件。