Flink CDC中oracle按照官网开启日志归档后, oracle没有数据操作,但是磁盘一直在暴增这个可能是啥情况?出现了很多的 .arc文件~~~~事实上并没有对数据库有频繁操作,oracle的归档操作

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

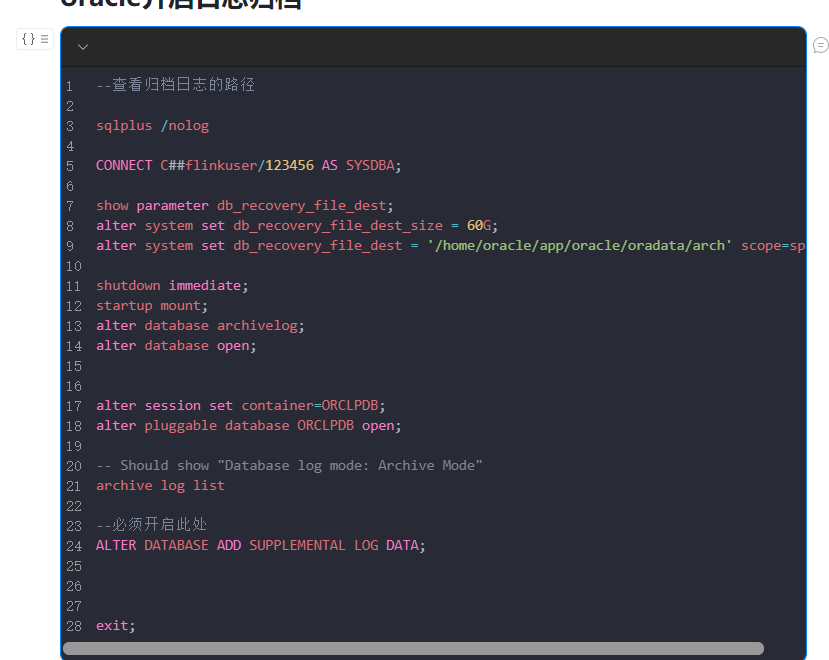

在Apache Flink CDC(Change Data Capture)与Oracle数据库集成的场景中,如果你发现即使没有进行频繁的数据操作,Oracle数据库的磁盘空间仍在持续增长,这可能与Oracle的归档日志机制有关。这里有几个可能的原因和相应的建议:

Oracle归档日志配置:当你开启了Oracle的日志归档模式(Archive Log Mode),Oracle会将重做日志文件(redo logs)在填满后自动归档,即使数据变化不大,只要数据库运行,就会产生一定量的重做日志。这些归档日志以.arc为扩展名存储。确保你的归档日志策略(如保留周期、归档目标位置等)设置得当,避免不必要的日志积累。

Flink CDC配置:检查Flink CDC连接器的配置,确保它正确地指定了处理历史数据的方式。如果配置不当,可能导致Flink CDC不断读取并保持对旧日志的引用,间接导致归档日志不被清理或循环利用。

日志切换频率:Oracle数据库的重做日志组会在填满时触发切换,即使数据操作不多,某些活动(如定期维护任务、统计信息收集等)也可能导致日志切换,进而生成新的归档日志。

问题排查:

RMAN或SQL*Plus查询当前的归档日志状态和配置。V$ARCHIVE_LOG视图来监控归档日志的生成情况。解决方案:

LOG_ARCHIVE_DEST_n参数指定多个归档目的地,并考虑使用LOG_ARCHIVE_MAX_PROCESSES增加归档进程数以提高效率。如果问题依然存在,建议深入分析数据库活动日志和监控指标,或者咨询Oracle数据库管理员或技术支持获取更专业的帮助。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。