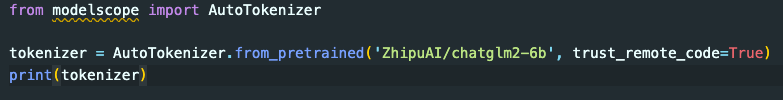

我调用ModelScope的AutoTokenizer,为什么会去huggingface下载模型呢?

【 我调用ModelScope的AutoTokenizer,为什么会去huggingface下载模型呢?

】

ModelScope底层使用HuggingFace Transformers实现模型加载和推理功能。

Transformers提供了大量预训练语言模型,直接从官网下载能获得最新版本。

ModelScope未自己维护那么多预训练模型,下载速度更快不占用资源。

HuggingFace是开源社区首推的预训练模型库,质量和兼容性得到广泛认可。

通过HuggingFace获取模型,可以和他们生态中的其他库无缝兼容。

ModelScope也可以选择将部分热门模型镜像到自己服务器,但增量模型需从来源下载。

未来也可能考虑直接整合部分Transformer模型,但兼容性是首要考量。

所以总体来说,利用HuggingFace这个开源领域的资源存储点,可以更高效地实现模型加载,也更容易与生态界保持兼容。

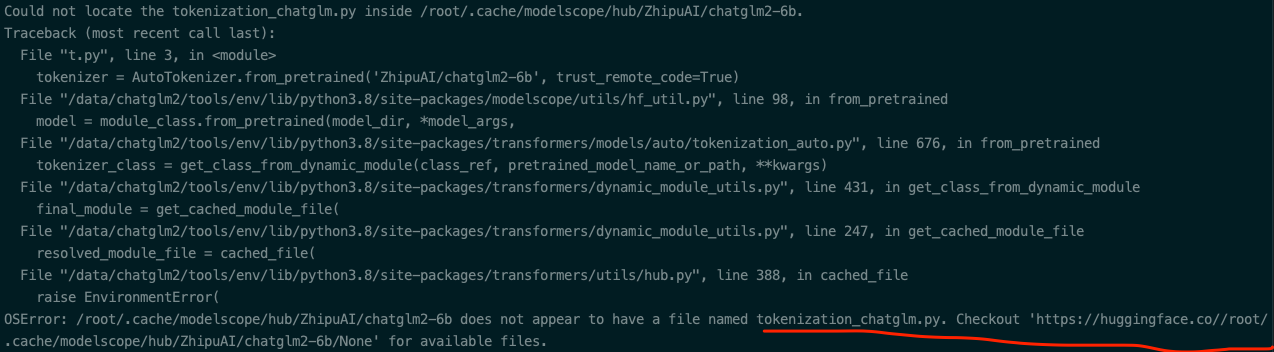

chatglm26b您可以使用from modelscope.models.nlp import ChatGLM2Tokenizer吧,这个问题我们最近会修复-此回答整理自钉群“魔搭ModelScope开发者联盟群 ①”