DataWorks基础属性:调度参数自定义参数:系统内置参数?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在DataWorks中,调度参数是用于配置任务调度行为和传递参数值的属性。其中,自定义参数是你可以在任务或节点中定义的参数,用于传递自定义数值或字符串等值。这些自定义参数可以在任务运行时通过调度参数进行配置和传递。

在DataWorks的调度参数中,除了自定义参数,还有系统内置参数。系统内置参数是由DataWorks提供的预定义参数,用于表示任务的一些系统信息或运行时的环境变量等。这些系统内置参数在任务运行时会自动赋值,而无需手动配置。

以下是一些常见的DataWorks系统内置参数:

bizdate:表示任务的业务日期,通常用于在任务中处理特定日期的数据。

offset:表示任务的偏移量,用于在任务中处理增量数据或分批处理数据。

taskid:表示任务的唯一标识符,可以用于识别任务的执行情况和日志等。

runtime:表示任务的运行时间,通常用于记录任务的执行时间和统计信息。

在DataWorks中,调度参数自定义参数是一种用于在任务调度过程中传递参数的功能。系统内置参数是DataWorks预先定义的一些特殊参数,用于提供与任务调度和执行相关的信息。

以下是一些常见的系统内置参数:

$bizdate:代表当前业务日期(按照调度周期确定)。它可以用于在任务中根据当前日期执行相应的逻辑。

$latestTaskStatus:代表上游依赖任务的状态,可以用于判断上一个任务是否成功执行。

$nodeId:代表当前节点的ID,可用于在任务中获取当前节点的一些属性或执行特定操作。

$runtime:代表任务的运行时间戳,即任务开始执行的时间。

$unixtimestamp:代表任务运行时间的UNIX时间戳形式,表示从1970年1月1日起的秒数。

这些系统内置参数可以通过${参数名}的形式在任务代码或配置中使用。DataWorks会在任务调度和执行时将其替换为实际的值。

除了系统内置参数,你还可以在DataWorks中定义自定义参数,以便更灵活地传递和使用额外的参数。自定义参数可以在任务的调度设置中配置,并在任务代码或配置中通过${参数名}的方式进行引用。

通过使用系统内置参数和自定义参数,你可以在任务的调度和执行过程中,动态地传递和使用各种参数值,以满足任务的需求。

细分类型内置参数 定义

$bizdate 业务日期,格式为yyyymmdd。 该参数的应用较为广泛,日常调度中默认运行时间的前一天为业务日期。

$cyctime 任务的定时时间,格式为yyyymmddhh24miss。

$gmtdate 当前日期,格式为yyyymmdd。 该参数默认为当天日期,补数据时传入的是业务日期+1。

$bizmonth 业务月份,格式为yyyymm。

$jobid 任务所属的业务流程ID。

$nodeid 节点ID。

$taskid 任务ID,即节点实例ID。赋值引用要求(ODPS SQL节点、离线同步节点、PyODPS节点)

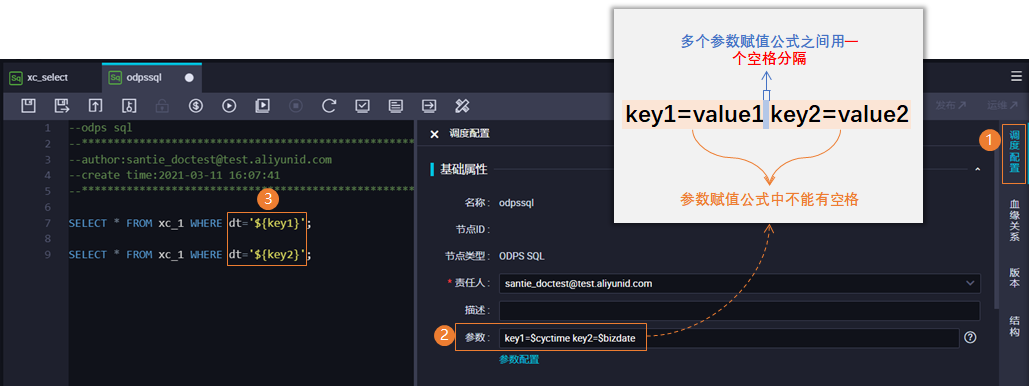

需要在调度配置 > 基础属性中的参数中赋值,需使用多个调度参数时,各个参数间使用一个空格分隔。赋值的格式为:key1=value1 key2=value2,其中key1、key2是自定义的参数名称,value1、value2是系统内置参数,DataWorks当前可用的系统内置参数列表可参见上述表格表 1。引用格式为:ODPS SQL节点、EMR类型节点和离线数据同步节点 直接引用unknown、unknown,其中key1和key2是自定义的参数名称。例如,dt=unknown。

PyODPS节点 在全局变量中增加一个名为args的字典对象:args=['key1'] args=['key2']。其中key1和key2是自定义的参数名称。赋值引用要求(通用Shell节点)赋值格式为:value1 value2,其中value1、value2是系统内置参数,DataWorks当前可用的系统内置参数列表可参见上述表格表 1。引用格式 在代码中引用变量$1,$2 ...。说明 EMR Shell节点和EMR Spark Shell节点,请参考ODPS SQL节点引用方式。

https://help.aliyun.com/document_detail/137548.html

,此回答整理自钉群“DataWorks交流群(答疑@机器人)”

DataWorks基于MaxCompute/Hologres/EMR/CDP等大数据引擎,为数据仓库/数据湖/湖仓一体等解决方案提供统一的全链路大数据开发治理平台。