问题一:请问下Modelscope这个是 gpu的内存溢出吗?

问题二:我这边是一张3090的卡,想跑baichuan-13b的 量化int4的 模型,单卡可以跑起来吗?

如果您在使用 ModelScope 过程中遇到了 GPU 内存溢出的问题,可能有以下几个原因和解决方法:

模型大小超过可用 GPU 内存:某些深度学习模型可能具有较大的参数量,需要更多的 GPU 内存才能加载和运行。如果您的模型太大而无法适应可用的 GPU 内存,就会导致内存溢出错误。解决方法可以是降低模型的规模,或者考虑使用更强大的 GPU 或分布式训练来处理更大的模型。

数据批处理过大:如果您一次性将大批量的数据加载到 GPU 内存中进行处理,也可能导致内存溢出。尝试减小数据批次的大小,或者采用分批处理的方式来逐步将数据加载到 GPU 内存中。

内存泄漏或资源管理问题:有时候 GPU 内存溢出问题可能是由于代码中存在内存泄漏或资源管理不当导致的。确保在每次完成模型推理或训练后,及时释放 GPU 内存,并检查代码是否正确地管理了 GPU 内存资源。

其他系统配置问题:除了上述情况外,其他系统配置问题(如驱动程序、CUDA 版本等)也可能导致 GPU 内存溢出。确保您的系统配置符合模型和框架的要求,并根据需要进行更新或调整。

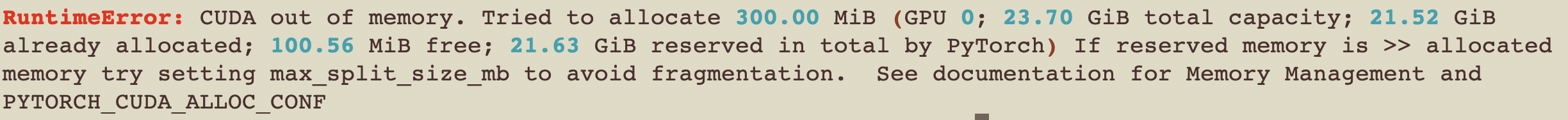

这个错误提示显示了CUDA内存不足,因此很可能是GPU的内存溢出导致的。具体来说,该错误提示显示了在GPU 0上尝试分配300.00 MiB的内存时,CUDA内存已经被占用了21.52 GiB,只有100.56 MiB的空闲内存可用,因此无法分配所需的内存。另外,该错误提示建议您可以尝试设置最大分割大小以避免内存碎片,并参考内存管理和PYTORCH CUDA ALLOC CONF的文档进行配置。

为了解决这个问题,您可以尝试以下几个方法:

减少batch size:减少每次训练时的batch size可以减少GPU内存的使用量,从而避免内存溢出的问题。可以通过调整模型配置文件或训练脚本中的batch size参数来实现。

降低模型复杂度:如果模型过于复杂,可能会导致GPU内存不足而无法训练。可以尝试减小模型的规模或使用更简单的模型来解决这个问题。

增加GPU内存:如果您的GPU内存不足,可以考虑升级显卡或增加显存。另外,也可以使用多个GPU来并行训练,从而提高训练效率。

使用分布式训练:使用分布式训练可以将模型的训练任务分布到多个机器或多个GPU上,从而减少单个GPU的内存压力。可以使用PyTorch提供的分布式训练工具来实现。