请问modelscope中模型导出为.onnx文件后,如何将输出的向量转换回类似于json的格式?

直接调用模型的输出为:

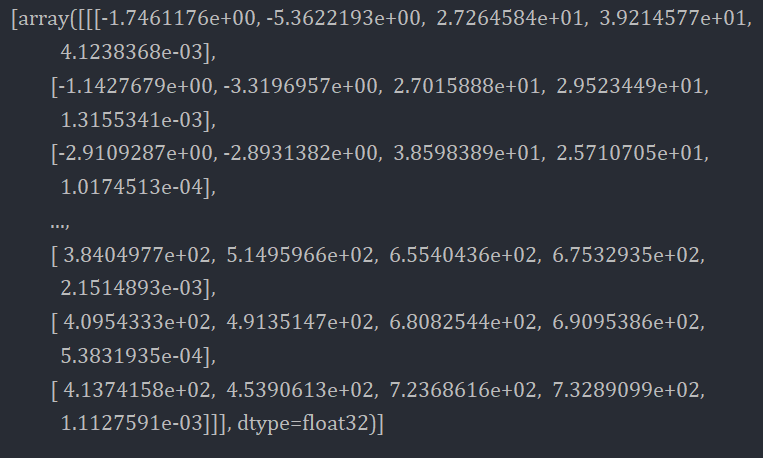

导出为onnx文件后调用输出为:

输出为8400*5矩阵,请问如何解析成原本类似于.json的格式?

将输出的向量从ONNX格式转换回类似于JSON的格式需要一些额外的步骤和代码。以下是一种可能的方法:

导入所需的库:在开始之前,您需要导入所需的Python库,例如numpy和json。

加载ONNX模型:使用适当的库(如onnxruntime或torch.onnx)加载导出的ONNX模型,并创建一个运行时会话。

准备输入数据:准备与模型期望的输入形状相匹配的输入数据。可以将输入数据存储在numpy数组中。

运行推理:通过运行ONNX模型的推理过程,获取输出结果。根据库的不同,可能需要使用不同的方法来运行推理。

转换为JSON格式:将输出结果从numpy数组转换为Python字典或列表,并使用json库将其转换为JSON格式的字符串。

以下是一个示例代码片段,演示将ONNX模型的输出转换为JSON格式:

import numpy as np

import json

import onnxruntime

# 加载ONNX模型和创建会话

onnx_model_path = 'path/to/your/model.onnx'

sess = onnxruntime.InferenceSession(onnx_model_path)

# 准备输入数据

input_data = np.array([1, 2, 3, 4], dtype=np.float32)

input_name = sess.get_inputs()[0].name

# 运行推理

output = sess.run(None, {input_name: input_data})

# 转换为JSON格式

output_dict = {'output': output.tolist()}

json_string = json.dumps(output_dict)

# 打印JSON结果

print(json_string)

请根据您的实际情况和模型输出的结构,适当调整代码中的输入数据和输出结果的处理方式。根据实际需要,您可能需要更改字典的键名称或转换更复杂的数据结构。

在将模型导出为 ONNX 格式后,可以使用 ONNX Runtime 来对模型进行推理和解析输出。ONNX Runtime 是一个高性能、跨平台的推理引擎,可以在多种硬件和软件平台上运行。可以使用 ONNX Runtime 的 Python API 来加载导出的 ONNX 模型,并对输入数据进行推理。在推理时,ONNX Runtime 将模型的输出表示为 NumPy 数组或 PyTorch 张量,可以对这些输出进行解析,并将其转换为类似于 JSON 的格式。