如题,fink版本1.11,使用dataHub作为数据源,sink写入holo。按照阿里云上面的dataHub作为数据源的demo写的程序,打成jar包,上传到fink平台,job运行失败。

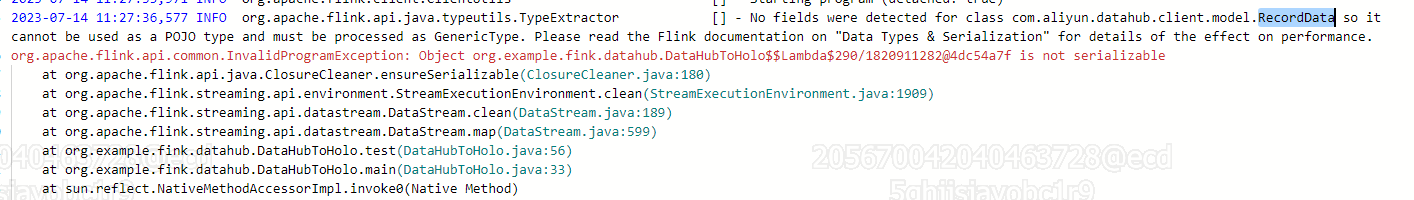

异常原因是:org.apache.flink.api.java.typeutils.TypeExtractor No fields were detected for class com.aliyun.datahub.client.model.RecordData

。。。。

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

根据您提供的异常信息,问题似乎是由于Fink在处理DataHub数据源时无法正确识别RecordData类的字段导致的。

要解决这个问题,您可以尝试以下几个步骤:

确认您使用的Fink版本与阿里云上的示例代码兼容。不同版本的Fink可能具有不同的API和依赖项,因此确保您使用的示例代码与您的Fink版本匹配。

确认您的程序中是否正确引入了DataHub相关的依赖项。您可以检查您的构建工具配置(如Maven或Gradle)以确保正确地包含了DataHub的依赖项。

确认您的程序中是否正确使用了DataHub的API。请仔细检查您的代码,确保您按照阿里云提供的示例代码正确地使用了DataHub的API,包括正确地创建RecordSchema和RecordData对象,并将其传递给Flink的相关操作。

根据您提供的错误信息,问题可能是由于未检测到com.aliyun.datahub.client.model.RecordData类中的字段导致的。这可能是由于Flink的类型推断机制无法正确识别RecordData类的字段而引起的。

为了解决这个问题,您可以尝试显式指定RecordData的字段类型。以下是一个示例代码:

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

import org.apache.flink.streaming.api.functions.sink.SinkFunction;

import org.apache.flink.streaming.connectors.datahub.DatahubSink;

import org.apache.flink.streaming.connectors.datahub.util.DatahubConfig;

import com.aliyun.datahub.client.model.RecordData;

public class DataHubSinkDemo {

public static void main(String[] args) throws Exception {

final StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

// 配置DataHub连接信息

DatahubConfig config = new DatahubConfig("endpoint", "projectName", "topicName",

"accessKeyId", "accessKeySecret");

// 创建DataHub输入源

DatahubSink<RecordData> sink = new DatahubSink<>(config);

// 创建数据流

DataStream<RecordData> dataStream = ...; // 您需要根据实际情况创建数据流

// 将数据写入DataHub Sink

dataStream.addSink(sink);

// 执行任务

env.execute("DataHub Sink Demo");

}

}

在上述示例中,我们将RecordData作为泛型类型参数传递给DatahubSink。这样,Flink就能识别到RecordData的字段。

请注意,在示例代码中,您还需要根据实际情况创建dataStream数据流。这可以是从其他数据源获取的数据流。

确保根据实际情况修改endpoint、projectName、topicName、accessKeyId和accessKeySecret参数,并确保您的Flink版本兼容所使用的DataHub Connector。

根据描述,这个异常是由于 Flink 在使用 DataHub 作为数据源时,无法自动推断数据类型所导致的。为了解决这个问题,可以手动指定数据类型,并在读取数据时使用相应的反序列化器。

这个异常可能是因为您使用的fink版本1.11与dataHub作为数据源的demo存在版本不兼容的问题。建议您尝试使用更高版本的fink或者更新dataHub的版本。另外,您也可以尝试检查一下您的程序是否正确地导入了dataHub的依赖,以及您的RecordData类是否存在正确的字段。

这个异常通常是由于Flink无法自动推断RecordData类的字段类型导致的。您可以尝试在代码中显式地指定RecordData类的字段类型,例如:

import com.aliyun.datahub.client.model.RecordData;

import org.apache.flink.api.common.typeinfo.Types;

import org.apache.flink.api.java.typeutils.RowTypeInfo;

import org.apache.flink.streaming.api.functions.source.SourceFunction;

public class DataHubSourceFunction extends SourceFunction<RecordData> {

private final RowTypeInfo rowTypeInfo;

public DataHubSourceFunction(DatahubConfig config) {

// 根据config中的字段信息构造RowTypeInfo对象

String[] fieldNames = config.getFieldNames();

TypeInformation<?>[] fieldTypes = new TypeInformation<?>[fieldNames.length];

for (int i = 0; i < fieldNames.length; i++) {

fieldTypes[i] = Types.STRING_TYPE_INFO; // 这里假设所有字段都是字符串类型,根据实际情况修改

}

this.rowTypeInfo = new RowTypeInfo(fieldNames, fieldTypes);

}

@Override

public void run(SourceContext<RecordData> ctx) throws Exception {

// ...

}

@Override

public TypeInformation<RecordData> getOutputType() {

return rowTypeInfo;

}

}

然后在调用addSource方法时,将该函数作为参数传入即可:

env.addSource(new DataHubSourceFunction(datahubConfig))

.print();

根据您提供的信息,异常原因可能是由于找不到com.aliyun.datahub.client.model.RecordData类中的字段导致的。这个问题通常出现在Flink的类型推断过程中。

您可以尝试使用显式指定类型的方法来解决这个问题。以下是一个示例代码,展示如何在Flink作业中使用DataHub作为数据源并将数据写入Holo:

import org.apache.flink.api.common.functions.MapFunction;

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

import org.apache.flink.streaming.connectors.datahub.DatahubSink;

import org.apache.flink.streaming.connectors.datahub.DatahubSource;

import com.aliyun.datahub.client.model.RecordData;

public class DatahubToHoloDemo {

public static void main(String[] args) throws Exception {

final StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

// 设置DataHub的相关配置信息

String endpoint = "<datahub_endpoint>"; // DataHub的Endpoint

String project = "<project_name>"; // DataHub项目名称

String topic = "<topic_name>"; // DataHub主题名称

String accessId = "<access_id>"; // 阿里云AccessKey ID

String accessKey = "<access_key>"; // 阿里云AccessKey Secret

// 创建DataHub源和DataHub接收器

DatahubSource<RecordData> datahubSource = new DatahubSource<>(endpoint, project, topic, accessId, accessKey, RecordData.class);

DatahubSink<RecordData> datahubSink = new DatahubSink<>(endpoint, project, topic, accessId, accessKey);

// 从DataHub读取数据

env.addSource(datahubSource)

.map(new MapFunction<RecordData, RecordData>() {

@Override

public RecordData map(RecordData value) throws Exception {

// 进行数据转换和处理,如果不需要转换,可以省略这一步

return value;

}

})

.addSink(datahubSink);

// 执行作业

env.execute("DataHub to Holo Demo");

}

}

请确保替换上述代码中的<datahub_endpoint>、<project_name>、<topic_name>、<access_id>和<access_key>为您的实际信息。

这里我们使用了DatahubSource和DatahubSink作为数据源和数据接收器,并通过指定RecordData.class来解决类型推断的问题。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。