问题1:Flink CDC中怎么拿到kafka以debezium-json格式 op字段数据?

问题2:不能用debezium-json格式拿op字段数据吗

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

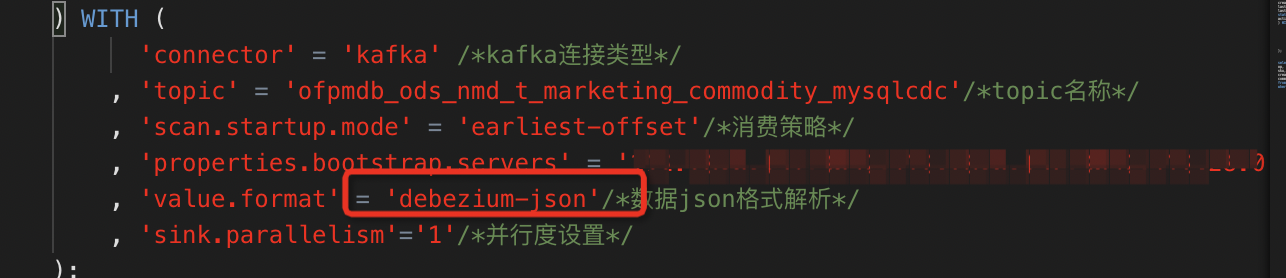

在 Flink CDC 中,使用 Debezium 格式的 Kafka 数据源时,可以通过解析 JSON 格式的消息来获取 op 字段的值。以下是一个示例代码,演示如何使用 Flink CDC 获取 op 字段的值:

java

Copy

import org.apache.flink.api.common.functions.MapFunction;

import org.apache.flink.api.common.typeinfo.TypeInformation;

import org.apache.flink.api.java.typeutils.TypeExtractor;

import org.apache.flink.streaming.api.datastream.DataStream;

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

import org.apache.flink.streaming.connectors.kafka.FlinkKafkaConsumer;

import org.apache.flink.table.api.EnvironmentSettings;

import org.apache.flink.table.api.bridge.java.StreamTableEnvironment;

import org.apache.flink.types.Row;

import java.util.Properties;

public class KafkaDebeziumJsonExample {

public static void main(String[] args) throws Exception {

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

EnvironmentSettings settings = EnvironmentSettings.newInstance().inStreamingMode().build();

StreamTableEnvironment tableEnv = StreamTableEnvironment.create(env, settings);

Properties properties = new Properties();

properties.setProperty("bootstrap.servers", "localhost:9092");

properties.setProperty("group.id", "test-group");

properties.setProperty("auto.offset.reset", "earliest");

DataStream<String> kafkaStream = env.addSource(new FlinkKafkaConsumer<>("test-topic", new SimpleStringSchema(), properties));

DataStream<Row> rows = kafkaStream.map(new MapFunction<String, Row>() {

@Override

public Row map(String value) throws Exception {

// 将 JSON 格式的消息解析成 Row 对象

Row row = (Row) TypeInformation.of(Row.class).createSerializer(null).deserialize(value.getBytes());

// 获取 op 字段的值

String op = row.getField(2).toString();

return row;

}

});

tableEnv.createTemporaryView("kafka_table", rows, "id, name, op");

// 执行 SQL 查询

tableEnv.executeSql("SELECT id, name, op FROM kafka_table WHERE op = 'c'").print();

}

}

在这个示例中,我们使用 Flink 的 Kafka 连接器读取 Kafka 的消息,并将其转换为 Row 对象。然后,我们可以通过获取 Row 对象的第三个字段来获取 op 字段的值。

根据您提供的信息,Flink CDC 默认情况下无法直接从 Kafka 中获取到以 Debezium JSON 格式的 "op" 字段数据。Flink CDC 通常会将读取的 CDC 数据解析为 Flink 的 DataStream,并且默认情况下不提供 Debezium JSON 特定的字段。

回答问题1:拿不到 "op" 字段数据以 Debezium JSON 格式

如果您需要在 Flink CDC 中使用 Debezium JSON 格式并访问 "op" 字段数据,您可以考虑以下两种方式:

1. 使用 Flink 的 JSON 解析库:将 CDC 数据解析为 Flink 的 DataStream 后,可以使用 Flink 提供的 JSON 解析库来处理 Debezium JSON。通过解析 JSON 数据,您可以访问和提取 "op" 字段数据。

2. 自定义转换函数:您可以编写自定义的 Flink 转换函数来处理 CDC 数据流。在转换函数中,您可以自行解析 JSON 数据并提取出所需的字段,包括 "op" 字段。

回答问题2:Debezium JSON 格式不能直接获取 "op" 字段数据

默认情况下,Flink CDC 可能不提供直接获取 Debezium JSON 格式中的 "op" 字段数据的功能。如果您确实需要获得 "op" 字段数据,您可能需要对 Flink CDC 进行自定义修改。

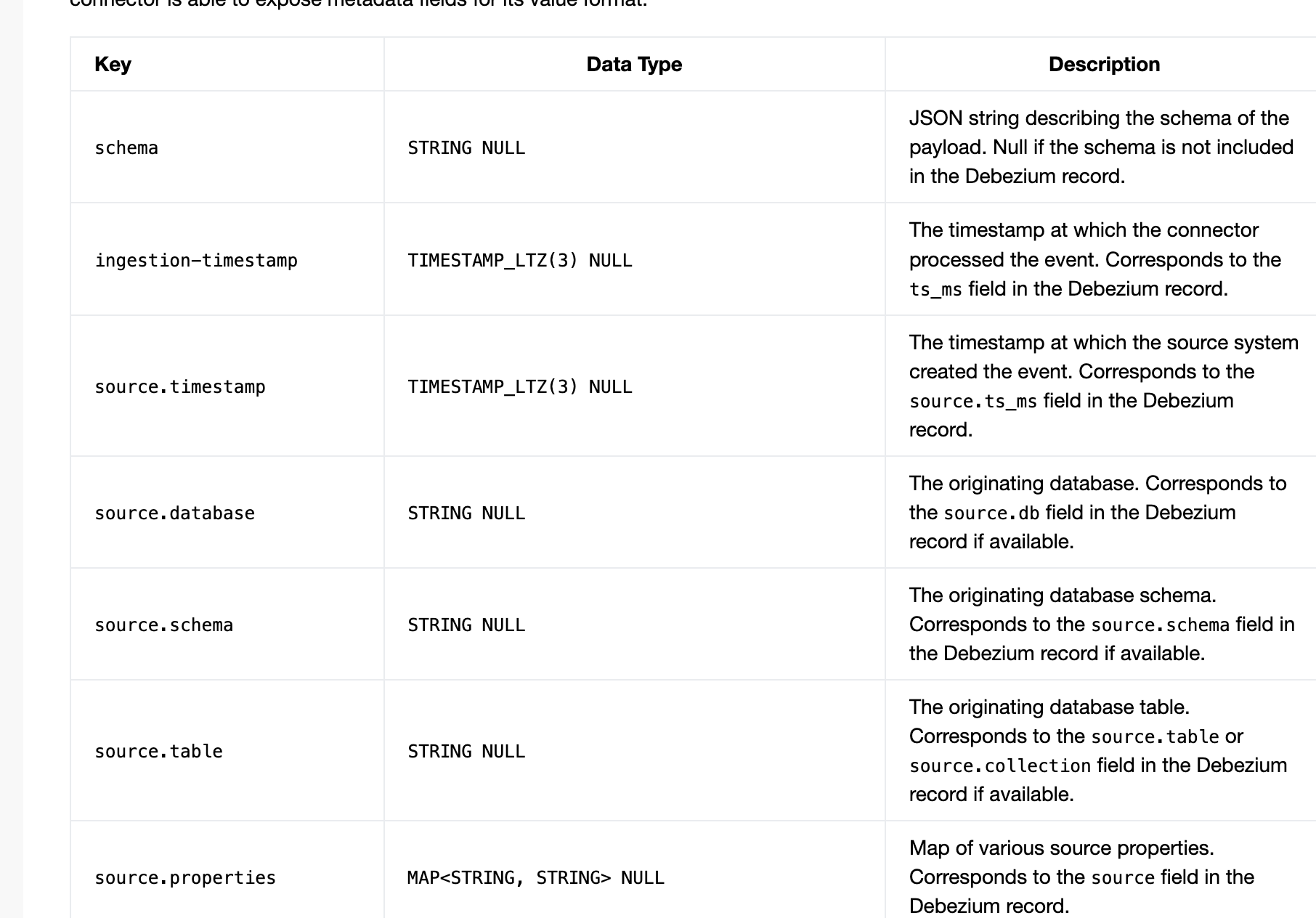

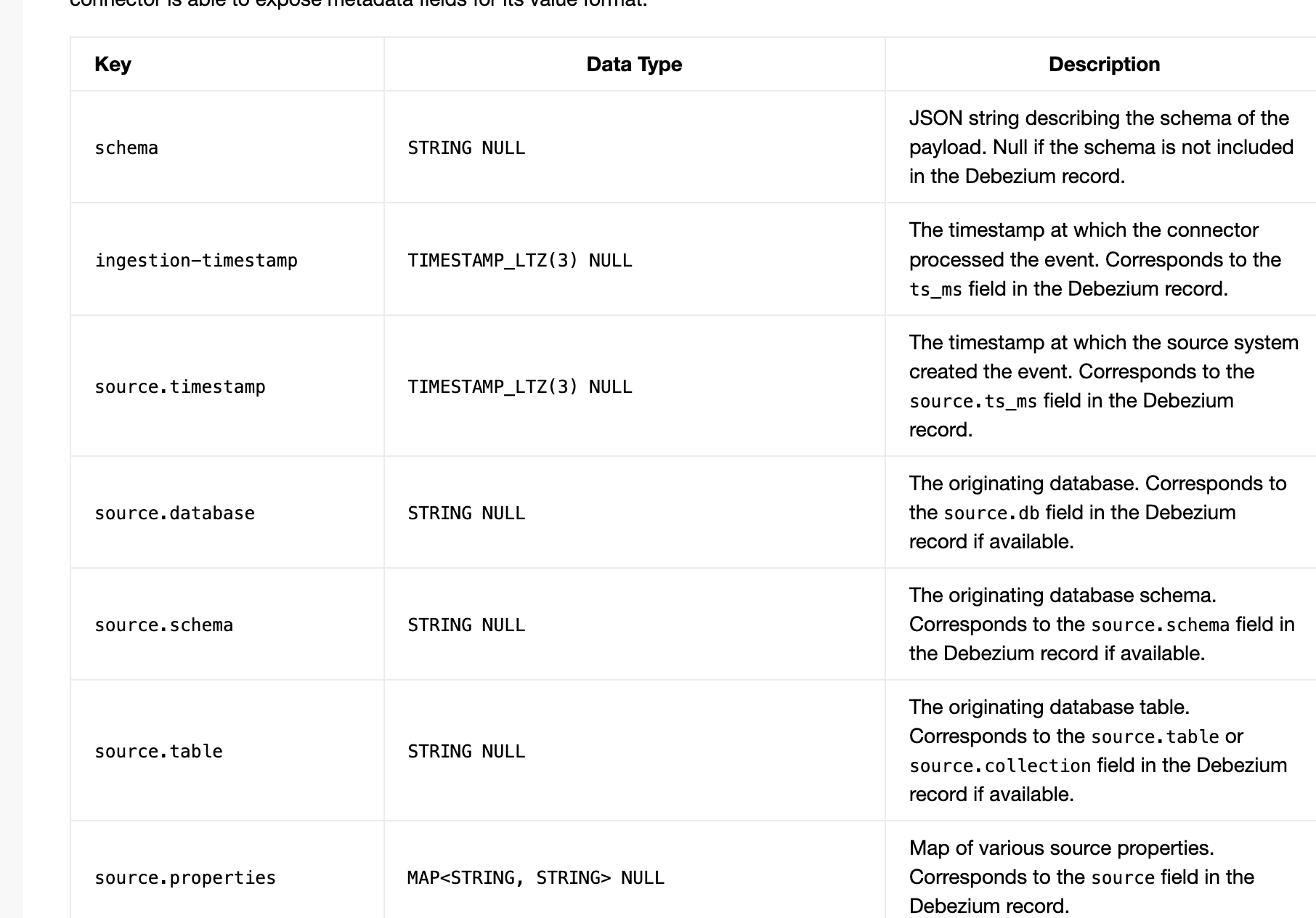

要实现这个目标,您可以尝试修改 Flink CDC 或 Debezium CDC 连接器的源码,以在生成的 JSON 数据中添加 "op" 字段。这样可以根据您的需求自定义化地处理 CDC 数据。

回答1:拿不到,只有json格式能拿到

回答2:拿不到,除非你自己改改,

你给他改改,加个op元数据进去,此回答整理自钉群“Flink CDC 社区”

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。