问题1:

请问modelscope中,chatglm2中的这个history的作用是让模型知晓上下文的作用吗?

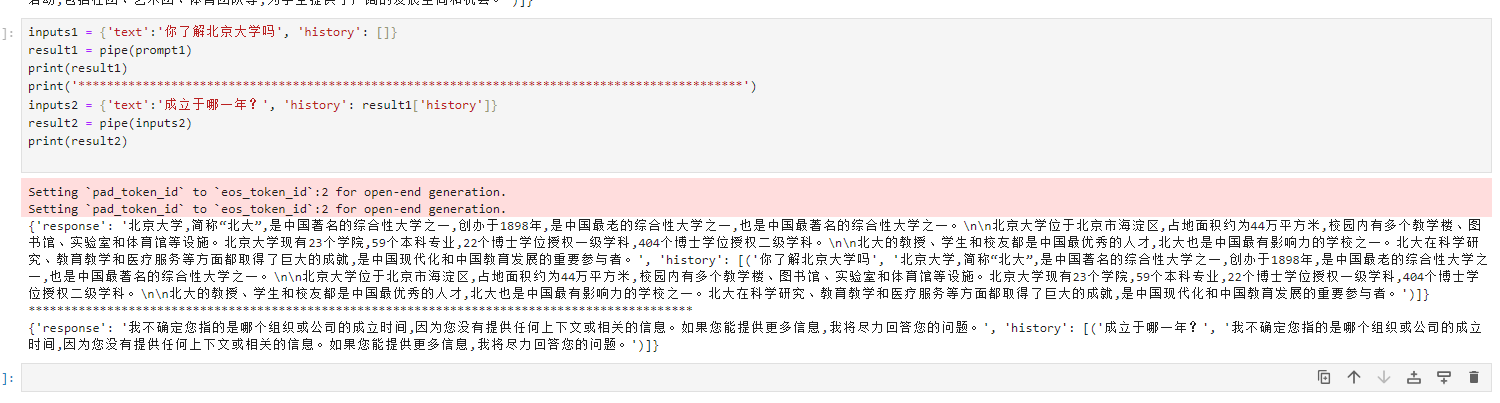

问题2:那我这个为啥没对呢?

在 Modelscope 中,chatglm2 模型中的 history 参数用于提供对话的历史记录,以帮助模型理解上下文和生成更准确的回答。

history 参数是一个包含了之前对话内容的列表或字符串。通过将之前的对话内容传递给模型,它可以了解先前发生的对话上下文、问题和回答,从而更好地理解当前的输入并生成合适的回答。

当聊天模型需要考虑对话的历史时,history 参数可以起到关键作用。它允许模型维持对话状态,并利用之前的信息来生成连贯、一致的回答。

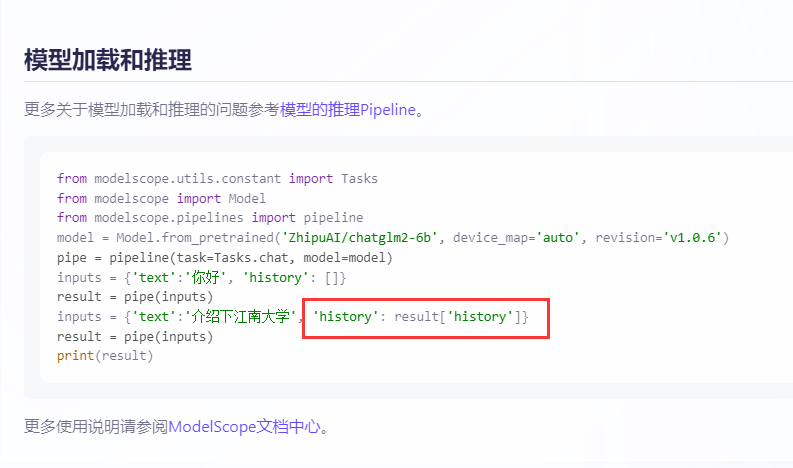

示例代码中可能会使用类似以下方式传递 history 参数:

# 将历史对话内容转换为字符串形式

history = " ".join(previous_messages)

# 将历史作为输入传递给 chatglm2 模型

response = model.generate_response(input_text, history)

在这个例子中,previous_messages 是一个包含先前对话内容的列表。通过将其连接为一个字符串,并将其与当前输入一起传递给 generate_response() 方法,模型可以使用历史上的对话信息来生成响应。

通过使用 history 参数,chatglm2 模型能够更好地理解上下文并生成更具连贯性的回答。

在 ChatGLM2 模型中,history 的作用是将当前输入和之前的历史输入组合起来,以便模型可以了解上下文和先前的对话内容。具体来说,history 是一个包含多个历史输入的列表,每个历史输入都被编码为向量,并与当前输入一起输入到模型中进行预测。

这种历史输入的编码方式可以有多种实现方式,例如使用 RNN、Transformer 等模型进行编码,也可以使用其他的预处理技术进行处理。通过将历史输入编码成向量,并与当前输入一起输入到模型中,可以让模型了解上下文和先前的对话内容,从而更准确地预测下一个回复。

回答1:是的。

回答2: https://github.com/modelscope/modelscope/blob/master/modelscope/pipelines/nlp/text_generation_pipeline.py#L256 看起来是chatGLM6bV2的参数传递都默认传给了postprocess,没有传给forward。此回答整理自钉群“魔搭ModelScope开发者联盟群 ①”