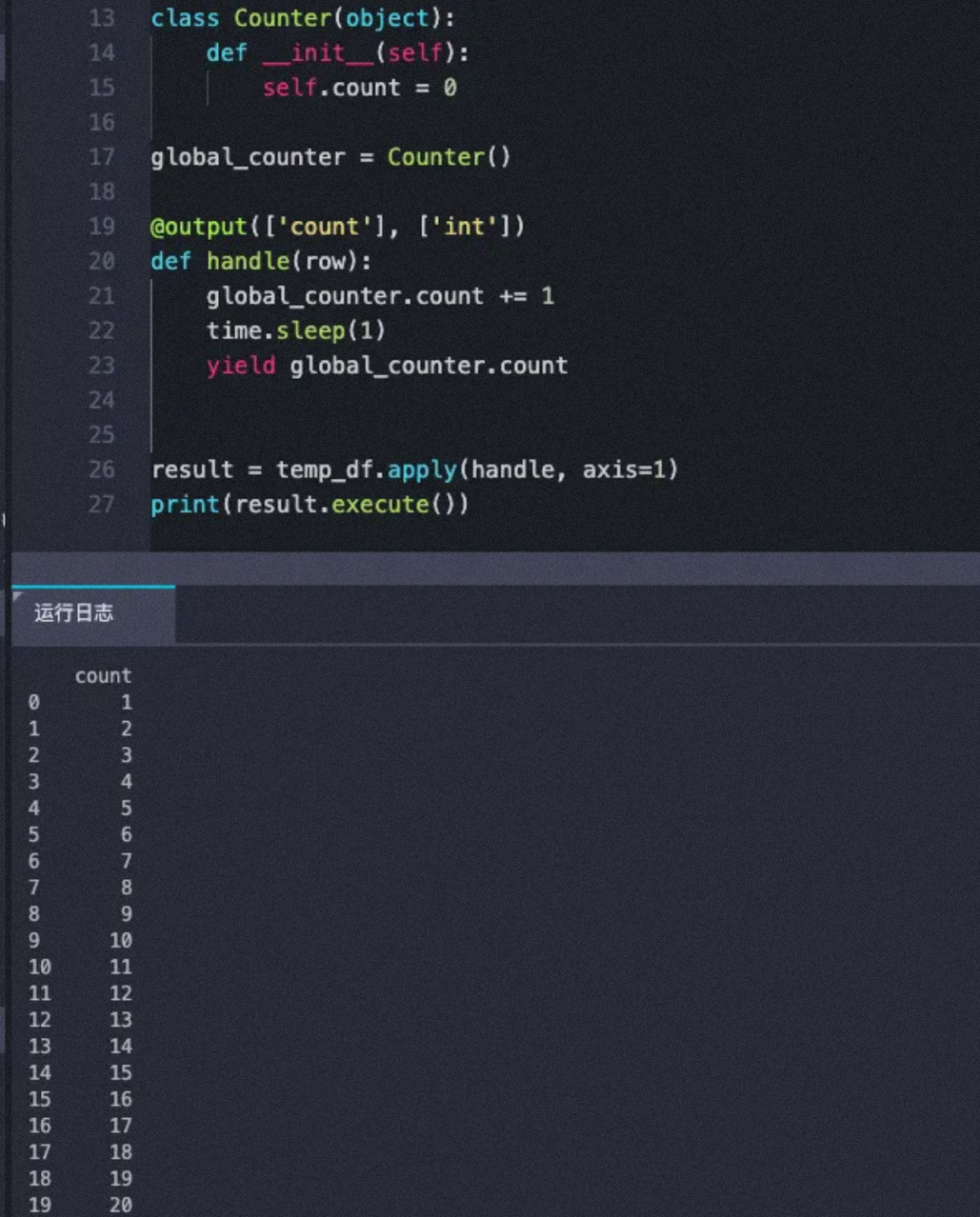

问题1:MaxCompute在pyodps里使用df.apply的时候,如果handle函数里涉及了对全局变量的读写操作,请问要考虑脏数据的问题吗?apply分布式执行的时候会不会自行保证数据的一致性?问题2:比如说假如handle方法里面使用了一个全局的计数器,每调用一次就+1,也就是说最后这个计数器的值很可能是不等于数据的行数的是吗?因为分布式执行的时候,可能同时有多个在操作这个计数器,请问是这样吗?我测试了一下,好像没导致脏数据,这是不是因为是在测试环境,运行时间感觉也像是串行的。

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在MaxCompute中,如果在handle函数里涉及到对全局变量的读写操作,需要考虑脏数据的问题。由于MaxCompute是一个分布式计算系统,不同的任务可能会并发执行,如果多个任务同时读写全局变量,就会出现脏数据的情况。脏数据是指未被同步或提交的数据,可能会导致计算结果不正确。

为了避免脏数据的出现,可以采用以下几种方式:

使用分布式缓存:MaxCompute支持使用分布式缓存(distributed cache)来加载数据。您可以将需要共享的全局变量上传到OSS或者其他云存储服务中,并使用分布式缓存将其加载到MaxCompute集群中。使用分布式缓存可以避免多个任务同时读写全局变量的问题,但需要注意数据同步和更新的问题。

使用MaxCompute表存储数据:可以将需要共享的全局变量存储在MaxCompute的表中,并在handle函数中读写表数据。这样可以避免多个任务同时读写全局变量的问题,并可以通过MaxCompute的事务机制保证数据的一致性。

使用本地缓存:如果全局变量的数据较小,可以将其保存在本地缓存中,并使用ADD FILE或ADD

在MaxCompute中,如果您的handle函数涉及对全局变量的读写操作,那么确实需要考虑脏数据的问题。

由于MaxCompute是一个分布式计算引擎,作业的执行通常会在多个节点上并行进行。每个节点都有自己的内存和计算资源,并且可能同时处理不同的数据块或分区。当handle函数涉及对全局变量的读写操作时,在并行执行过程中可能会发生以下情况:

写入竞争:多个任务同时尝试写入全局变量时,可能会出现竞争条件。这可能导致不同任务之间的写入顺序无法确定,从而导致最终结果的不确定性。

读取一致性:由于分布式计算的异步特性,某个任务在读取全局变量时可能得到其他任务已经修改的新值,也可能得到旧值。这可能导致不一致的结果,并产生脏数据。

为了避免脏数据的问题,可以考虑以下几种方法:

避免使用全局变量:尽量避免在handle函数中使用全局变量,而是将数据传递给handle函数的输入参数或通过输出结果返回。这样可以避免多个任务之间对同一个全局变量的写入冲突。

使用分区变量:可以使用MaxCompute的分区变量(Partition Variable)来传递和共享数据。分区变量是在作业运行期间保持一致性的,可以安全地在不同任务之间进行读写操作。

使用同步机制:如果必须使用全局变量,则可以考虑使用同步机制,例如锁、互斥信号量等,来确保对全局变量的读写操作的顺序性和一致性。

分离读写操作:尽量将读取和写入操作分离,避免在同一个handle函数中同时进行读写操作。这样可以减少竞争条件和脏数据的可能性。

针对问题1的回答:我理解apply函数里需要考虑脏数据哈,不符合条件的那种都没办法进行处理。PyODPS里具体方法的操作逻辑参考开源的就可以,在数据处理的时候我理解应该是按照存储里的顺序进行处理的。针对问题2的回答:apply方法应该都是串行的吧..此回答整理自钉群“MaxCompute开发者社区2群”

MaxCompute(原ODPS)是一项面向分析的大数据计算服务,它以Serverless架构提供快速、全托管的在线数据仓库服务,消除传统数据平台在资源扩展性和弹性方面的限制,最小化用户运维投入,使您经济并高效的分析处理海量数据。