大佬们 flinkcdc 能连翰高数据库吗?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

Flink CDC可以连接翰高数据库。

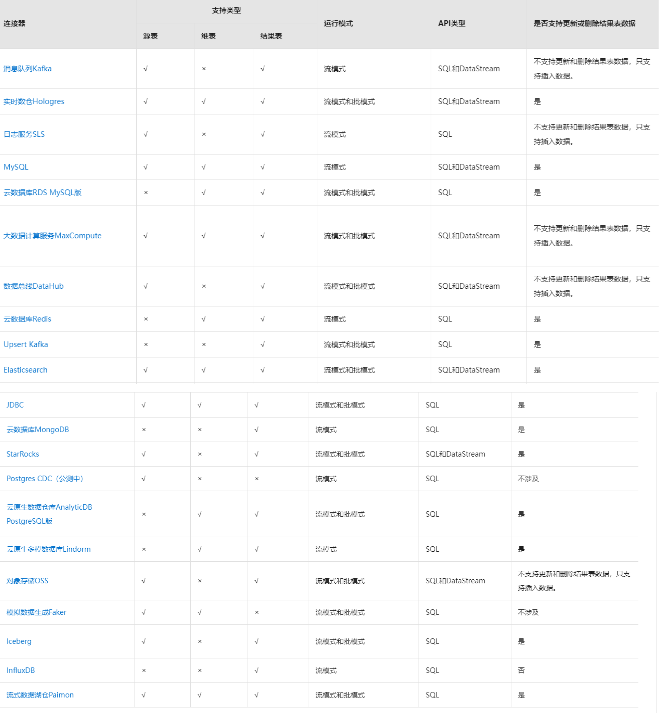

Flink CDC是一个用于连接和同步不同数据库的开源工具,它支持多种数据库类型,包括Oracle、MySQL、PostgreSQL等。虽然Flink CDC没有直接支持翰高数据库,但可以通过一些扩展机制来实现对翰高数据库的连接和同步。

如果您想使用Flink CDC连接翰高数据库,您可以通过以下步骤实现:

确保您已经安装了Flink CDC,并了解其工作原理和配置方式。

确认翰高数据库的版本和连接信息,包括数据库主机地址、端口号、用户名和密码等。

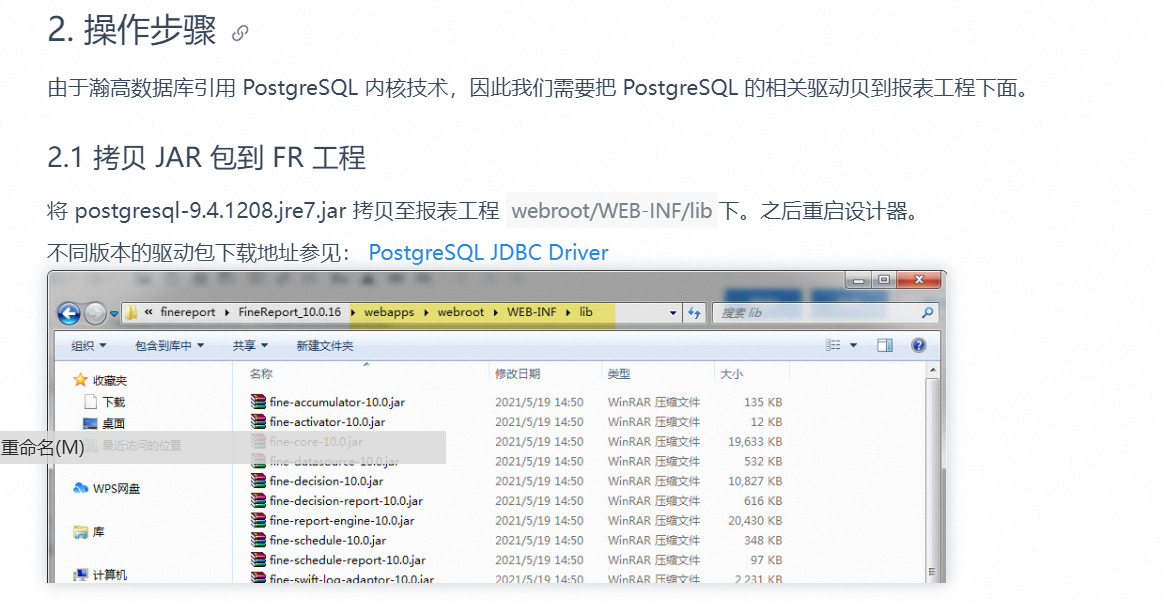

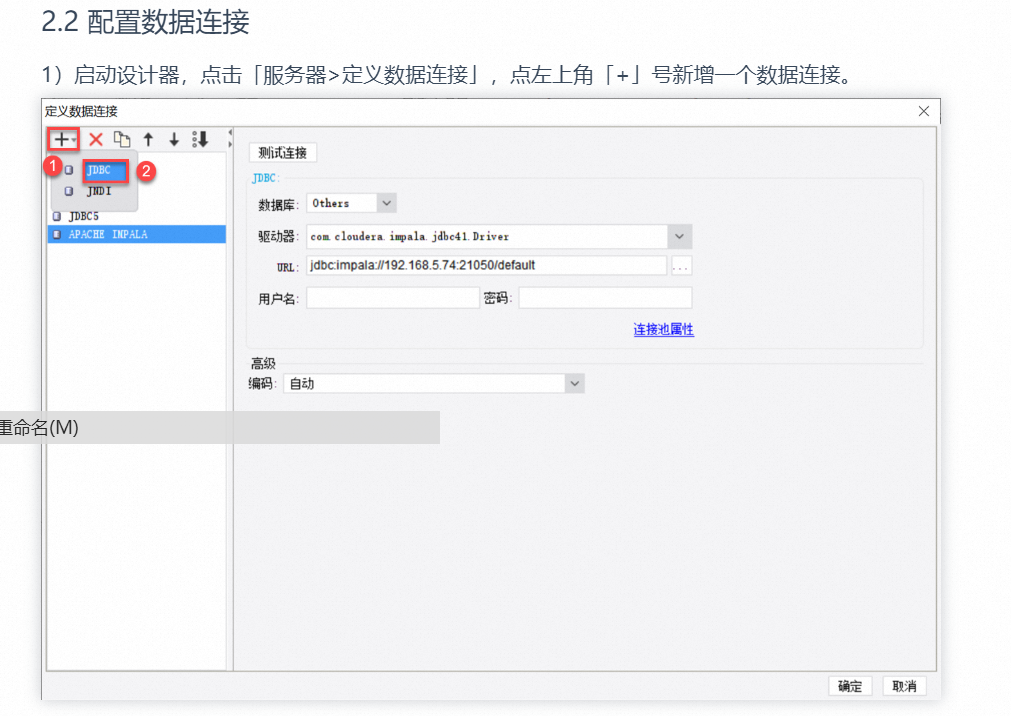

在Flink CDC的配置文件中,添加翰高数据库的连接信息,这通常涉及到指定数据库类型、驱动程序、连接URL、认证信息等。

如果翰高数据库需要特定的插件或驱动程序,您需要将相应的依赖项添加到Flink CDC的classpath中。

配置Flink CDC的启动命令,并指定要连接的数据库和相应的参数。

运行Flink CDC的作业,并确保它能够成功连接到翰高数据库,并开始进行数据同步。

需要注意的是,在使用Flink CDC连接翰高数据库时,您需要确保使用的翰高数据库连接驱动程序与您的Flink CDC版本兼容,并且翰高数据库的版本和配置也符合要求。同时,您还需要了解Flink CDC对不同数据库的支持程度和限制,以便更好地使用它来连接和同步您的数据。

可通过阿里云 Flink 的全量读取、Binlog 读取、CDC 读取、全增量一体化等多种方式,读取 Hologres 源表数据,无需额外组件,统一计算和存储,加速数据流转效率;

可通过阿里云 Flink 读取 Hologres 维表,助力高性能维表关联、数据打宽等多种应用场景;

阿里云 Flink 与 Hologres 元数据打通,通过 Hologres Catalog,实现元数据自动发现,极大提升作业开发效率和正确性。

Flink CDC(Change Data Capture)官方并没有明确提供与翰高数据库(HanGaoDB)的直接连接支持。Flink CDC主要用于与各种主流的关系型数据库(如MySQL、PostgreSQL、Oracle等)进行数据捕获和实时处理。

如果你需要将Flink与翰高数据库进行集成,你可以考虑以下几个方法:

自定义开发:你可以自行开发一个适配器或者数据源来连接翰高数据库,并使用Flink提供的DataStream API或Table API来进行数据处理和分析。

使用外部连接器:翰高数据库是否提供了自己的Flink连接器或者Kafka等消息队列连接器?如果是的话,你可以利用这些连接器将翰高数据库的数据传输到Flink进行实时处理。

数据导出/导入:你可以在翰高数据库中使用相应的工具,将需要处理的数据以某种格式(如CSV、JSON等)导出到外部存储系统(如HDFS、S3等),然后将该数据导入到Flink进行处理和分析。

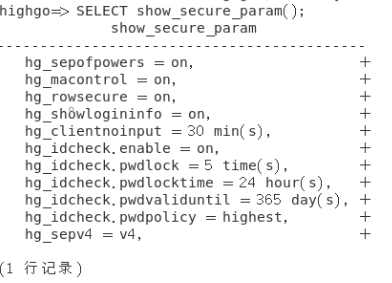

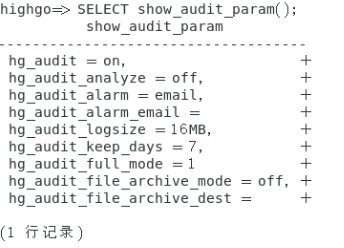

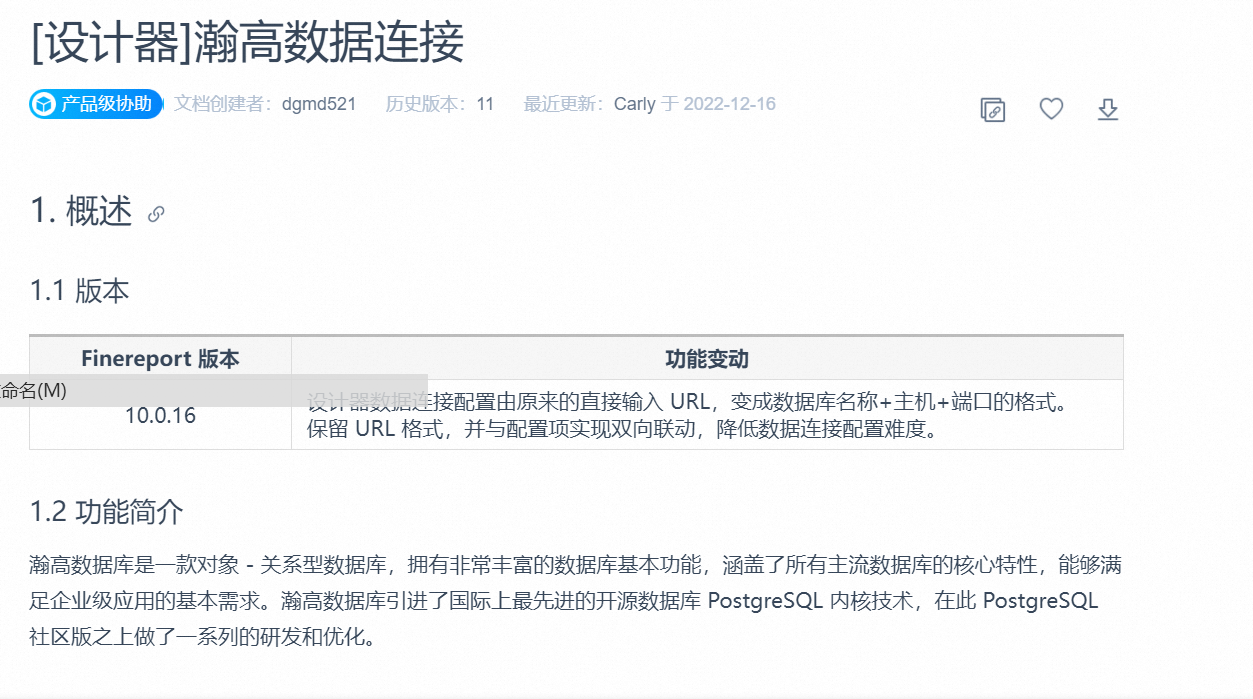

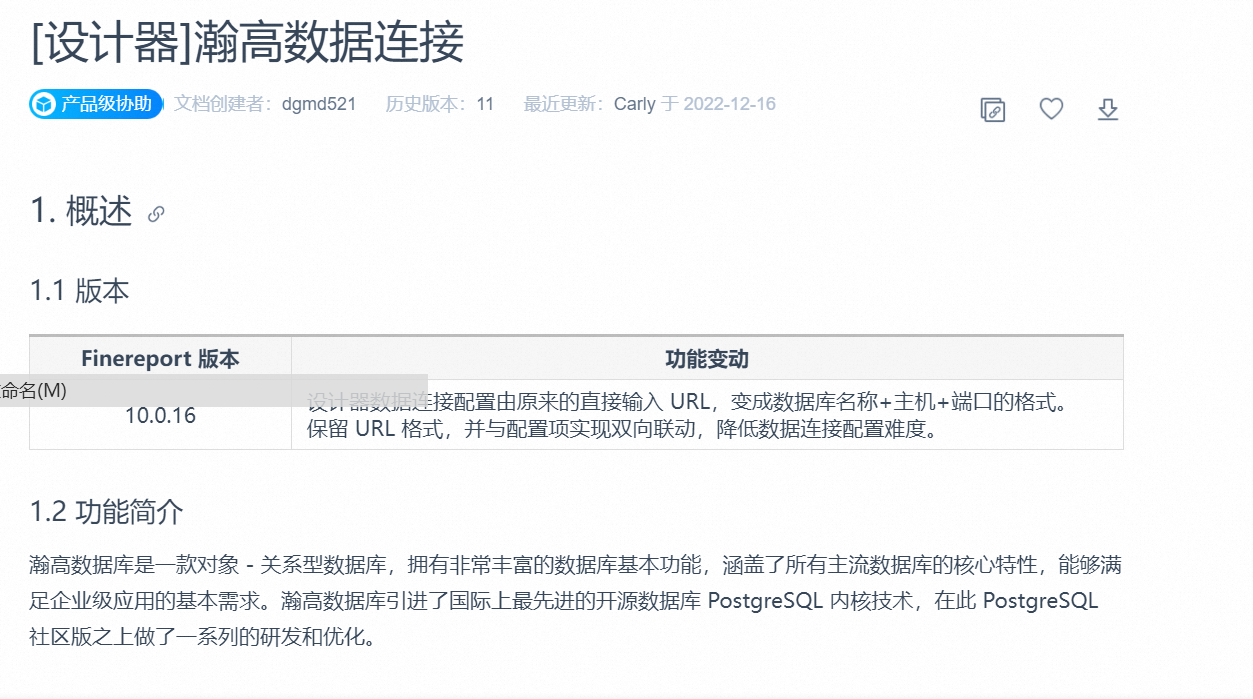

瀚高数据库引进了国际上最先进的开源数据库PostgreSQL内核技术,在此PostgreSQL社区版之上做了一系列的研发和优化。

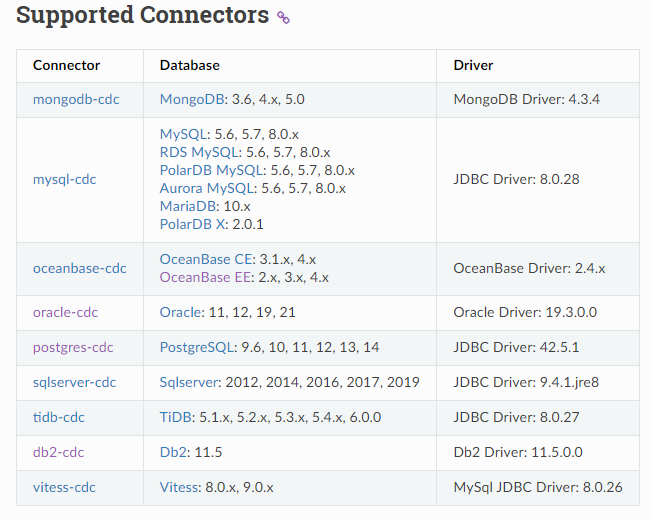

所以可以尝试用postgres-cdc来连翰高数据库。可以支持PostgreSQL: 9.6, 10, 11, 12, 13, 14。

楼主你好,阿里云Flink CDC 是用于实时数据同步的一个解决方案,支持与多种数据源进行连接和同步。而翰高数据库是一个第三方开发的数据库,是否能够与阿里云Flink CDC 兼容需要具体考虑。

一般来说,阿里云Flink CDC 支持与 MySQL、Oracle、PostgreSQL、SQL Server等主流关系型数据库进行连接,但对于翰高数据库是否支持需要具体尝试。如果翰高数据库支持 MySQL 或者其他主流数据库的协议,那么可以考虑使用阿里云Flink CDC 进行同步。

需要注意的是,在使用阿里云Flink CDC 进行数据同步时,需要保证源数据库和目标数据库的版本和协议是兼容的,否则可能会导致同步失败。同时,为了保证数据的准确性和安全性,在进行数据同步前需要进行充分的测试和备份。

理论上 Flink CDC 可以支持连接翰高数据库,但可能需要做一定的开发和适配:

Flink CDC可以连接到IBM DB2数据库。可以使用Db2JdbcDriver来连接DB2数据库,并使用Db2Table来配置表的输入格式。需要注意的是,具体的配置方法可能会因为不同的环境和版本而有所不同,建议您根据具体的情况进行配置。

Flink CDC 支持连接多种类型的数据库,包括关系型数据库和NoSQL数据库。针对您提到的翰高数据库,Flink CDC 可以通过 JDBC 连接器来实现数据同步。

在使用 Flink CDC 连接翰高数据库之前,需要先下载并安装相应的 JDBC 驱动程序,并将其添加到 Flink 环境中。此外,需要根据翰高数据库的连接方式,配置相应的 JDBC 连接信息,例如数据库的 URL、用户名和密码等。

以下是一些常见的翰高数据库的 JDBC 连接信息示例:

jdbc.driverClass=com.mysql.jdbc.Driver

jdbc.url=jdbc:mysql://localhost:3306/mydatabase

jdbc.username=myusername

jdbc.password=mypassword

jdbc.driverClass=oracle.jdbc.driver.OracleDriver

jdbc.url=jdbc:oracle:thin:@localhost:1521:orcl

jdbc.username=myusername

jdbc.password=mypassword

jdbc.driverClass=com.microsoft.sqlserver.jdbc.SQLServerDriver

jdbc.url=jdbc:sqlserver://localhost:1433;databaseName=mydatabase

jdbc.username=myusername

jdbc.password=mypassword

只要翰高数据库支持 JDBC 连接,那么 Flink CDC 就可以通过 JDBC 连接器来实现数据同步。

Flink CDC原则上可以连接和同步任何支持数据库binlog的数据库。对于翰派数据库,具体来说:

翰派数据库支持记录binlog日志变更,实现基本的CDC能力。

Flink CDC提供了通用的JDBC源可以连接任何数据库。只需配置好JDBC连接串即可。

需要实现Database history logging的解析逻辑。这部分需要参考其他数据库的实现方式进行开发。

目前还没有 community 推出过完整的翰派数据库connector。

可以参考MySQL、Postgresql等数据库connector的设计模式自己开发。

关键是正确实现binlog事件的反序列化,提取结构化的操作内容。

支持恢复时同步程序状态,保证 exactly-once 语义。

验证数据一致性需要数据库支持比较查询能力。

如果您想要使用Flink CDC连接翰高数据库,可以通过以下方式进行:

查看Flink CDC的配置文件:在Flink CDC的配置文件中,可以查看connector参数,以确定Flink CDC支持的数据库类型。例如,如果您的Flink CDC支持连接翰高数据库,那么您可以在connector参数中指定翰高数据库的连接信息。

查看Flink CDC的启动命令:在Flink CDC的启动命令中,可以查看--add-plugins参数,以确定Flink CDC支持的数据库类型。例如,如果您的Flink CDC支持连接翰高数据库,那么您可以在--add-plugins参数中指定翰高数据库的插件信息。

需要注意的是,如果您在生产环境中使用Flink CDC连接翰高数据库,那么您需要确保Flink CDC使用的是稳定版本的翰高数据库连接器。同时,您还需要确保Flink CDC的数据备份和恢复机制,以保证数据的安全性和可靠性。

Flink CDC (Change Data Capture) 是 Flink 的一个功能,用于实时捕获数据源的变化,并将这些变化转换为可操作的数据流。翰高数据库是一种关系型数据库,可以用作 Flink CDC 的目标数据源。

要将 Flink CDC 应用程序部署到翰高数据库上,您需要执行以下步骤:

配置 Flink CDC,以便它可以连接到翰高数据库。

将 Flink CDC 应用程序部署到 Flink 集群中,以便它可以在 Flink 集群中运行。

在 Flink 中配置翰高数据库数据源,并使用 Flink SQL API 来查询和操作数据。

关于 Flink CDC 和翰高数据库的更多信息,请参阅以下文档:

Flink 官方文档中关于 CDC 的部分:https://ci.apache.org/projects/flink/flink-docs-release-1.12/zh/dev/connectors/cdc.html

翰高数据库官方文档:https://www.hikvision.com.cn/products/database/DSN-DB

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。