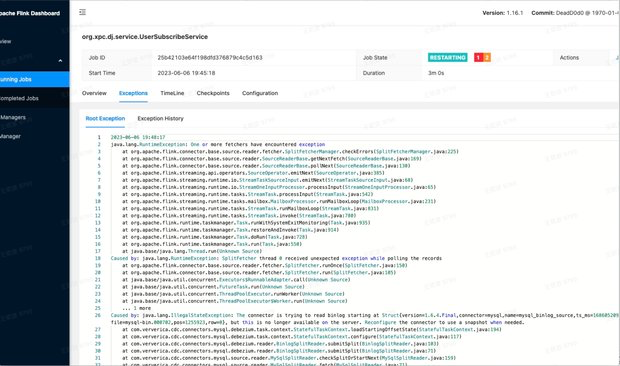

各位大佬 有遇到这个问题的吗是怎么解决的呀?我们使用flinkcdc运行中遇到的问题问题,此任务是读取kafka服务的数据流,并flinkcdc中的mysqlcdc读取mysql中维表补齐一些维表数据 最后写入到数据库报错是这样: 下面是主要报错信息:java.lang.RuntimeException: One or more fetchers have encountered exceptionCaused by: java.lang.RuntimeException: SplitFetcher thread 0 received unexpected exception while polling the recordsCaused by: java.lang.IllegalStateException: The connector is trying to read binlog starting at Struct{version=1.6.4.Final,connector=mysql,name=mysql_binlog_source,ts_ms=1686104185098,db=,server_id=0,file=mysql-bin.000702,pos=1255923,row=0}, but this is no longer available on the server. Reconfigure the connector to use a snapshot when needed.?

下面是主要报错信息:java.lang.RuntimeException: One or more fetchers have encountered exceptionCaused by: java.lang.RuntimeException: SplitFetcher thread 0 received unexpected exception while polling the recordsCaused by: java.lang.IllegalStateException: The connector is trying to read binlog starting at Struct{version=1.6.4.Final,connector=mysql,name=mysql_binlog_source,ts_ms=1686104185098,db=,server_id=0,file=mysql-bin.000702,pos=1255923,row=0}, but this is no longer available on the server. Reconfigure the connector to use a snapshot when needed.?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在数据库层面设置访问控制:您可以根据Flink CDC任务的角色或用户,在数据库层面设置相应的访问控制。例如,可以为每个任务创建一个独立的用户,并授予该用户对目标表的插入权限。

使用数据库的事务隔离级别:通过设置适当的事务隔离级别,您可以确保多个任务同时插入数据时不会发生冲突。例如,在Oracle数据库中,可以使用READ COMMITTED或SERIALIZABLE级别的事务隔离来确保数据的一致性。

使用Flink的权限检查功能:如果您使用的是Flink的Table API或SQL,可以尝试使用Flink的权限检查功能。Flink的Table API和SQL都提供了权限检查的相关API,可以在执行插入操作之前进行权限检查,以确保具有插入权限的用户可以执行插入操作。

从错误信息来看,这个错误可能是由于 FlinkCDC 在读取 Kafka 数据流时遇到了问题,然后在 MySQLCDC 中尝试读取 MySQL 的 binlog 来补齐维表数据时出现了异常。具体来说,异常信息指出 "connector is trying to read binlog starting at Struct{version=1.6.4.Final,connector=mysql,name=mysql_binlog_source,ts_ms=1686104185098,db=,server_id=0,file=mysql-bin.000702,pos=1255923,row=0},但这个在服务器上已经不再可用。" 这可能是由于 FlinkCDC 尝试读取的 binlog 位置在 MySQL 服务器上已经不再可用或者已经被覆盖。

为了解决这个问题,可以尝试以下几种方法:

1、确保 FlinkCDC 读取的 binlog 位置是在 MySQL 服务器上仍然可用的。可以检查 MySQL 的 binlog 日志文件和位置,确保 FlinkCDC 读取的位置在有效范围内。

2、重新配置 FlinkCDC,使其在需要时使用快照而不是持续读取 binlog。可以在 FlinkCDC 的配置文件中设置相应的参数,使其使用快照读取数据。

3、检查 FlinkCDC 和 MySQL 之间的网络连接是否正常。如果网络连接存在问题,可能会导致 FlinkCDC 无法正确读取 MySQL 的 binlog 数据。

4、检查 FlinkCDC 和 Kafka 之间的数据流是否正常。如果 Kafka 数据流存在问题,可能会导致 FlinkCDC 在处理数据时出现异常。

楼主你好,这个问题是因为flinkcdc读取mysqlcdc时,binlog文件发生了变化,导致无法继续读取之前的binlog文件。建议您按照报错信息中的提示,重新配置flinkcdc使用snapshot模式进行读取。可以参考以下步骤:

停止flinkcdc任务。

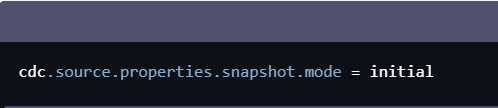

修改flinkcdc任务的配置文件,将binlog读取的模式改为snapshot。可以在配置文件中添加如下配置:

cdc.source.properties.snapshot.mode = initial

重启flinkcdc任务,并等待其读取完整个快照数据。

将配置文件中的snapshot模式改回binlog模式。

重新启动flinkcdc任务,让其继续从最新的binlog文件开始读取数据。

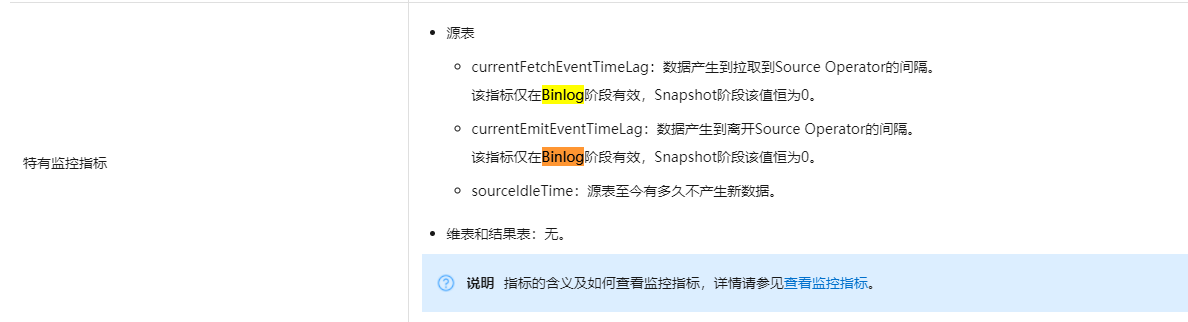

最后再来看看这个文档描述:

根据您提供的日志信息,这个问题可能是由于 Flink CDC 读取 Kafka 数据时遇到了异常导致的。具体的异常信息需要您提供更多的日志信息才能确定。以下是一些可能导致这个问题的原因和解决方法:

Kafka 集群连接超时或者连接被重置。您可以检查 Kafka 集群的配置参数以及网络状况,尝试增加连接池大小或者减少连接空闲时间等来解决这个问题。

Kafka 主题中的数据格式不正确。如果您在 Kafka 主题中存储了非法的数据格式,比如日期格式不正确或者字符串长度超过了字段定义,可能会导致 Flink CDC 无法正确解析数据。您可以检查 Kafka 主题中的数据格式是否符合要求,并进行相应的修正。

Flink CDC 的版本与 Kafka 客户端库不兼容。如果您使用的 Flink CDC 版本与 Kafka 客户端库不兼容,可能会导致 Flink CDC 无法正确解析 Kafka 主题中的数据。您可以尝试升级或者降级 Flink CDC 的版本,或者更换 Kafka 客户端库。

Kafka 集群中的主题分区发生了变化。如果您在 Flink CDC 启动之后修改了 Kafka 主题的分区数量或者分区分配方式,可能会导致 Flink CDC 无法正确解析数据。您可以尝试重新启动 Flink CDC 或者在修改分区之前停止 Flink CDC 的运行。

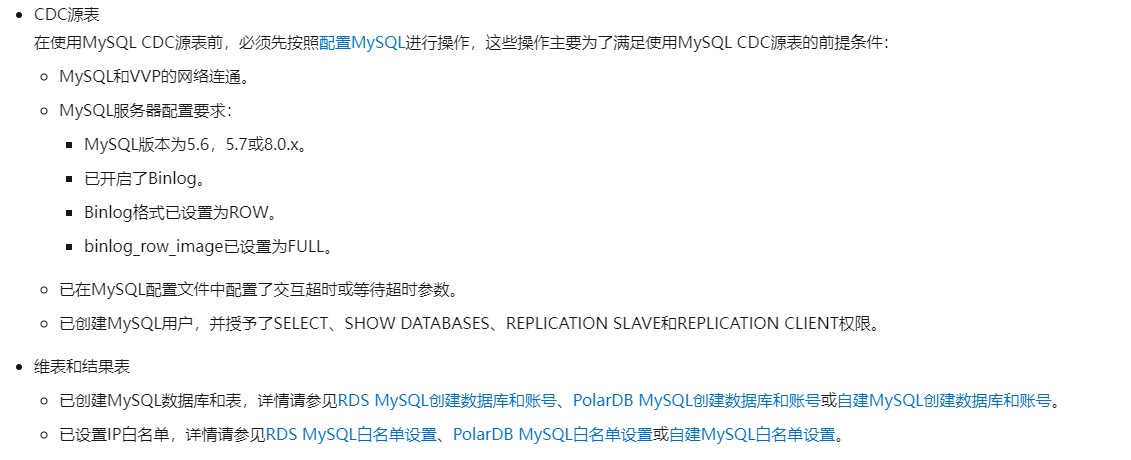

根据您描述的情况,Flink CDC读取Kafka数据流并使用MySQL CDC enrichment维表数据时报错,可能的原因和解决方案:

MySQL配置不当,CDC拉取维表数据失败。

确认MySQL binlog日志收集设置正确

给CDC用户授权访问binlog

Flink MySQL CDC链接配置错误

校验数据库连接参数(url、user等)

Flink作业并行度设置错误

适当增加并行个数处理更多流记录

Flink SQL转换查询过于复杂

简化SQL查询逻辑减少开销

资源不足

提升Flink/MySQL计算和网络资源

元数据不一致

清理CDC状态重建最新元数据

版本兼容问题

确认Flink和相关组件版本匹配

网络拥塞

监控网络流量排查瓶颈

建议:

print详细日志定位错误原因

简化逻辑进行分步调试

增强MySQL CDC访问能力

适当增加资源进行测试

如果您在使用Flink CDC读取Kafka服务的数据流,并将其写入到MySQL中时,遇到了报错java.lang.RuntimeException: One or more fetchers have encountered exception,并且报错信息中包含SplitFetcher thread 0 received unexpected exception while polling the records和java.lang.IllegalStateException: The connector is trying to read binlog starting at Struct{version=1.6.4.Final,connector=mysql,name=mysql_binlog_source,ts_ms=1686104185098,db=,server_id=0,file=mysql-bin.000702,pos=1255923,row=0}, but this is no longer available on the server. Reconfigure the connector to use a snapshot when needed.,那么可能是由于以下原因:

数据源表的数据结构发生了变化:如果您的数据源表的数据结构发生了变化,那么可能会导致Flink CDC无法正确读取和写入数据。在这种情况下,您需要在Flink CDC的配置文件中,指定数据源表的数据结构,以确保Flink CDC能够正确读取和写入数据。

数据源表的索引发生了变化:如果您的数据源表的索引发生了变化,那么可能会导致Flink CDC无法正确读取和写入数据。在这种情况下,您需要在Flink CDC的配置文件中,指定数据源表的索引,以确保Flink CDC能够正确读取和写入数据。

数据源表的字典发生了变化:如果您的数据源表的字典发生了变化,那么可能会导致Flink CDC无法正确读取和写入数据。在这种情况下,您需要在Flink CDC的配置文件中,指定数据源表的字典,以确保Flink CDC能够正确读取和写入数据。

需要注意的是,如果您在生产环境中使用Flink CDC读取Kafka服务的数据流,并将其写入到MySQL中,那么您需要考虑Flink CDC的资源使用情况。例如,您需要确保Flink CDC有足够的内存和CPU资源,以保证数据处理和同步的效率和稳定性。同时,您还需要确保Flink CDC的数据备份和恢复机制,以保证数据的安全性和可靠性。

这个报错信息表明 Flink CDC 中的 MySQL CDC 连接器正在尝试从指定的 binlog 位置读取数据,但在服务器上已不再可用。这通常是由于 binlog 日志被清理或删除导致的。

为了解决这个问题,您可以尝试以下几种方法:

检查 binlog 的保留策略:确保 MySQL 数据库的 binlog 保留策略足够长,以便 Flink CDC 可以读取到最新的 binlog 数据。您可以通过修改 MySQL 的配置文件(如 my.cnf 或 my.ini)来调整 binlog 的保留时间。

使用快照重新配置连接器:根据报错信息中的建议,您可以重新配置连接器以使用快照方式启动。这意味着连接器将从指定的 binlog 位置开始读取,并在达到当前 binlog 位置时切换到实时模式。要配置快照,请参考 Flink CDC 的官方文档或连接器的配置参数。

检查 MySQL 主从复制状态:如果您使用的是 MySQL 主从复制架构,确保主库和从库之间的复制状态正常。如果从库无法追赶上主库的 binlog,可能会导致连接器无法读取到特定的 binlog 数据。您可以检查从库的状态和延迟情况,并采取相应的措施来解决同步问题。

调整 Flink CDC 的配置参数:您可以尝试调整 Flink CDC 的配置参数,如 flinkcdc.metrics.interval 和 flinkcdc.fetcher.num-threads,以便更好地适应您的环境和数据流量。根据具体情况,可能需要增加或减少 fetcher 线程数、增加轮询间隔等。

检查网络连接和服务器负载:确保网络连接稳定,并检查 MySQL 服务器的负载情况。如果网络不稳定或服务器过会导致连接器无法及时获取 binlog 数据。您可以通过监控服务器资源使用情况和网络状况来识别和解决这些问题。