首先,请先看一段“正经”的文字:

他笑意中的那份温柔,只想给她好好珍藏,即便这一切不会发生,至少在他的世界里,她是无忧无虑的快乐的。就连他对她的关心,她都不在意了,还有什么不放心的呢?“好,我答应你。不过,如果我们能有个孩子,我一定做个好爸爸。”

桥豆麻袋!!!

这难道不是什么某某天堂、某江文学、某点中文上的小说情节?

误会了误会了。

这是最新发布的全球最大规模中文预训练模型“中文版GPT-3”——PLUG的力作。

270亿的参数规模,跟GPT-3一样是“万能写作神器”。

出于好奇,我第一时间就去上手试了试,没想到只是输入了四个字。

泛起笑意,

就给出了如此结果。

这个PLUG,有点意思啊~

竟然擅长的是这个?

接下来,我又进行了一波尝试,调戏一下PLUG的创作实力。

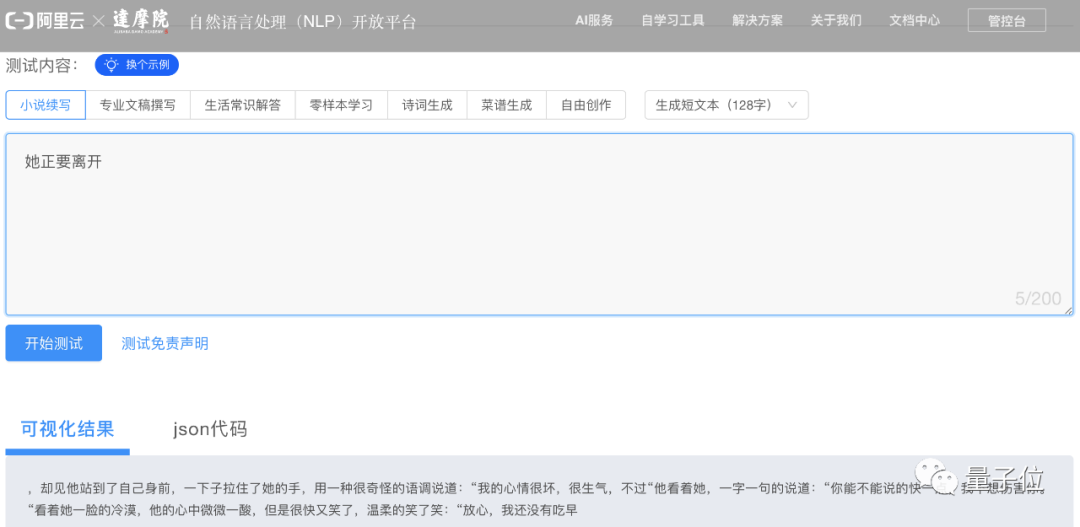

输入「他正要离开」,看它怎么接。

PLUG果然很懂!

,却见他站到了自己身前,一下子拉住了她的手,用一种很奇怪的语调说道:“我的心情很坏,很生气,不过“他看着她,一字一句的说道:“你能不能说的快一点,我不想伤害你。“看着她一脸的冷漠,他的心中微微一酸,但是很快又笑了,温柔的笑了笑:“放心……

有一说一,生成长文本的性能还是相当不错,并且提供了4个文本长度选项(32~512字)。

不过这内容……

难不成,我喜欢XX文的秘密被发现了?

别误会,其实PLUG也能生成“克制”一些的。

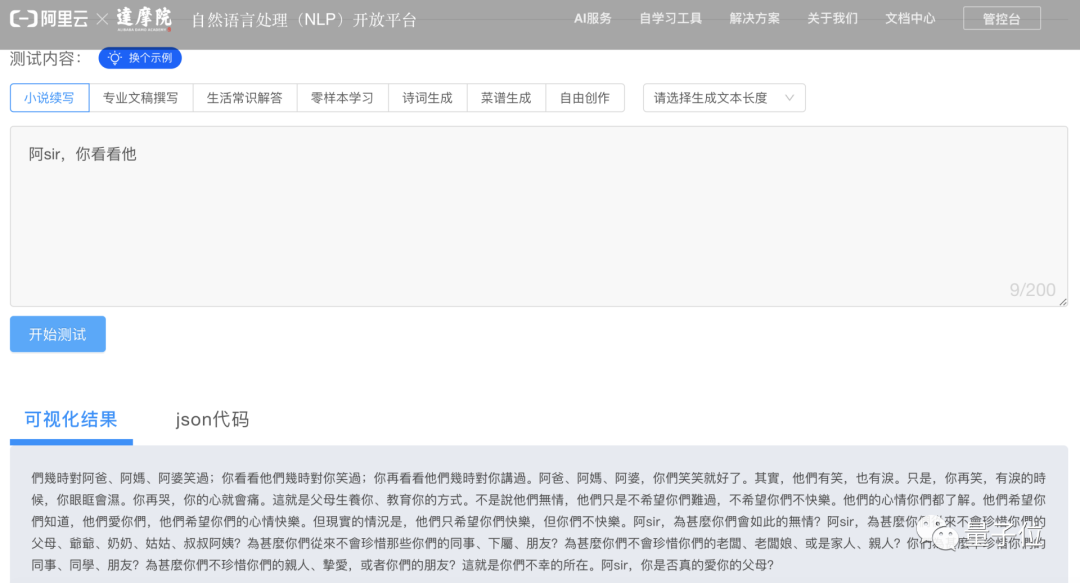

比如:输入「阿sir,你看看他」,结果就显得很正常嘛~

甚至还特意生成了繁体字小说,营造出一种港片的氛围感。

(阿sir,你看看他)們幾時對阿爸、阿媽、阿婆笑過;你再看看他們幾時對你笑過。阿爸、阿媽、阿婆,你們笑笑就好了。其實,他們有笑,也有淚……(此处省略200+字)阿sir,你是否真的愛你的父母?

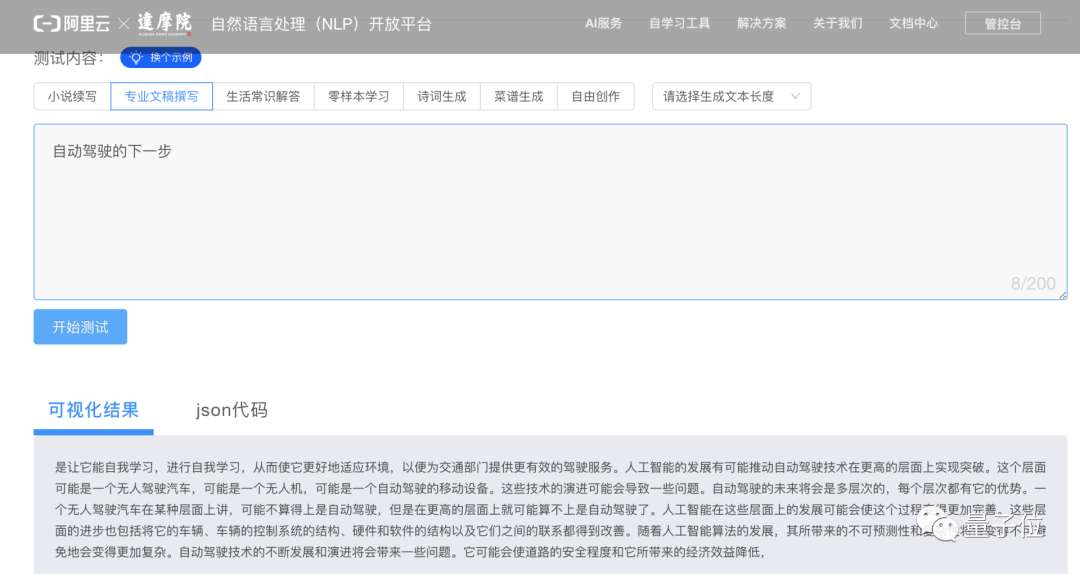

除了擅长写小说,PLUG还能写专业文稿、进行智能问答、生成诗词和菜谱等等。

就比如撰写专业文稿:

帮你解答生活常识,官网给出了贴心(不是)的示例:

程序员脱发用什么洗发水好?

三个月打造中文最强GPT-3

说了这么多,要达到这样的效果,这个中文最强GPT-3究竟如何炼成?

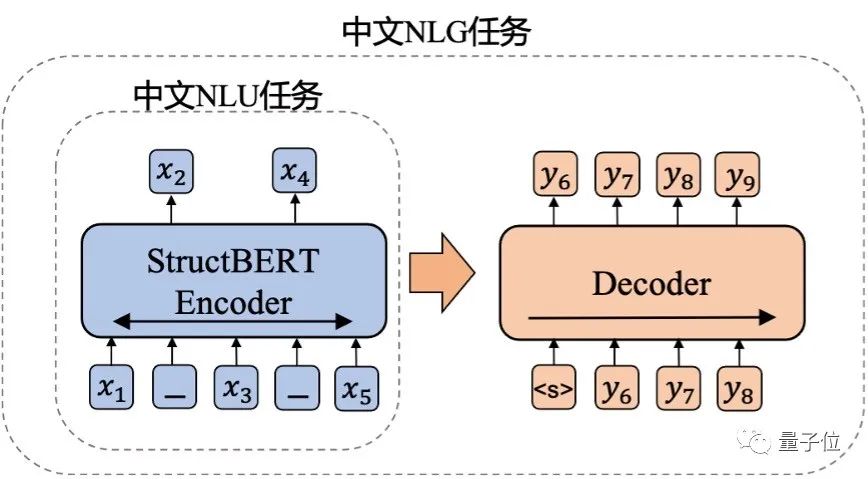

PLUG,Pre-training for Language Understanding and Generation,顾名思义,就是集语言理解(NLU)和生成(NLG)能力于一身。

要实现这一点,据团队介绍,这一模型是达摩院此前提出的两种自研模型——NLU语言模型StructBERT、NLG语言模型PALM的融合。

此外,跟GPT-3的单向建模方式不同的是,它采用了编码器-解码器(encoder-decoder)的双向建模方式。

具体来说,整个训练过程分为两个阶段。

第一阶段,以达摩院自研的语言理解模型——StructBERT作为编码器。

简单来说,它是在句子级别和词级别两个层次的训练目标中,加强对语言结构信息的建模,从而提高模型的语法学习能力。

这也使得PLUG具有输入文本双向理解能力,能够生成和输入更相关的内容。

这个过程共训练了300B tokens训练数据。

第二阶段,将这个编码器用于生成模型的初始化,并外挂一个6层、8192个隐藏层节点数的解码器,共计训练了100B tokens的训练数据。

此外,PLUG还能为目标任务做针对性优化。

上一回说到,GPT-3并没有利用微调和梯度更新,而是通过指定任务、展示少量演示,来与模型文本进行交互,完成各种任务。

因此在面对新任务时候,不需要重新收集大量的带标签数据。但不可避免的,生成的效果不足。

比如,犯低级错误就是GPT-3被人诟病比较多的一点。

而PLUG的能力更加全面,既可以实现与GPT-3类似的零样本生成功能,也可以利用下游训练数据微调(finetune)模型,提升特定任务的生成质量。

当然,效果实现的关键,还少不了算力和数据。

PLUG负责人表示,原本计划用128张A100训练120天炼成,不过由于阿里云、算法优化等达摩院多方力量的参与,以及加速手段的有效利用,成功将日程缩短到三分之一。

最后,只烧了35天就达到了这样的效果。

前面也提到,PLUG的参数量达到了270亿,中文训练数据量也达到了1T以上。

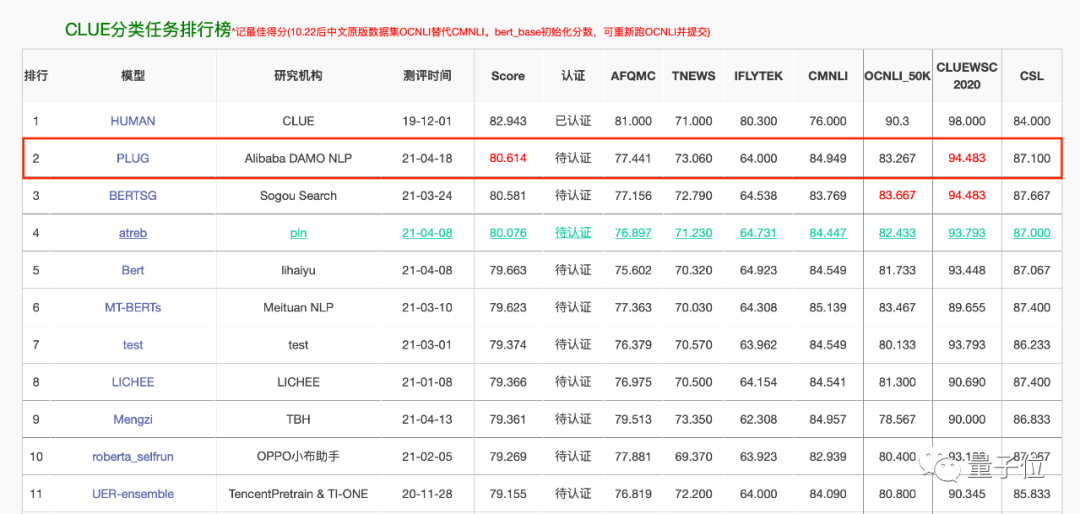

在语言理解任务上,PLUG以80.614分刷新了CLUE分类任务榜单记录。

而在语言生成任务上,据团队介绍,其多项应用数据较业内最优水平提升了8%以上。

语言模型体系再添一员大将

如果再把PLUG说成是“中文版GPT-3”,似乎就不太准确了。

耗时3个月、270亿参数规模、一发布就给体验端口……

但与此同时,这些关键词的背后,仍然留给读者一些疑问:

3个月是如何做到的?当前的参数规模是终点吗?为何现阶段就免费开放?

阿里深度语言模型体系负责人永春给出了一一解答。

首先,时间问题。主要有两个方面的原因。

从人力的角度来说,永春没有谈具体的数字,但此次涉及阿里的多个团队群策群力共同完成的,当中的训练时间也就大大缩短。

再加上,阿里以往的自研模型已经产生了更多的业务需求,促成了PLUG的开发,这也是阿里整体技术路线中的一环。

GPT-3的出现,给中国的一些玩家触动很大。

什么时候我们能出个中文版的同类模型?

阿里作为其中之一的企业,利用自身的技术、计算资源的优势,率先给出Demo。

永春表示,希望通过PLUG的发布,建立起与技术同行之间的桥梁。

要知道,GPT-3到目前也还没有做到完全开放。

不过,团队似乎并不担心PLUG发布之后的一些不确定性。(手动狗头)

比如,出现一些低级错误。

反而笑着说,之前GPT-3不也是因为大家吐槽才火的么?丢给技术圈去检验,这些问题都是不可避免的。

而这样的开源开放,正好是这个技术团队的一大底色。

去年,阿里达摩院发布了自研深度语言模型体系,包括6大自研模型。

通用语言模型StructBERT、多模态语言模型StructVBERT、多语言模型VECO、生成式语言模型PALM……他们一直在致力于陆陆续续将模型开源出来。

永春透露,在PLUG发布这段期间,达摩院宣布将开源阿里巴巴语言模型体系部分重要模型,目前正在走流程中。

至于之后的计划,团队表示2000亿级的参数规模正在规划中,并进一步提升文本生成质量。

而在应用领域,他们还将专门针对医疗领域做下游数据训练。

最终目标是希望将这个模型实际落地,提升NLP技术在方方面面的实力,比如能源、通信、司法等。

也诚如阿里达摩院语言技术实验室负责人司罗所说,

达摩院NLP团队将进一步攻克自然语言处理领域科研难题,完善中文及跨语言人工智能基础设施,让AI没有难懂的语言,并探索通用人工智能之路。

对了,PLUG刚刚完成最后一波调控,目前已开放了测试体验接口(仅供学术目的测试,需同意其相关约定)。

杨净 子豪 发自 凹非寺

量子位 报道 | 公众号 QbitAI