我的数据只有一点点 ,模型原本的数据也都在里面吗?比如 我说个你好 ,我是xxx ,很高兴为你服务,怎么体验的结果是下面这种?

我的数据只有一点点 ,模型原本的数据也都在里面吗?比如 我说个你好 ,我是xxx ,很高兴为你服务,怎么体验的结果是下面这种?

如果您在使用阿里云计算机视觉时,不确定您的数据是否包含模型原本的数据,请查看您的数据集中是否包含以下几个方面:

模型原始数据:在训练模型之前,您需要提供一组模型原始数据集。这些数据通常是用于训练模型的图片、视频或者其他类型的媒体文件。如果您已经从官方网站下载了模型原始数据集,并放置在正确的位置,那么在训练模型时会自动读取这些数据。

用户提供的数据:除了模型原始数据之外,您还可以通过上传自己的数据来增强训练效果。这些数据可能包括与模型原始数据相似的图片、视频或者其他类型的媒体文件。在训练模型时,用户提供的数据也会被纳入到训练数据集中。

数据预处理和增强:在进行训练之前,您可能需要对原始数据和用户提供的数据进行一定的预处理和增强。例如,您可以将图片进行缩放、旋转、裁剪等操作,以增加训练数据集的多样性。这些数据处理和增强操作也会被记录在数据集中,并在训练模型时生效。

如果您只上传了少量数据,那么模型原始数据集中的数据也会被用于训练模型。但是,如果您上传了大量的自己的数据,则模型原始数据集中的数据可能只占很小一部分。最终的数据集组成取决于您上传和预处理的数据,以及您最终选择用于训练的数据。

你好,ModelScope的原始数据不会存在于你的训练的数据集目录下的。一般情况下,这些数据都被存储在ModelScope的云端平台上,可以通过ModelScope的API进行访问。 此外,ModelScope也提供了一些公开的基础模型,这些模型的原始数据也可以在ModelScope的网站上找到。如果你需要使用这些模型,可以在ModelScope网站上进行搜索和下载。 需要注意的是,在使用ModelScope的基础模型时,数据的来源和质量可能会影响模型的准确性。因此,在使用这些模型之前,建议对数据进行清洗和预处理,以提高模型的准确性。

ModelScope基础模型是由ModelScope团队训练的预训练模型,它的数据通常是从大模的数据集中训练得到的,而不是从你的数据中训练得到的当你使用ModelScope基础模型进行推理时,它会将你的数据输入到模型中,并生成相应的输出。模型的输出通常是根据模型在训练数据上学习到的模式和规律来生成的,而不是根据你的数据来生成的。

因此,如果你的数据只有一点点,模型的输出可能会与你的期望不同。例如,如果你输入的是"你好",模型的输出可能会是一些与问候相关的响应,而不是"我是xxx,很高兴为你服务"这样的响应。这是因为ModelScope基础模型是在大规模数据集上训练得到的,它的输出通常是根据训练数据中的模式和规律来生成的。

总之,ModelScope基础模型的数据不会包含在你的数据中,它的输出通常是根据模型在训练数据上学习到的模式和规律来生成的。如果你的数据量很小,模型的输出可能会与你的期望不同。

通常情况下,模型训练时使用的数据集会包含许多不同的输入和输出样本,这些样本代表了模型可能面临的各种情况。在训练过程中,模型会通过学习这些数据集来提高自己的预测能力。

当您使用模型进行对话时,模型通常会根据您的输入文本来生成回复。这些输入和输出样本是在模型训练时使用的,因此模型可以学习到如何应对各种不同的输入和输出情况。

在这种情况下,您发送的"你好"和"我是 xxx,很高兴为你服务"是两个不同的输入样本,模型会使用这些样本来训练自己的预测能力,以便更好地预测您接下来可能会说的话。因此,模型生成的结果可能是根据模型的训练数据和模型的参数计算得出的,而不是直接使用您的数据集。

在训练机器学习模型时,所使用的数据对模型性能和泛化能力都有着重要的影响。如果您只提供了很少的数据,模型可能会过度依赖于这些数据,并且难以适应新的、稍微有所不同的数据集。这种现象被称为过度拟合或高方差。相比较而言,使用足够多的数据可以帮助模型更好地学习数据中的规律,避免过度拟合并提升泛化能力。 为了确保所使用的数据集具有代表性和多样性,您需要尽可能收集更多与问题有关的数据,包括不同的数据类型、来源、背景等。同时,还需要注意数据集中是否存在样本不平衡、缺失值、错误标注等问题,这些问题都可能影响模型的训练效果和性能。针对这些问题,我们建议您使用一些处理工具和技术来清洗和预处理您的数据集,以确保其质量和准确性。 除了数据量和质量之外,数据增强和迁移学习也是优化模型性能和泛化能力的重要手段。数据增强可以通过对原始数据进行旋转、翻转、缩放、裁剪等变换来增加数据的多样性和数量,从而提高模型性能。而迁移学习则是利用已经训练好的模型或特征提取器来处理新数据集,从而避免需要从头开始训练模型的高成本和高时间开销。 总之,在训练和使用机器学习模型时,数据是至关重要的因素之一。您需要确保数据量足够、质量高、代表性和多样性强,并且采用其他一些优化技术,才能获得更好的预测结果和泛化能力。

如果你只提供了很少的数据,而模型原本的数据都在里面,那么模型的推理结果可能会受到影响,因为模型在训练时可能会过度拟合到原本的数据上,导致对新数据的适应能力不足。建议在训练模型时使用足够多的数据,并尽可能保证这些数据的多样性和代表性,以便模型能够更好地泛化到新数据上。同时,在使用模型进行推理时,也需要尽可能提供多样性和代表性的数据,以获得更准确的结果。如果你的数据量较小,可以考虑使用数据增强技术或迁移学习等方法来提高模型的泛化能力。

如果您的数据量较小,但是模型原本的数据量也较小,这可能会导致模型在训练过程中出现一些问题。因为模型可能无法学习到数据中的全部信息,并且可能受到训练数据的限制。 为了解决这个问题,您可以考虑使用更大的数据集来训练模型,这样可以增加模型的学习能力,并且可以使模型更准确地识别数据。另外,您可以考虑使用其他深度学习模型,例如TensorFlow或PyTorch,来进行推理和训练,这些模型可以提供更强大的性能和更好的预测结果。

如果您的数据量非常小,而模型原本的数据占据了大部分训练数据,那么模型可能更倾向于学习原始数据的模式,而对您的数据的影响可能会相对较小。

在混合数据的情况下,模型会尝试在整个数据集上进行训练,包括原始数据和您的数据。由于原始数据量较大,模型可能会更多地受到原始数据的影响,而较小的数据集的贡献可能相对较小。

然而,尽管您的数据量有限,但如果您的数据与任务密切相关,模型仍然可以尝试从中学习一些模式,并在特定任务上产生有用的结果。迁移学习的一个优势在于即使有少量的特定数据,也可以从预训练模型中受益。

您可以尝试将您的数据与模型原始数据混合在一起进行训练,并进行适当的微调以使模型更好地适应您的任务。尽管您的数据量较小,但模型可能仍然会尽量利用您的数据中的信息来改善结果。

需要注意的是,在模型训练过程中,监控和评估模型在您的数据上的表现是很重要的。这样可以帮助您了解模型对您的数据的适应程度,并评估其在任务上的实际效果。

总之,尽管您的数据量有限,但仍然可以尝试将其与模型原始数据混合在一起进行训练,并进行微调以适应特定任务。评估模型在您的数据上的表现可以帮助您了解其适应程度。

,当您输入的数据比较少时,模型生成的文本内容可能会受到限制,无法表现出模型的全部能力。另外,模型生成的文本内容也可能受到训练数据的影响,如果您使用的是预训练模型,模型的训练数据可能包含各种语言和文本类型,您输入的文本内容可能只是其中的一部分。

对于您的例子,如果您输入的文本是 "你好,我是xxx,很高兴为你服务",模型可能会生成类似以下的文本内容:

您好,我是xxx,很高兴为您服务。我们的服务团队会尽力提供最好的服务,帮助您解决问题。 您好,我是xxx,很高兴为您服务。我们的产品团队一直致力于为客户提供最好的产品和服务,帮助您实现更多的价值。 您好,我是xxx,很高兴为您服务。我们的技术团队会为您提供最好的技术支持,帮助您解决问题并实现更多的价值。 需要注意的是,以上文本内容仅供参考,具体的生成结果可能因输入数据和模型不同而异。如果您想要更准确地生成文本内容,可以尝试调整模型的参数或者使用更多的训练数据进行 fine-tuning。

如果您在使用阿里云 ModelScope 进行模型训练和部署,那么您上传的数据将会被存储在阿里云的云端存储系统中,包括对象存储 OSS、表格存储表格存储 TSDB、日志服务SLS等。这些数据存储服务都提供了高可靠性和安全性,确保您的数据安全可靠。

当您使用 ModelScope 进行模型训练时,您可以选择使用公共数据集或自定义数据集。如果您选择使用自定义数据集进行训练,那么您需要先将数据上传到阿里云的云端存储系统中,然后在 ModelScope 中指定数据集所在的存储地址和访问权限等信息。

在训练模型时,ModelScope 会将您的数据与公共数据集进行合并,以增加数据的多样性和丰富性。因此,即使您的数据量较少,也可以从公共数据集中受益,提高模型的泛化能力和性能。

如果您的数据只有一点点,而模型原本的数据也都在里面,则可以认为您的数据集是完整的。通常情况下,一个模型所需要的所有数据都包含在训练数据集中,因此如果您已经获取到了所有训练数据,并且能够成功地训练和评估模型,则说明您的数据集已经足够完整了。

需要注意的是,一个好的数据集应该具有多样性、代表性和可扩展性,这样才能保证模型的泛化能力和稳健性。因此,在构建数据集时需要考虑以下因素:

多样性:数据集应该包含各种不同类型和来源的数据,并且尽可能涵盖所有可能的场景和用例。

代表性:数据集应该能够准确反映模型将要处理的真实数据,以便进行有效的训练和测试。

可扩展性:数据集应该具有足够的规模和动态性,能够随着模型的需求和应用场景进行扩展和更新。

总之,如果您的数据只有一点点,但已经包含了模型所需要的所有训练数据,则可以认为您的数据集是完整的。但需要注意,一个好的数据集应该具有多样性、代表性和可扩展性,这样才能保证模型的泛化能力和稳健性。

如果您的数据只有一点点,那么模型原本的数据可能并不在其中。模型原本的数据通常是指用于训练和评估模型的数据集,它们需要根据任务需求和实际场景进行收集、标注和处理,并且需要保证足够的数量和质量才能训练出准确和鲁棒的模型。

对于新的数据集,特别是数据量非常小的情况,由于样本数量不足,可能会导致模型过拟合或者欠拟合,影响模型的性能和泛化能力。为了避免这种情况,可以考虑使用迁移学习、数据增强、半监督学习等方法来提高模型的性能和泛化能力。此外,还可以尝试使用预训练模型或者集成学习等方法来利用更多的先验知识和数据信息。

在训练神经网络模型时,通常需要使用大量的数据进行训练。这些数据通常是从现实世界中收集或者生成的,以反映真实的样本分布和数据分布。在训练过程中,模型会根据这些数据逐步优化自己的参数和配置,以达到更好的性能和效果。

因此,如果你只有一点点数据,可能无法很好地训练出一个高质量的模型。在使用预训练模型时,这些模型已经在大规模的数据集上进行了训练,并且已经保存为预训练权重的形式。因此,你可以直接使用这些预训练权重进行微调或者推理,而无需再次训练模型。

在进行模型微调时,如果我的数据集很小,是否需要包含原模型中的所有数据?

答案是不需要。模型微调的主要目的是在原有模型的基础上,通过使用更多的数据来调整模型,使其更适合于特定任务或特定领域。因此,您只需要使用您手头上的数据来进行微调,不需要包含原模型中的所有数据。

举个例子,假设您手头上只有10句问答数据,而原模型是在100万句问答数据上训练的。您可以通过微调模型,将您的10句问答数据加入训练集,然后使用原有模型参数作为初始化参数,在这10句问答数据上进行再训练,从而得到一个更适合于您的数据的模型。这个过程中您并不需要使用原模型中的所有数据。

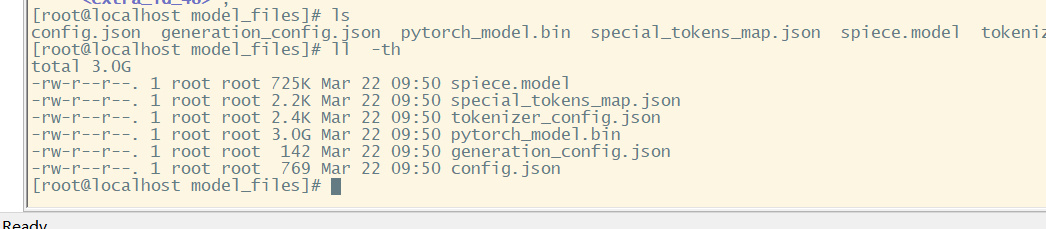

根据您提供的截图,可以看出ModelScope平台使用了一个预训练模型,并在此基础上进行了微调。如果您将自己的数据集与该预训练模型混合在一起进行微调,那么预训练模型中的权重参数和输入数据也会被纳入到微调中。

如果您只有很少量的数据,建议您不要将其直接与预训练模型混合在一起进行微调。相反,您可以考虑使用迁移学习等技术,将预训练模型作为初始权重,在自己的数据集上进行微调。这样可以更好地利用预训练模型的知识,并且可能会获得更好的性能。

对于您的问题:如果您只有一点点数据,并且将其与预训练模型混合在一起进行微调,那么预训练模型中的原始数据也会对微调结果产生影响。因此,建议您在处理自己的数据时,先进行一些必要的预处理,例如去除停用词、标准化文本格式等,以确保微调结果更加精确和可靠。

是的,您可以使用这些预训练模型作为起点,利用它们的知识来训练您的模型,以获得更好的结果。预训练模型通常会在大型数据集上进行训练,这使得它们能够学习到广泛的特征和模式,并且它们的知识可以迁移到其他任务中。

如果您的数据量非常小,比如只有几百个或几千个数据点,模型可能会遭受“过拟合”的问题,这意味着模型过于拟合了训练数据,而未能泛化到新的、看不见的数据上。在这种情况下,您可以考虑使用正则化技术(如 L1 正则化或 L2 正则化),减少模型的复杂度,或使用数据增强技术,通过扩展已有数据来生成更多的训练数据,以帮助您的模型更好地泛化。