想问下,关于flink任务提交 的时候使用run-application -t yarn-application 模式提交任务,如何加载自定义的文件配置,我在提交任务的时候,发现没有将我自己的配置加载到am中我任务提交的时候是这样的: flink run-application -t yarn-application -d -Dyarn.provided.lib.dirs="hdfs:///daas/flink/flink-dist-1.16/lib"

-Dyarn.application.name=DataFacts--kafka_to_kafka

-Dyarn.application.queue=root.admin -c com.deepexi.data.flink.sqlsubmit.SqlSubmit flink-sql-submit-1.16.X.jar

-f 1638378663588282397.sql -ci '' -ct '' -minTime '' -maxTime ''

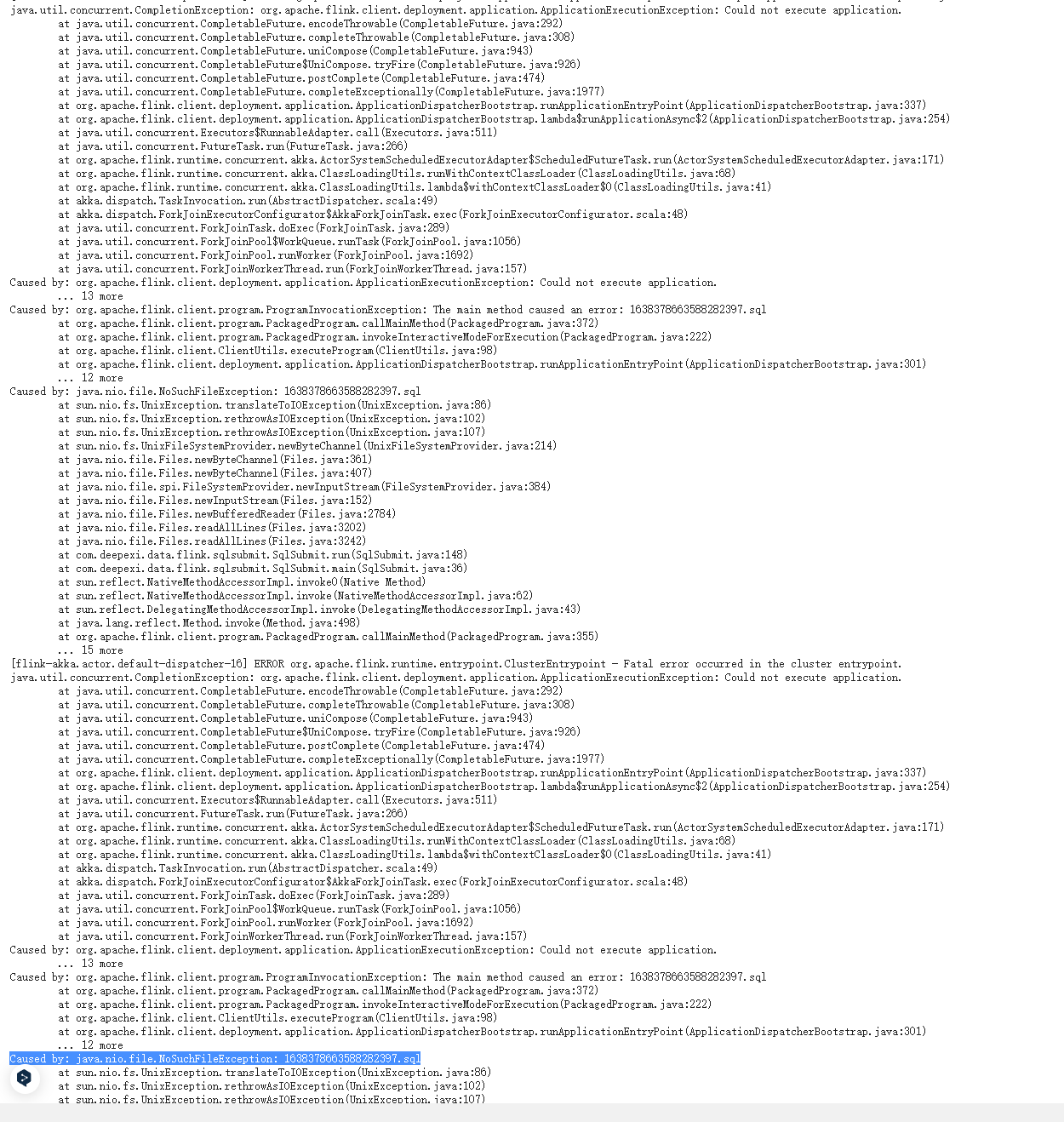

在日志中发现这个报错:Caused by: java.nio.file.NoSuchFileException: 1638378663588282397.sql

发现是我-f 传递的文件没有加载到am中 这种情况下是这样的,然后我尝试用yarn-perjob模式,后发现-Dyarn.provided.lib.dirs="hdfs:///daas/flink/flink-dist-1.16/lib" 没有生效

这种情况下是这样的,然后我尝试用yarn-perjob模式,后发现-Dyarn.provided.lib.dirs="hdfs:///daas/flink/flink-dist-1.16/lib" 没有生效

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

你是什么文件配置,一个单独的文件程 序里面要读的。还是flink自己的配置文件。这么指定文件是带不到yarn的容器里面的。要么把文件上传到hdfs,要么放bin目录下面,然后指定相对路径。提交的时候会把bin下面的文件全部上传,这时候看下yarn的启动日志看看文件目录是什么,-f 再指定容器里面的相对目录。 具体细节记不清了,以前特定需求有这么干过。 直接放hdfs吧 省事。此回答整理自钉群“【③群】Apache Flink China社区”

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。