各位大佬,我用Flink CDC flinkcdc读取postgresql,只能获取到全量数据,获取不到增量数据,是什么问题

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

使用Flink CDC读取PostgreSQL时只能获取到全量数据,无法获取增量数据。这可能是由以下几个原因导致的:

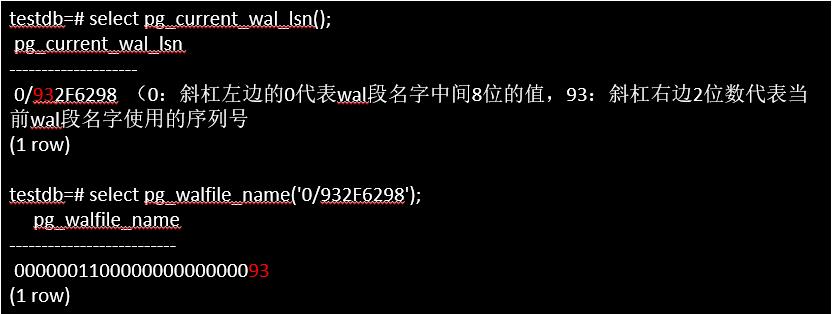

1、数据库配置问题:请确保数据库的WAL(Write-Ahead Logging)模式已启用。Flink CDC需要读取数据库的事务日志(WAL),以捕获增量数据的变更。如果WAL模式未启用,Flink CDC将无法正确捕获变更。

2、Flink CDC配置问题:检查Flink CDC的配置是否正确。确保已正确指定要读取的数据库表和相关的连接信息。

3、CDC插件问题:Flink CDC使用PostgreSQL的CDC插件(如Debezium)来读取变更数据。请确保安装了正确版本的插件,并按照文档中的说明进行配置。

4、数据库版本兼容性问题:确保使用的Flink版本和PostgreSQL数据库版本是兼容的。不同版本的Flink和PostgreSQL可能需要不同的配置和插件版本。

楼主你好,可能是以下几个方面导致的:

您的PostgreSQL版本不支持CDC(例如,版本低于9.4)。

您的PostgreSQL数据库没有配置好CDC,确保已经启用了逻辑复制。

您的Flink CDC配置有误,可能是您的表名、数据库连接等配置错误。

您的Flink CDC程序可能没有正确编写代码处理增量数据,需要检查您的代码是否正确。

Flink CDC 可以实时捕获 PostgreSQL 数据库的变更数据,包括插入、更新和删除操作。在使用 Flink CDC 时只能获取到全量数据,而无法获取到增量数据,可能是以下原因之一:

没有正确配置 binlog 或 wal 日志文件。Flink CDC 需要通过 binlog 或 wal 日志文件来捕获变更数据。如果没有正确配置相关参数,可能会导致无法捕获到变更数据。

没有正确配置表名或 schema 名称。Flink CDC 需要知道要捕获哪些表的变更数据,如果没有正确配置表名或 schema 名称,可能会导致无法捕获到变更数据。

没有正确配置过滤条件。Flink CDC 可以通过过滤条件来筛选需要捕获的变更数据,如果没有正确配置过滤条件,可能会导致无法捕获到变更数据。

数据库中没有进行插入、更新或删除操作。如果数据库中没有进行插入、更新或删除操作,Flink CDC 就无法捕获到变更数据。

如果您使用 Flink CDC 在读取 PostgreSQL 数据时只能获取到全量数据,而无法获取增量数据,可能有以下几个原因导致:

检查配置是否正确:请确保您已经正确配置了 Flink CDC 作业的相关参数,包括数据库连接信息、表白名单(table whitelist)和其他必要的配置项。特别注意检查 cdc.startup.mode 参数,它决定了 Flink CDC 的启动模式是全量模式还是增量模式。

检查逻辑是否正确:确认 Flink CDC 作业中的逻辑是否正确,包括数据源(source)、转换操作(transforms)和输出目标(sink)。确保没有错误或遗漏的配置,以及正确处理了增量数据。

检查 PostgreSQL 是否开启了逻辑解码(logical decoding):在 PostgreSQL 中,Flink CDC 需要借助逻辑解码来实现增量数据的捕获。请确保您的 PostgreSQL 实例已经启用了逻辑解码功能,并且为使用 Flink CDC 的用户授予了相应的权限。可以参考 PostgreSQL 文档中关于逻辑解码的部分进行设置和配置。

检查 PostgreSQL 的 WAL 日志是否可用:Flink CDC 需要访问 PostgreSQL 的 WAL(Write-Ahead Logging)日志,以获取增量数据变更。请确保 WAL 日志可用,且能够被 Flink CDC 访问到。需要注意的是,WAL 日志可能会受到配置、权限或日志清理策略的影响。

检查 Flink CDC 版本和 PostgreSQL 版本的兼容性:确保使用的 Flink CDC 版本与您的 PostgreSQL 版本兼容,并且支持适当的增量捕获功能。某些版本的 Flink CDC 可能对 PostgreSQL 的特定版本或功能有限制。

如果你在使用 Flink CDC 读取 PostgreSQL 数据时只能获取到全量数据,而无法获取增量数据,可能存在以下几个可能的原因:

配置问题:检查你的 Flink CDC 配置是否正确。确保配置中指定了正确的数据库连接信息、表名和列名等。特别需要确认是否正确配置了 PostgreSQL 的逻辑复制(logical replication)。

逻辑复制配置问题:Flink CDC 利用 PostgreSQL 的逻辑复制功能来捕获增量数据变化。你需要确保 PostgreSQL 数据库已经启用了逻辑复制,并且相应的发布者(publisher)和订阅者(subscriber)已正确配置。请参考 PostgreSQL 文档以了解如何正确配置逻辑复制。

权限问题:确保 Flink CDC 运行的用户具有足够的权限来访问和订阅 PostgreSQL 的逻辑复制流。在 PostgreSQL 中,逻辑复制的访问权限由 pg_hba.conf 配置文件和数据库角色权限控制。

数据库版本兼容性:Flink CDC 对 PostgreSQL 的版本有一定的要求。确保你使用的 PostgreSQL 版本与 Flink CDC 兼容,并且支持逻辑复制功能。查阅 Flink CDC 的官方文档或社区资源,了解支持的 PostgreSQL 版本和要求。

如果你在使用 Flink CDC 读取 PostgreSQL 数据库时只能获取到全量数据,而无法获取增量数据,可能有以下几个原因导致:

数据库配置问题:请确保你的 PostgreSQL 数据库已经开启了 WAL(Write-Ahead Logging)机制,并且对应的配置项 wal_level 设置为 logical。这是必要的,因为 Flink CDC 使用 PostgreSQL 的逻辑复制功能来捕获增量变更。

用户权限问题:请确保你使用的数据库用户具有访问和复制数据的权限。Flink CDC 需要使用一个具有逻辑复制权限的用户来连接到 PostgreSQL 数据库并读取增量数据。

表配置问题:请检查你的 Flink CDC 程序是否正确配置了需要读取的 PostgreSQL 表。确保表名、数据库名、模式等信息都正确无误,并且在数据库中存在对应的表。

CDC Connector 配置问题:请检查你的 Flink CDC Connector 的配置是否正确。特别是 debezium.snapshot.mode 参数,它控制 CDC Connector 是否从头开始读取全量数据。如果该参数设置为 initial,则 CDC Connector 会从数据库中全量读取数据。如果你希望获取增量数据,可以将该参数设置为 never 或者 initial_schema_only。

数据库版本兼容性问题:请确保你使用的 Flink CDC 版本与你的 PostgreSQL 数据库版本兼容。不同版本的数据库可能会有一些差异和限制,导致 CDC 无法正常工作。

如果您使用Flink CDC读取PostgreSQL中的数据时,只能获取到全量数据,而无法获取到增量数据,可能是由于以下原因导致的:

PostgreSQL的binlog未开启:如果PostgreSQL的binlog未开启,那么Flink CDC就无法获取到增量数据。您可以检查PostgreSQL的binlog是否开启,如果未开启,则需要开启PostgreSQL的binlog。

PostgreSQL的版本过低:如果PostgreSQL的版本过低,那么可能无法支持binlog功能。您可以检查PostgreSQL的版本是否过低,如果版本过低,则需要升级PostgreSQL的版本。

Flink CDC的配置不正确:如果Flink CDC的配置不正确,例如配置文件中的表名、列名、索引名等信息与实际情况不符,那么Flink CDC可能无法正确读取数据。您可以检查Flink CDC的配置文件,确保其中的信息与实际情况相符。

PostgreSQL的数据类型不支持:如果PostgreSQL中的数据类型不支持,那么Flink CDC可能无法正确读取数据。您可以检查PostgreSQL中的数据类型是否支持,如果不支持,则需要修改PostgreSQL中的数据类型。

需要注意的是,不同的情况可能需要不同的解决方案,因此需要根据具体情况进行调整和优化。同时,您可以使用Flink CDC提供的TableFunction接口,自定义一个TableFunction实现类,对读取到的数据进行特殊过滤,以避免出现表字段变少的情况。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。