版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

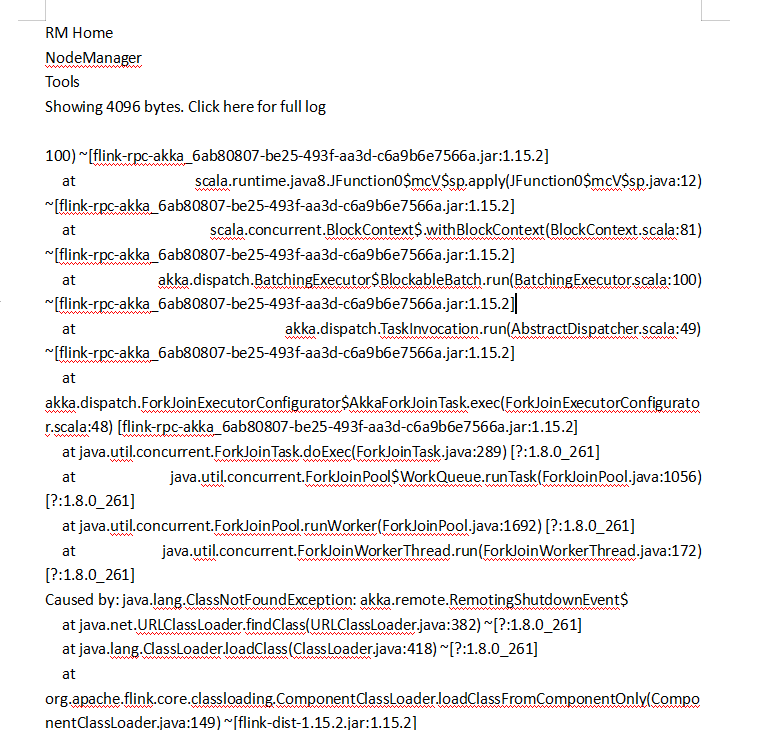

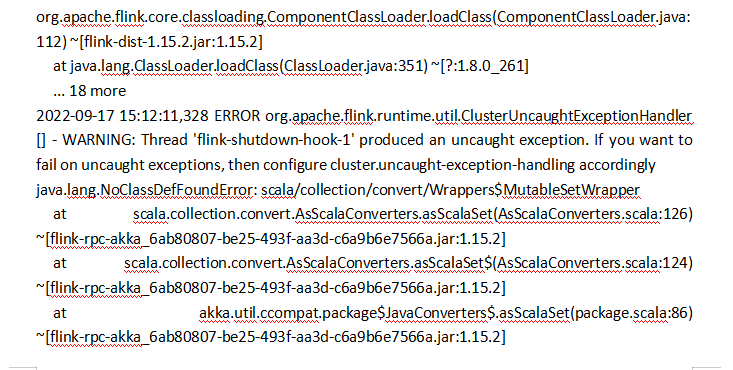

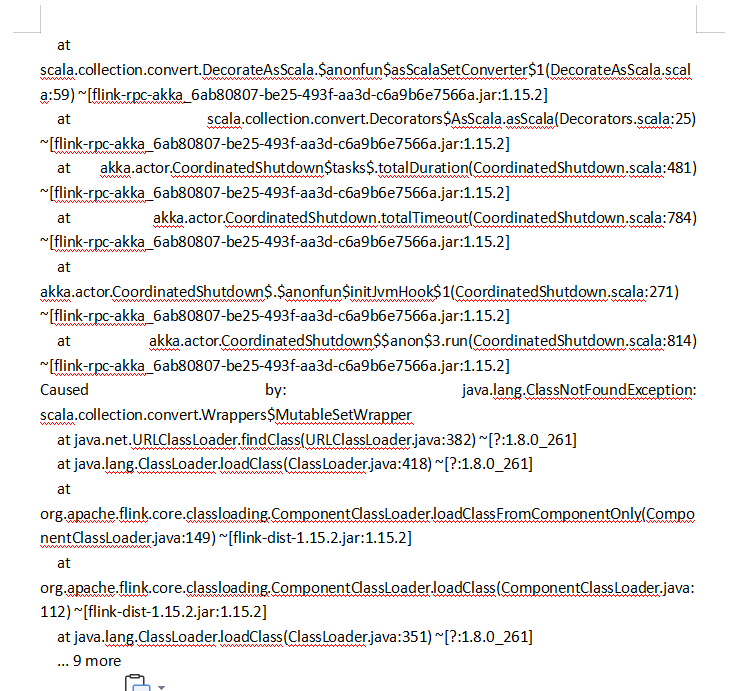

根据看到的日志,问题出现在Flink RPC的Akka模块上,可能由于缺少类引起的ClassNotFoundException。

解决这个问题,可以尝试以下方法:

检查Flink版本是否与容器环境相匹配。确保使用的Flink版本与容器环境中的Hadoop版本和其他组件的版本兼容。

检查flink-dist.jar文件是否完整。有时文件损坏或未正确解压缩可能会导致类缺失。可以尝试删除flink-dist.jar文件并重新下载和解压缩它。

检查flink-rpc-akka.jar文件是否完整。同样,可以尝试删除该文件并重新下载和解压缩。

如果还是无法解决问题,可以考虑升级或降级Flink版本,或者尝试使用其他容器环境来运行Flink集群。

在 Flink on YARN 模式下,使用者需要创建一个 Flink Application,然后将其打包成一个 JAR 文件,然后通过 YARN 提交该 JAR 文件到 Hadoop 集群中。在提交过程中,需要指定一些参数,比如应用程序名称、应用程序主类、所需的容器和资源等。然后,YARN 会负责启动该应用程序,并分配所需的资源。一旦应用程序启动,就可以使用 Flink Web UI 或者 Flink 命令行工具来监控和管理应用程序。

Flink on YARN 模式具有以下优点:

集成性强:Flink on YARN 可以很好地与 Hadoop 生态系统进行集成,包括 HDFS、YARN 和 Hive 等。

资源利用率高:由于 YARN 可以动态分配资源,因此 Flink on YARN 可以更加高效地利用集群资源。

可伸缩性强:Flink on YARN 支持动态扩缩容,可以根据应用程序的需要自动调整容器的数量和分配的资源量。

易于维护管理:通过使用 YARN,可以很方便地管理和监控 Flink 应用程序,同时还可以利用 Hadoop 的安全性和身份验证功能来保护数据的安全性。

对于这个问题,可能有以下几种解决方案:

确认Hadoop配置文件路径是否正确,是否存在 运行Flink时需要Hadoop配置文件,如果配置文件路径不正确或配置文件不存在,可能会导致报错。此时,可以确认一下配置文件路径是否正确,配置文件是否存在。

检查环境变量是否正确设置 Hadoop配置文件路径可能是通过环境变量设置的,检查一下环境变量是否正确设置。

确认Flink的Hadoop版本是否匹配 如果Flink的Hadoop版本与集群中的Hadoop版本不匹配,可能也会导致报错。此时,需要确认Flink的Hadoop版本是否与集群中的Hadoop版本匹配。

确认yarn-site.xml文件是否存在 yarn-site.xml文件是Hadoop的配置文件之一,如果该文件不存在,可能会导致报错。此时,需要确认yarn-site.xml文件是否存在,并确认路径是否正确。

检查是否有权限访问Hadoop配置文件 如果没有权限访问Hadoop配置文件,也会导致报错。此时,需要确认是否有权限访问Hadoop配置文件。

综上所述,上述解决方案中的任一一个可能会解决该问题。

这个问题可能是由于在Flink on Yarn中使用了Scala的版本不兼容导致的。建议您确认Flink版本和Scala版本是否兼容。Flink 1.13.x推荐使用Scala 2.12.x版本,Flink 1.14.x和1.15.x推荐使用Scala 2.12.x或者2.11.x版本。

如果您的Flink版本和Scala版本是兼容的,那么可能是您的Flink on Yarn环境配置有问题。建议您尝试以下几个步骤来解决问题:

检查Flink on Yarn的Classpath是否正确配置。可以检查“flink-conf.yaml”文件中的“yarn.application.classpath”属性是否正确配置,确保包含了必要的依赖项。

检查集群的运行环境是否正确配置。可能会受到操作系统、JDK版本、内存、CPU等因素的影响。建议您检查Yarn的日志,查看是否有相关的错误信息。

确认Flink on Yarn的启动命令是否正确。建议您检查启动脚本中的相关配置参数,确保参数值正确。

确认Yarn配置是否正确。建议您检查Yarn的配置文件,确保Flink on Yarn的配置与Yarn的配置相匹配。

如果以上步骤无法解决问题,建议您尝试重新安装Flink on Yarn环境或者升级Flink和Scala的版本,以解决兼容性问题。

如果您还遇到其他问题,可以查看Flink on Yarn的官方文档或者在Flink社区中寻求帮助。

楼主你好,根据你的报错提示可以知道,在Flink运行的时候没有找到可以正常使用的Hadoop配置文件引起的报错,你可以查看一下Hadoop配置文件,以及设置的路径是否正确。

根据截图,可以看到 Flink on Yarn 应用程序的日志中报告了 ClassNotFoundException 错误,该错误可能由于缺少相关类或 JAR 包导致。

你可以尝试检查你的应用程序是否引用了缺少的类或库,或者在应用程序中的 Classpath 中添加缺少的 JAR 包,以解决这个问题。此外,还可以检查 YARN 集群的配置,确保所有节点上的环境变量和类路径设置正确。

这个错误信息看起来像是在使用 Flink on YARN 时,提交的应用程序在执行过程中出了问题。错误日志中的堆栈跟踪信息可能会提供有关问题的更多细节。

首先,第一行提示 RM Home NodeManagerTools 显示了 4096 字节,但需要点击“Click here for full log”以获取完整的日志。建议查看完整日志以获取更多细节。

接下来,错误信息中提到了一些类未找到的异常(ClassNotFoundException)。这可能表示应用程序正在尝试加载一些类,但无法找到这些类的定义。这可能是由于依赖项问题或类路径问题引起的。

最后,如果您无法定位问题,可以尝试向 Flink 社区寻求帮助,或查看 Flink 官方文档以获取更多信息。

这个问题是由Flink运行时环境没有找到正确的Hadoop配置文件引起的。在Flink on Yarn模式下,Flink需要依赖Hadoop的配置文件环境来设置HDFS、Yarn的配置信息。根据你提供的错误信息可以看出,Flink的运行环境找不到正确的hadoop配置文件。

解决方法有以下两种:

env:

hadoop-conf-dir: /path/to/hadoop/conf

export HADOOP_CONF_DIR=/path/to/hadoop/conf

然后重新启动Flink on Yarn并提交应用程序即可。

推测可能是以下几个方面引起的:

1、Flink版本不兼容:你可能使用了不兼容的 Flink 版本。建议检查应用程序依赖的 Flink 版本是否与 Flink 集群版本匹配。如果版本不兼容,可能会导致许多奇怪的错误,包括无法访问 Web UI。

2、应用程序配置错误:检查应用程序的配置文件,确保所有必需的配置都正确设置。特别是,检查是否有错误的端口号或其他不正确的配置参数。

3、YARN配置错误:检查 YARN 集群的配置文件,确保所有必需的配置都正确设置。特别是,检查是否有错误的端口号或其他不正确的配置参数。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。