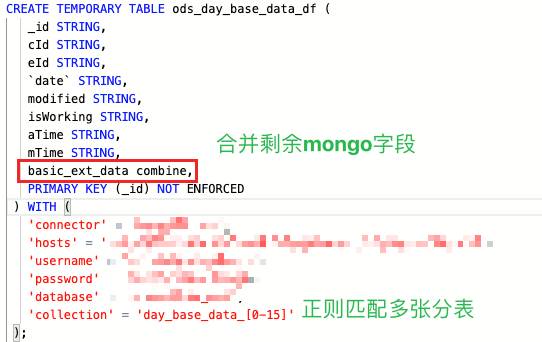

使用mongocdc读表,可以将剩余mongo集合字段合到一起吗?类似combine这种,然后mongo匹配多个集合正则可以这样用吗?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在使用MongoDB CDC(Change Data Capture)读取多个集合的数据时,确实可以配置正则表达式来匹配多个集合,实现对多个集合的监控。具体操作如下:

集合匹配正则表达式: 在构造MongoDBSource时,通过设置collectionList参数,你可以使用正则表达式来指定需要监控的集合名称。例如,如果你想监控所有名称以orders_开头的集合,可以这样配置:

MongoDBSource.builder()

.setCollectionList("orders_.*") // 正则表达式匹配所有以'orders_'开头的集合

...

.build();

这样,任何符合该正则表达式的集合都会被包含在数据捕获的范围内。

合并多个集合字段: 但是,直接在MongoDB CDC连接器中将多个集合的字段合并为一个输出流的功能并不直接支持。MongoDB CDC主要设计用于捕获每个集合内变更事件,并保持其独立性。如果你需要将不同集合的数据合并处理,通常建议在Flink作业的下游操作中实现这一需求,比如通过flatMap、join或其他算子来整合来自不同源的数据流。

例如,你可以先为每个感兴趣的集合创建单独的数据流,然后使用Flink的流处理能力来合并这些流中的数据,实现类似“combine”的效果。这可能涉及到定义自定义逻辑来决定如何合并这些集合的数据字段。

总结来说,MongoDB CDC连接器支持使用正则表达式匹配并订阅多个集合,但不直接提供合并不同集合字段到单一流的功能。你需要利用Flink的流处理能力来实现数据的进一步整合和处理。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。