常用的负载均衡开源软件有: nginx、lvs、keepalived

商业的硬件负载设备: F5、Netscale

1. LB、LVS介绍LB集群是load balance 集群的简写,翻译成中文就是负载均衡集群

http://www.aminglinux.com/bbs/data/attachment/forum/201406/16/115112w1we1x4e5ueewzrd.png

LVS是一个实现负载均衡集群的开源软件项目

LVS架构从逻辑上可分为调度层(Director)、server集群层(Real server)和共享存储层

LVS可分为三种工作模式: ( dr模式参考这篇文章 http://os.51cto.com/art/201105/264303.htm 这篇介绍的还是挺详细的:http://www.it165.net/admin/html/201401/2248.html )

LVS的三种工作模式:

1.NAT模式-网络地址转换

2.TUN模式-- (tunneling)客户把请求封装成IP

3.DR模式(直接路由模式)请求数据的MAC地址

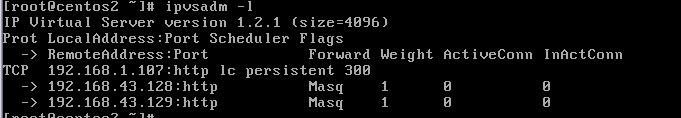

2. LVS/NAT 配置

三台服务器一台作为director, 两台作为real server

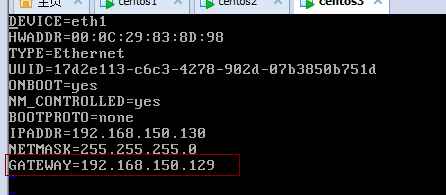

Director 有一个外网ip (192.168.31.166) 和一个内网ip(192.168.21.166), 两个real server上只有内网ip(192.168.21.100)和(192.168.21.101) 并且需要把两个real server的内网网关设置为director的内网ip(192.168.21.166)

vmware网络设置: http://www.apelearn.com/bbs/thread-10536-1-1.html

两个real server 上都安装httpd: yum install -y nginx

Director上安装ipvsadm yum install -y ipvsadm

Direcotr 上 vim /usr/local/sbin/lvs_nat.sh //增加:

#! /bin/bash

# director 服务器上开启路由转发功能:

echo 1 > /proc/sys/net/ipv4/ip_forward

# 关闭icmp的重定向

echo 0 > /proc/sys/net/ipv4/conf/all/send_redirects

echo 0 > /proc/sys/net/ipv4/conf/default/send_redirects

echo 0 > /proc/sys/net/ipv4/conf/eth0/send_redirects

echo 0 > /proc/sys/net/ipv4/conf/eth1/send_redirects

# director 设置nat防火墙

iptables -t nat -F

iptables -t nat -X

iptables -t nat -A POSTROUTING -s 192.168.21.0/24 -j MASQUERADE

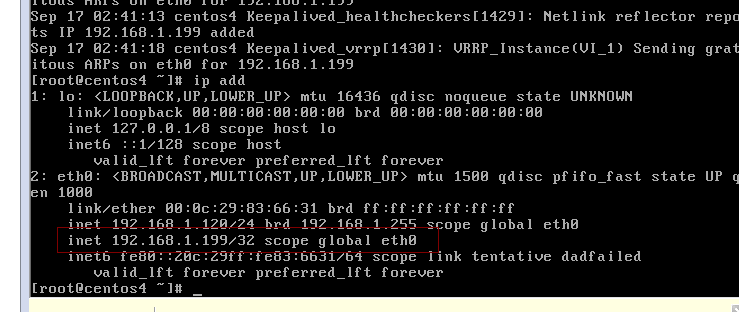

# director设置ipvsadm

IPVSADM='/sbin/ipvsadm'

$IPVSADM -C

$IPVSADM -A -t 192.168.31.166:80 -s lc -p 300

$IPVSADM -a -t 192.168.31.166:80 -r 192.168.21.100:80 -m -w 1

$IPVSADM -a -t 192.168.31.166:80 -r 192.168.21.101:80 -m -w 1

直接运行这个脚本就可以完成lvs/nat的配置了:

/bin/bash /usr/local/sbin/lvs_nat.sh

俩台客户机分别启动nginx: /etc/init.d/nginx start

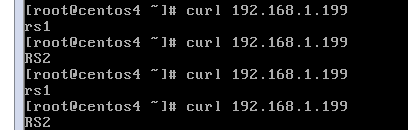

通过浏览器测试两台机器上的web内容,为了区分开,我们可以把nginx的默认页修改一下:

rs1上: echo "rs1rs1" >/usr/share/nginx/html/index.html

rs2上: echo "rs2rs2" >/usr/share/nginx/html/index.html

real server

re-server (俩台内网IP,外网不要)

Dicr 一个内网,一个外网

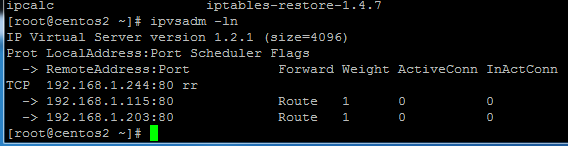

3. LVS/DR 配置

三台机器:

director(eth0192.168.31.166, vip eth0:0: 192.168.31.110)

real server1(eth0 rip: 192.168. 31.100, vip lo:0: 192.168.31.110)

real server2(eth0 rip: 192.168.31.101, vip lo:0: 192.168.31.110)

Director 上 vim /usr/local/sbin/lvs_dr.sh //增加

#! /bin/bash

echo 1 > /proc/sys/net/ipv4/ip_forward

ipv=/sbin/ipvsadm

vip=192.168.31.110

rs1=192.168.31.100

rs2=192.168.31.101

ifconfig eth0:0 $vip broadcast $vip netmask 255.255.255.255 up

route add -host $vip dev eth0:0

$ipv -C

$ipv -A -t $vip:80 -s rr

$ipv -a -t $vip:80 -r $rs1:80 -g -w 1

$ipv -a -t $vip:80 -r $rs2:80 -g -w 1

不用安装 ipvsadm

两台rs上:vim /usr/local/sbin/lvs_dr_rs.sh

#! /bin/bash

vip=192.168.31.110

ifconfig lo:0 $vip broadcast $vip netmask 255.255.255.255 up

route add -host $vip lo:0

echo "1" >/proc/sys/net/ipv4/conf/lo/arp_ignore

echo "2" >/proc/sys/net/ipv4/conf/lo/arp_announce

echo "1" >/proc/sys/net/ipv4/conf/all/arp_ignore

echo "2" >/proc/sys/net/ipv4/conf/all/arp_announce

关于arp_ignore和 arp_announce 参考:http://www.cnblogs.com/lgfeng/archive/2012/10/16/2726308.html

然后director上执行: bash /usr/local/sbin/lvs_dr.sh

两台rs上执行: bash /usr/local/sbin/lvs_dr_rs.sh

Windows下浏览器测试访问

vip都是虚拟出来的网卡

4. LVS/DR + keepalived配置

注意:前面虽然我们已经配置过一些操作,但是下面我们使用keepaliave操作和之前的操作是有些冲突的,所以若是之前配置过DR,请首先做如下操作:dr上执行:

$ipv -C

ifconfig eth0:0 down

前面的lvs虽然已经配置成功也实现了负载均衡,但是我们测试的时候发现,当某台real server把httpd进程停掉,那么director照样会把请求转发过去,这样就造成了某些请求不正常。所以需要有一种机制用来检测real server的状态,这就是keepalived。它的作用除了可以检测rs状态外,还可以检测备用director的状态,也就是说keepalived可以实现ha集群的功能,当然了也需要一台备用director.

备用director也需要安装一下keepalived软件

yum install -y keepalived

安装好后,编辑配置文件

vim /etc/keepalived/keepalived.conf //加入如下:

vrrp_instance VI_1 {

state MASTER #备用服务器上为 BACKUP

interface eth0

virtual_router_id 51

priority 100 #备用服务器上为90

advert_int 1

authentication {

auth_type PASS

auth_pass 1111

}

virtual_ipaddress {

192.168.31.110

}

}

virtual_server 192.168.31.110 80 {

delay_loop 6 #(每隔10秒查询realserver状态)

lb_algo wlc #(lvs 算法)

lb_kind DR #(Direct Route)

persistence_timeout 60 #(同一IP的连接60秒内被分配到同一台realserver)

protocol TCP #(用TCP协议检查realserver状态)

real_server 192.168.31.100 80 {

weight 100 #(权重)

TCP_CHECK {

connect_timeout 10 #(10秒无响应超时)

nb_get_retry 3

delay_before_retry 3

connect_port 80

}

}

real_server 192.168.31.101 80 {

weight 100

TCP_CHECK {

connect_timeout 10

nb_get_retry 3

delay_before_retry 3

connect_port 80

}

}

}

以上为主director的配置文件,从director的配置文件只需要修改

state MASTER -> state BACKUP

priority 100 -> priority 90

配置完keepalived后,需要开启端口转发(主从都要做):

echo 1 > /proc/sys/net/ipv4/ip_forward

然后,两个rs上执行 /usr/local/sbin/lvs_dr_rs.sh 脚本

最后,两个director上启动keepalived服务(先主后从):

/etc/init.d/keepalived start

另外,需要注意的是,启动keepalived服务会自动生成vip和ipvsadm规则,不需要再去执行上面提到的/usr/local/sbin/lvs_dr.sh 脚本。

停掉主上的keepalived ,看从上的是不是有以下的

本文转自 15816815732 51CTO博客,原文链接:http://blog.51cto.com/68686789/1854289