下面这个 时间窗口 FlinkSql,源表260万数据,直接转化后插入目标表,这种量级的话,正常要多长时间?INSERT INTO sink_output(user_id,window_start,window_end,order_num)SELECTuser_id,HOP_START(ts, INTERVAL '30' SECOND, INTERVAL '1' MINUTE) as window_start,HOP_END(ts, INTERVAL '30' SECOND,INTERVAL '1' MINUTE) as window_end,COUNT(1) as order_numFROM source_clicksGROUP BY HOP(ts,INTERVAL '30' SECOND, INTERVAL '1' MINUTE),user_id;

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

根据您提供的信息,源表有260万条数据,使用Flink SQL进行时间窗口聚合操作后插入目标表。由于具体的执行时间和性能取因素,如集群规模、网络带宽、硬件配置等,无法给出一个准确的时间估计。

然而,一般来说,对于这种量级的数,Flink SQL的执行速度相快。在理想情况下,处理260万条数据的时间可能在几分钟到几十分钟之间。但请注意,这只是一个大致的估计,实际执行时间可能会有所不同。

为了更准确地评估执行时间,建议您在实际环境中运行该作业,并观察作业的执行情况和性能指标。此外,您还可以考虑调整Flink集群的配置参数,以提高处理速度和性能。

根据您提供的信息,源表有260万条数据,使用Flink SQL进行时间窗口聚合操作后插入目标表。由于具体的性能取决于多个因素,如集群规模、硬件配置、网络带宽等,无法给出一个准确的时间估计。

然而,一般来说,对于这种量级的数据,Flink SQL的时间窗口聚合操作应该可以在几分钟内完成。但是,实际的执行时间可能会受到上述因素的影响而有所不同。

为了更准确地估处理时间,建议您在VVP平台上运行您的Flink任务,并观察任务的执行情况和日志输出。这样可以帮助您更好地了解任务的性能表现,并根据需要进行优化。

由于问题中并没有给出具体硬件配置、Flink集群规模、源表数据分布以及其他可能影响性能的因素,无法准确预测执行这段Flink SQL的时间窗口操作所需的确切时间。但是,我们可以分析几个关键因素:

数据分布:260万数据分布在哪些时间窗口内,如果数据均匀分布,那么每个窗口的处理时间相对较短;若集中在某几个窗口,可能会造成热点窗口处理时间较长。

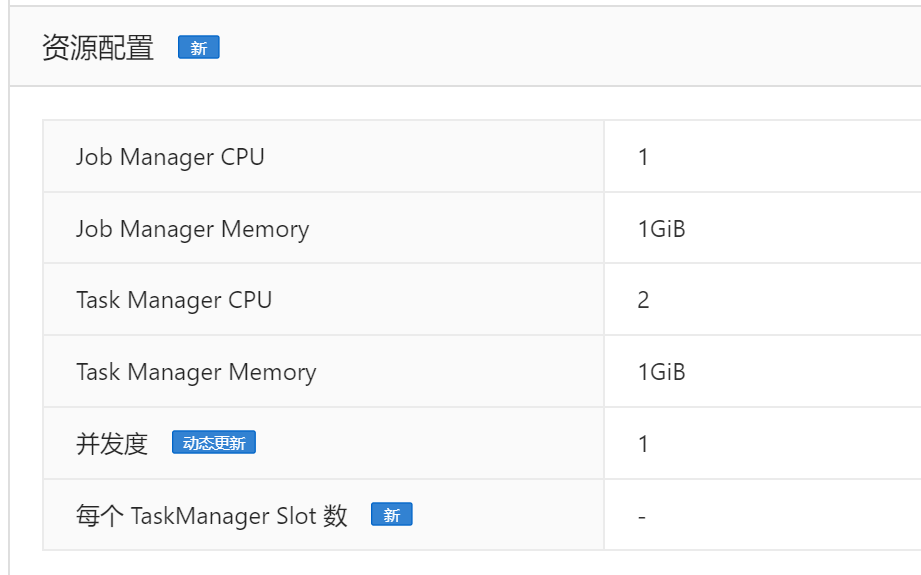

集群配置:Flink集群的资源配置,包括CPU、内存、网络速度以及并发度等因素都会影响处理速度。

窗口计算复杂性:此处使用的HOP窗口每30秒滑动一次,每次窗口持续1分钟,窗口操作主要是COUNT(1)计数,相对简单,但如果还有其他复杂的聚合操作,时间会增加。

状态后端性能:Flink作业在执行窗口操作时需要维护状态,状态后端(如RocksDB)的性能对整体处理时间也有影响。

数据读写速度:源表和目标表的数据读取和写入速度,取决于底层数据库或存储系统的性能。

Flink作业优化:是否启用了批处理模式(Batch execution mode)、是否开启了checkpoint优化等都可能影响执行效率。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。