Flink CDC怎么获取source的schema?

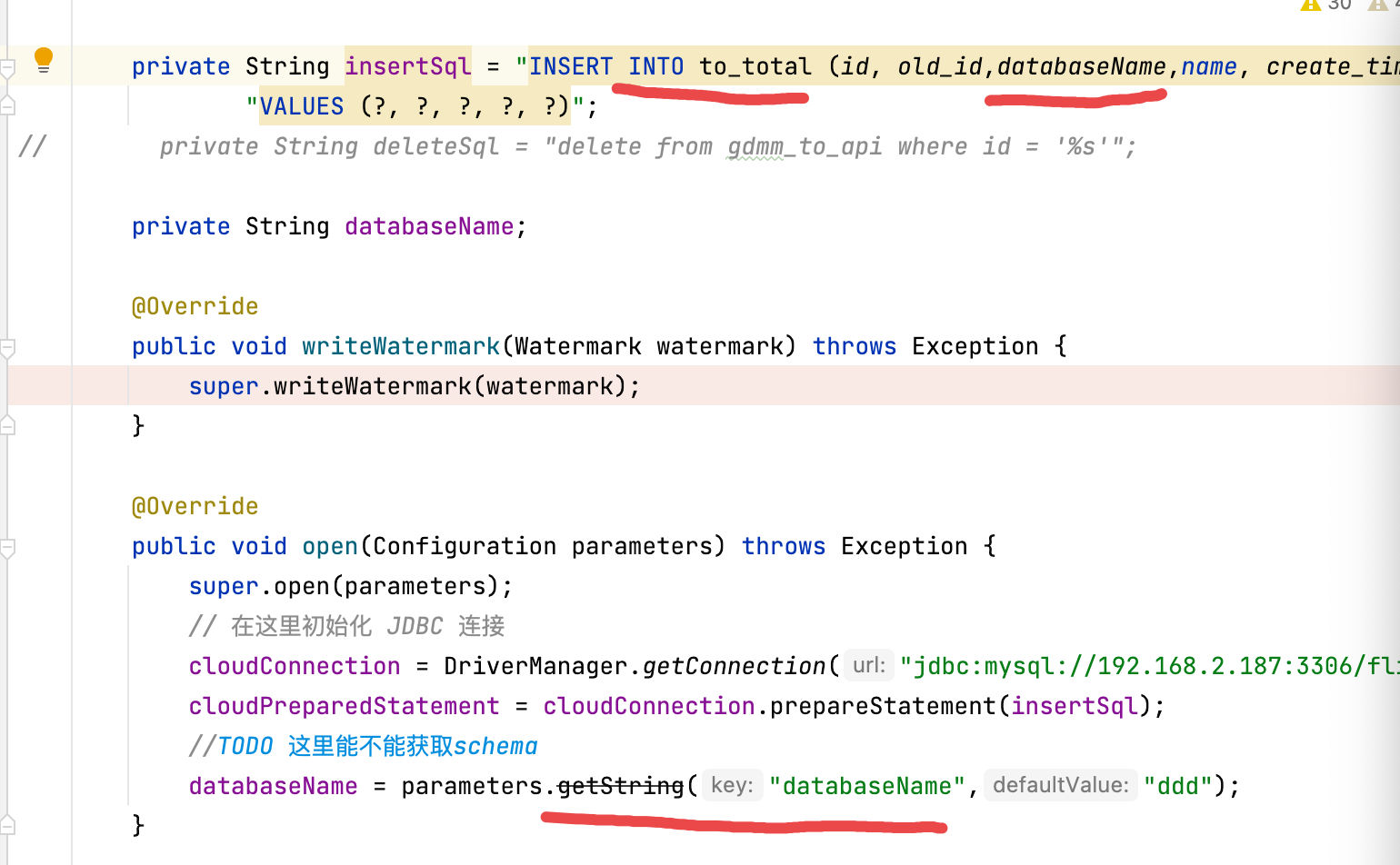

Flink CDC自定义的 RichSinkFunction 里,怎么获取source的schema?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

-

面对过去,不要迷离;面对未来,不必彷徨;活在今天,你只要把自己完全展示给别人看。

在 Flink CDC 的自定义 RichSinkFunction 中,可以通过以下方式获取 source 的 schema:

- 首先,确保你的 RichSinkFunction 实现了

RichSinkFunction接口。 - 在

open方法中,通过RuntimeContext获取到ExecutionConfig。 - 使用

ExecutionConfig的getTableConfig()方法获取到TableConfig。 - 最后,通过

TableConfig的getSchema()方法获取到 source 的 schema。

以下是一个简单的示例代码:

import org.apache.flink.api.common.typeinfo.TypeInformation; import org.apache.flink.streaming.api.functions.sink.RichSinkFunction; import org.apache.flink.table.api.bridge.java.StreamTableEnvironment; import org.apache.flink.table.catalog.ObjectPath; import org.apache.flink.table.catalog.ResolvedSchema; import org.apache.flink.table.catalog.Schema; import org.apache.flink.table.catalog.TableCatalog; import org.apache.flink.table.catalog.hive.HiveCatalog; import org.apache.flink.table.descriptors.SchemaDescriptor; import org.apache.flink.table.descriptors.TableDescriptor; import org.apache.flink.table.factories.TableFactory; import org.apache.flink.table.factories.utils.FactoryUtil; public class CustomRichSinkFunction extends RichSinkFunction<MySourceData> { private TableCatalog tableCatalog; private String tableName; @Override public void open(Configuration parameters) throws Exception { // 创建 TableCatalog 实例 tableCatalog = new HiveCatalog(new HiveConf()); // 注册表 tableCatalog.registerTable(new ObjectPath("default", "my_source_table"), new TableDescriptor(new SchemaDescriptor(new ResolvedSchema()))); // 获取 TableFactory TableFactory tableFactory = FactoryUtil.findFactory(tableCatalog, new ObjectPath("default", "my_source_table")); // 获取 TableEnvironment StreamTableEnvironment tableEnvironment = StreamTableEnvironment.create(parameters); // 加载表结构 tableEnvironment.loadAs("insert into " + tableName + " ...", tableFactory); } @Override public void invoke(MySourceData value, Context context) throws Exception { // 获取 source 的 schema TypeInformation<?>[] fieldTypes = value.getClass().getDeclaredFields().stream() .map(field -> TypeInformation.of(field.getType())) .toArray(TypeInformation[]::new); Schema sourceSchema = new Schema(fieldTypes); // 在这里处理数据,并使用 sourceSchema 进行转换 } }在这个示例中,我们首先创建了一个

TableCatalog实例,并注册了一个名为my_source_table的表。然后,我们通过TableFactory和TableEnvironment加载了表的结构,并将其存储在sourceSchema变量中。在invoke方法中,我们可以使用这个sourceSchema来处理数据并进行转换。2024-01-09 15:37:33赞同 展开评论 - 首先,确保你的 RichSinkFunction 实现了

-

在Apache Flink的CDC(Change Data Capture)场景下,如果你自定义了一个RichSinkFunction来处理从源数据库捕获的变更数据,并希望获取源数据的schema信息,通常情况下并不直接在SinkFunction中访问source的原始schema。不过,你可以通过以下方式间接获取或利用schema:

使用Flink SQL CDC Source:

- 如果你是在Flink SQL中使用了内置的或者第三方的CDC connector(例如MySQL CDC、PostgreSQL CDC等),并且sink端的数据格式是结构化的(如Avro、JSON等),可以通过Flink的类型系统获取到转换后的数据类型信息。这意味着,当你在写入数据时,每个字段已经根据Flink表的schema进行了映射。

Schema Registry集成:

- 对于具有schema管理功能的消息中间件(如Kafka与Confluent Schema Registry配合),可以在消费端从Schema Registry获取对应Topic的schema,但这不是直接从Flink CDC source获取的。

SourceRecord和DeserializationSchema:

- 如果你在纯DataStream API中开发,可以定制一个

DeserializationSchema来解析源数据。在这个类中,可以实现解析逻辑并从源数据的元数据中获取schema信息。对于某些连接器(比如Debezium提供的connector),其SourceRecord对象可能包含了关于源数据的schema信息。

- 如果你在纯DataStream API中开发,可以定制一个

Schema信息传递:

- 在自定义的CDC流程中,如果源头已经有了schema信息,可以考虑在数据转换过程中将必要的schema信息作为额外的元数据携带在数据流中,然后在RichSinkFunction中读取这些元数据。

举个例子,在Flink的DataStream API中,如果你自定义了一个

DeserializationSchema并实现了getProducedType()方法,这个方法返回的就是Flink内部表示的schema类型,而在RichSinkFunction中,可以从传入的IN类型元素获取相应的字段信息。但请注意,这并不是直接获取源数据库的原始schema,而是经过Flink DeserializationSchema转换后的schema。2024-01-09 14:16:28赞同 展开评论

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。