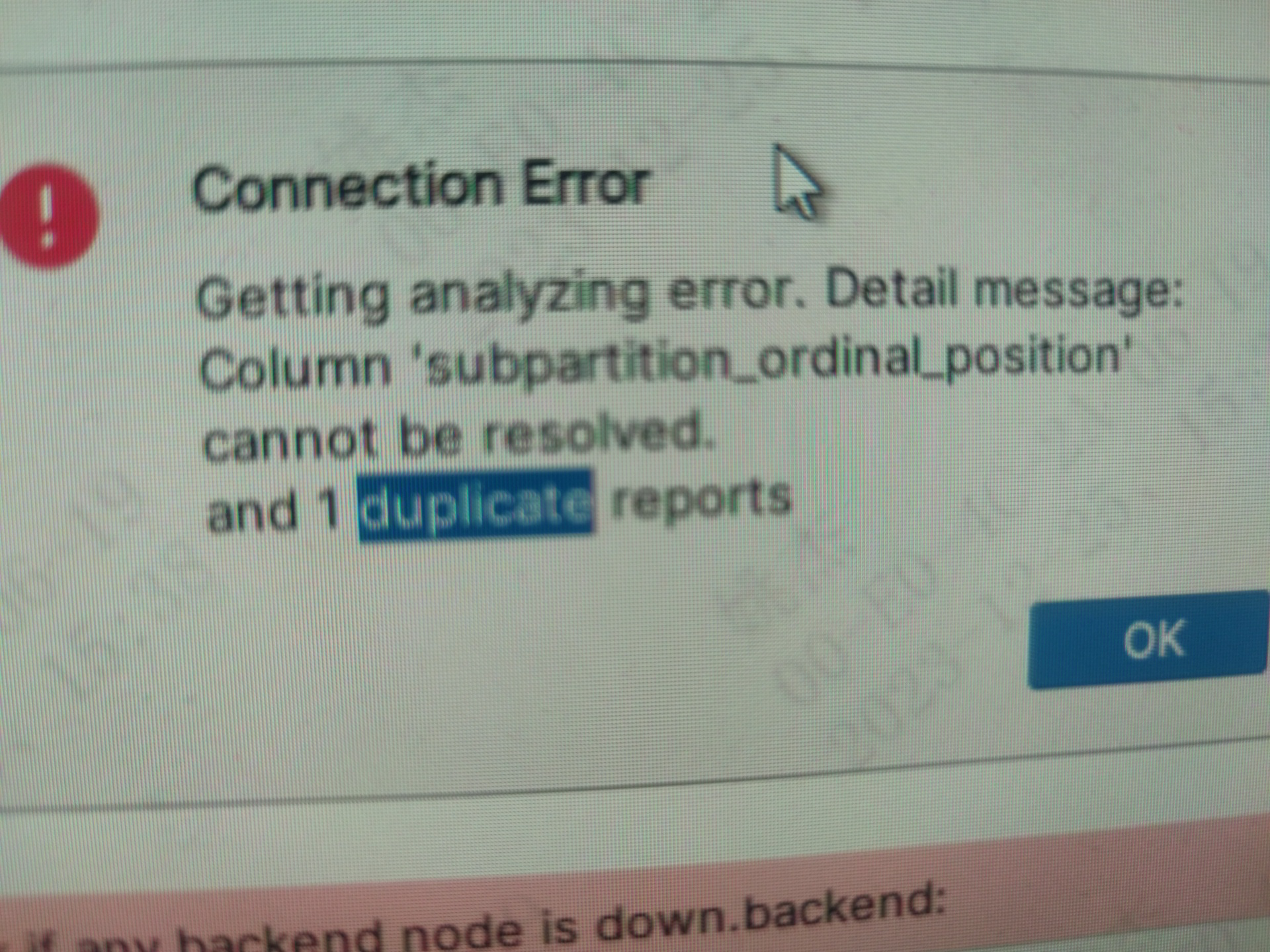

Flink CDC starrocks 3.2版本 有这个提示是什么原因?

Flink CDC starrocks 3.2版本提示:重新删掉 meta 和 storage 下数据,是什么原因?

展开

收起

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

2

条回答

写回答

-

网站:http://ixiancheng.cn/ 微信订阅号:小马哥学JAVA

从报错的日志可以看出来,是子分区的列重复导致的错误。解决方式:

第一:确保MySQL主从复制和备份恢复的配置能够尽量减少重复事件的发生。例如,可以通过调整binlog_format参数来控制MySQL Binlog的格式,以减少重复事件的数量。第二:使用Flink CDC的重试机制。虽然这可能会增加一些额外的开销,但是它可以保证在处理重复事件时不会丢失任何数据。

第三:对于特定的应用场景,可以考虑使用更高级的解决方案,如基于Kafka或Pulsar等消息队列的CDC服务,这些服务通常具有更好的容错能力和处理重复事件的能力。

2023-12-31 11:44:26赞同 展开评论 -

问答分类:

问答地址:

开发者社区

>

大数据与机器学习

>

实时计算 Flink

>

问答

相关问答

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。

相关文章

热门讨论

热门文章

展开全部

还有其他疑问?

咨询AI助理