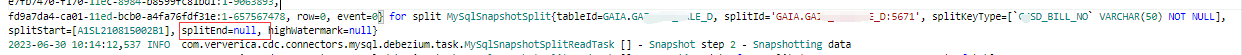

咨询下 Flink CDC2.4在切分chunk的时候, splitend为什么会计算错啊?

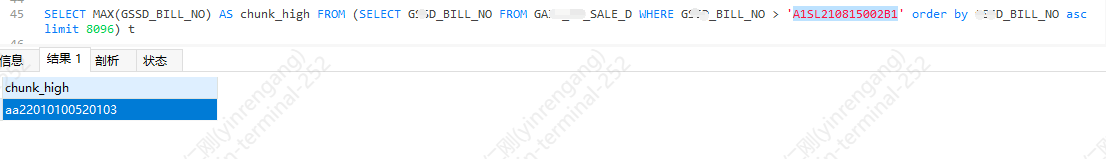

咨询下 Flink CDC2.4在切分chunk的时候, splitend为什么会计算错啊? 按照源码里的 正确的splitend应该是这个

按照源码里的 正确的splitend应该是这个

-

北京阿里云ACE会长

在 Flink CDC 2.4 中,切分 chunk 的过程中,splitend 计算错误可能是由于以下原因导致的:

数据分布不均:如果数据在不同的 chunk 中分布不均,可能导致 splitend 计算错误。例如,如果某个 chunk 中的数据量特别大,那么根据默认的 chunk 分配策略,可能会导致 splitend 计算错误。

并发度设置不当:如果并发度设置过低,可能导致 chunk 切分不均匀,从而导致 splitend 计算错误。

Flink CDC 版本问题:如果 Flink CDC 版本较老或者存在 BUG,可能会导致 splitend 计算错误。

针对这些问题,可以考虑以下优化措施:

调整 chunk 分配策略,例如通过在 Flink CDC 配置文件中设置 max.chunk.size 参数来调整 chunk 的最大大小,从而避免某个 chunk 中的数据量过大。同时,也可以通过设置其他相关参数来对 chunk 进行调优。例如:

yaml

CopyFlink CDC 配置文件

sources:

- name: mysql-source

...

maxChunkSize: 10MB # 设置 chunk 的最大大小为 10MB

maxChunkSizeBytes: 10485760 # 设置 chunk 的最大大小为 10MB,以字节为单位

chunkSize: 1MB # 设置 chunk 的大小为 1MB

chunkSizeBytes: 1048576 # 设置 chunk 的大小为 1MB,以字节为单位

调整并发度设置,例如通过设置 Flink CDC 的并发度参数来调整并发度,从而避免 chunk 切分不均匀,例如:

yaml

CopyFlink CDC 配置文件

sources: - name: mysql-source

...

parallelism: 4 # 设置并发度为 4

升级 Flink CDC 版本,以解决已知的 BUG 或者提高 Flink CDC 的性能和稳定性。

2023-07-30 09:36:47赞同 展开评论 打赏 - name: mysql-source

-

对于 Flink CDC 2.4 在切分 Chunk 的过程中,splitEnd 的计算错误可能由以下原因导致:

1. 数据源变更:如果在 CDC 运行期间发生了数据源的变更(例如表结构变更或新的分区被创建),则 splitEnd 的计算可能会出现错误。在这种情况下,建议重新启动 CDC 任务,以便正确计算 splitEnd。

2. 时间戳不准确:splitEnd 的计算依赖于时间戳信息。如果时间戳有误或者不准确,那么计算得到的 splitEnd 可能是错误的。请确保时间戳的准确性和一致性。

3. 源码实现问题:如果你在源码中找到了问题所在,并且确认 splitEnd 的计算逻辑确实存在错误,可以考虑提交一个 Bug 报告给 Flink 社区。他们将会检查并修复相关问题。

总结起来,splitEnd 计算错误的原因可能是因为数据源变更、时间戳不准确或源码实现问题。建议通过检查时间戳、观察数据源变化以及与 Flink 社区交流,以进一步解决该问题。

2023-07-30 09:36:13赞同 展开评论 打赏

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。