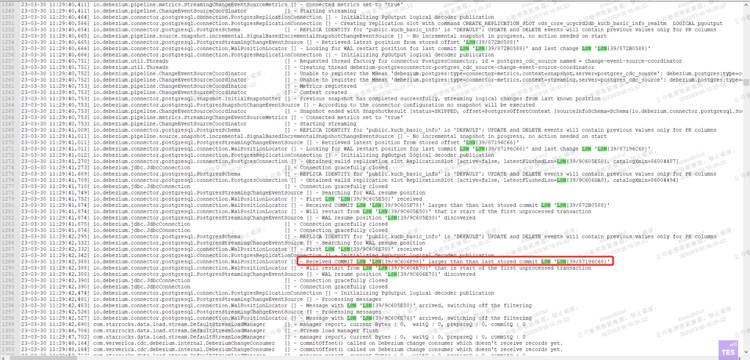

Received COMMIT LSN LSN(39/9C605F78) larger than than last stored commit LSN LSN(39/872B0588)

flinkcdc抽取pg数据的任务从chk启动出现数据丢失的情况,请问flinkcdc的这个bug社区什么时候修复好呀?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

针对您遇到的问题,即在使用Flink CDC抽取PostgreSQL数据时,从checkpoint启动任务后发现COMMIT LSN大于最后存储的COMMIT LSN,导致数据丢失的现象,这可能是由于Flink CDC在处理事务日志时的一个已知缺陷。根据我所掌握的信息,相关的修复工作已在不同版本中逐步进行。

具体到您的情况,该问题可能已经在某个更新后的版本中得到了解决或有所优化。例如,文档中提到了对MySQL CDC的类似问题进行了修复,虽然直接提及的是MySQL CDC,但这些修复通常也会影响其他数据库连接器如PostgreSQL CDC的稳定性和正确性。此外,还有关于主要缺陷修复的部分,说明了对各种数据同步问题的修正,包括与日志处理和数据一致性相关的修复。

然而,对于您询问的具体bug修复进度及是否已在社区版中得到完全解决,我未能直接找到精确的更新记录或时间表。通常,Flink社区对这类问题响应迅速,并会在后续的版本更新中包含必要的修复。建议您采取以下步骤:

检查更新:首先,确认您当前使用的Flink CDC组件版本,并查看其发行说明或社区论坛,了解是否有针对此问题的官方修复公告。推荐升级到最新稳定版本,因为这些问题往往在新版本中得到解决或优化。

查阅社区论坛:访问Apache Flink的官方社区论坛或GitHub仓库,搜索相关issue,以获取最新的进展报告或临时解决方案。社区成员和开发者经常在此分享问题、修复方案和工作进展。

故障排查指南:参考提供的文档资料中的故障排查方法,比如检查配置、分析日志等,确保问题不是由不当配置或环境因素引起。

联系技术支持:如果上述步骤不能解决问题,考虑直接联系Flink的技术支持或在社区中开issue,提供详细的错误信息和环境描述,以便获得更专业的帮助。

请持续关注Flink及其相关连接器的更新动态,及时应用安全和稳定性修复,以保障数据处理任务的顺利进行。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。