2

条回答

写回答

写回答

-

发表文章、提出问题、分享经验、结交志同道合的朋友

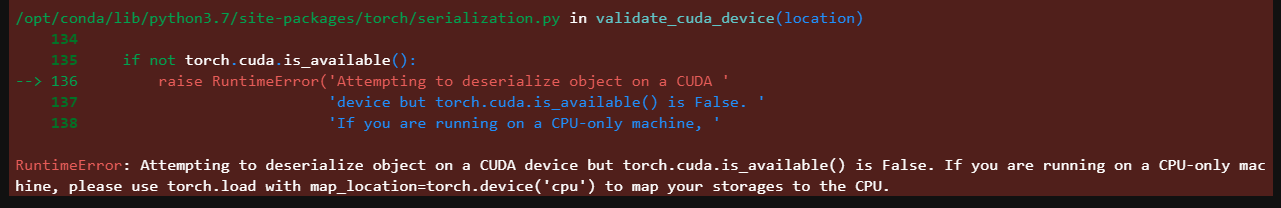

可以通过修改代码的配置来强制使用CPU进行推理。

比如使用 TensorFlow 时,可以在代码中设置os.environ['CUDA_VISIBLE_DEVICES'] = '-1',这样 TensorFlow 会强制使用 CPU 进行计算

2023-02-24 16:53:09赞同 1 展开评论 打赏 -

相关问答

热门讨论

热门文章

modelscope上跑报错,提示要pip install ttsfrd,搞不定

7549

关于 Windows平台上 ttsfrd 库的问题。

1540

KeyError: 'asr-inference is not in the pipelines r

1911

linux系统运行TTS语音合成报错 Could not initialize NNPACK

664

ttsfrd 是不开源的吗

3851

PyTorch Transformer 英中翻译超详细教程

877

目录空间都删的只剩2G了,还报OSError: [Errno 122] Disk quota exc

961

No module named 'ttsfrd'

1326

个性化语音合成训练 [ONNXRuntimeError]:7:INVALID_PROTOBUF

1057

报了很多警告,请问怎么解决?

982

展开全部