论文标题:Interpretable Rumor Detection in Microblogs by Attending to User Interactions

论文链接:https://arxiv.org/abs/2001.10667

论文来源:AAAI 2020

一、概述

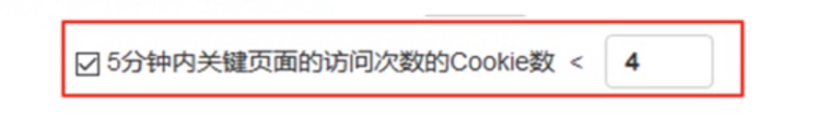

本文工作的重点是利用社区对帖子响应回复来检测帖子是否是谣言,这方面的研究旨在使用自然语言处理技术来利用社区群体智能。这类工作的关键原则是,社交媒体上的用户会发表对不准确信息的看法、猜测和证据。用户之间的互动以及分享的内容可以被捕捉,用于假新闻检测。下面是一个假新闻及其评论的样本:

example

之前有方法将源推文和响应推文组织成上述树状结构,节点的父亲节点是该推文所回复的推文,然后使用树模型(递归神经网络或者tree LSTMs等)来进行谣言检测,目的是对对话过程中的结构信息进行建模。在树形结构中,信息要么从父亲节点流向子节点,要么反过来,然而使用这样的树形结构来建模对话过程的结构可能是不够的。每个用户通常都能观察到对话中不同分支的所有回复。一个用户揭穿一个假新闻可能不只是针对他要回复的人,他发表的内容可能也针对整个对话过程中的其他推文(这说明树的不同分支的节点之间也可能有交互)。树模型不能建模不同分支的节点之间的交互,这是它的主要限制。我们应该考虑所有推文之间的交互,而不仅仅是父亲节点和子节点之间的交互,以便更好地从回复推文中聚合信息。

本文致力于解决上述限制,我们将树形结构展平,按照推文发表的时间顺序来将所有推文组织成序列结构。本文基于transformer架构提出post-level attention model (PLAN),能够允许所有推文之间的两两交互,进一步通过引入结构信息(structure aware)来改进模型(StA-PLAN),再进一步设计一种 structure aware hierarchical token post-level attention network (StA-HiTPLAN)来学习每篇推文的更复杂的表示。

二、方法

- 问题定义

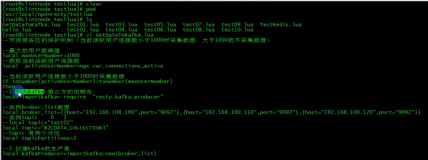

- Transformer架构

Transformer模型用来学习输入序列的长程依赖关系,应用这一特性,我们就可以利用transformer来学习展平的推文序列任意推文之间的两两交互关系。本小节简要介绍一下transformer的multi-head attention (MHA)层,构成transformer的每一层都包含一个self-attention子层和一个前馈子层,其中self-attention层是multi-head的,简要介绍self-attention层架构如下:

对transformer不熟悉的同学可以参考:

①Transformer:Attention Is All You Need

- Post-Level Attention Network (PLAN)

下图(a)展示了PLAN的架构:

架构

- Structure Aware Post-Level Attention Network (StA-PLAN)

PLAN因为展平树形结构使用序列作为输入而丢失了结构信息,StA-PLAN使用以下方式来引入结构信息:

- Structure Aware Hierarchical Token and Post-Level Attention Network (StA-HiTPLAN)

在获得推文的句子表示时采用的是max-pooling的方法,可以考虑采用更理想的方式来学习推文内token的重要性,于是我们提出了一个hierarchical attention model,也就是现在token-level进行attention来学习句子表示,然后再进行post-level attenion。StA-HiTPLAN的架构如上图(b)所示(上图中Tweet Level Self-Attention下面的两个方框画反了)。

- Time Delay Embedding

不同时间间隔创建的推文可能会有不同的作用。在源推文刚刚创建时,由于其是未经验证的,因此会有一些推文表达不信任,而在传播过程的后期,表达质疑的推文很可能表明源推文是假的。因此本文提出一种方法来编码时间延迟信息。

为了包含每条推文的时间延迟信息,我们根据创建源推文时的延迟对推文进行划分。总计bin数量为100,每个时间bin为10分钟间隔,推文延迟超过1000分钟的归入最后一个bin。利用transfomer原论文中类似的positional encoding来编码每个时间bin,得到的time delay embedding将与推文的句子embedding相加。每个推文的time delay embedding(TDE)为:

三、实验

- 数据集

本文实验在Twitter15和Twitter16以及PHEME数据集上进行,以下是两个数据集的统计情况:

数据集统计

- 实验

下面是在所有数据集上的实验效果:

Twitter15和Twitter16

PHEME

- 可解释性

- Post-Level Explanations

example

- Token-Level Explanation

可以使用token-level self-attention的自注意力权重来进行token-level的解释。比如评论“@inky mark @CP24 as part of a co-op criminal investigation one would URL doesn’t need facts to write stories it appears.”中短语“facts to write stories it appears”表达了对源推文的质疑,下图的自注意力权重图可以看出大量权重集中在这一部分,这说明这个短语就可以作为一个解释:

自注意力权重