一天,我在漫无目的地游走于数据的海洋中,突然有位科研小伙伴跑来问我:“为啥样本大小会影响统计检验结果的精确性呢?”哎呀,这不是小菜一碟嘛!但怎么回答才能展现出我的风采呢?我不就是那个总爱在数据世界里溜达的数据侠客吗!

让我来跟你聊聊,这个问题嘛,其实就是因为在我们勇敢的科研旅程中,对数据的精准打击比什么都重要,而样本大小,这玩意儿,它就像是我们科研武器库里的一把双刃剑。小样本,可能让你的统计检验像是在雾中摸索,误差大得吓人;大样本,则可能让你的统计结果稳如老狗,精准无比。

不信?来来来,我用代码给你瞧瞧:

# 安装和加载R包 # install.packages("dplyr") library(dplyr)

在我们的研究里,我们用随机分布的方法为数据加入一些随机“噪声”,让模拟数据更加贴近真实情况。

对于血糖水平(我们称之为HealthData),我们模拟了糖尿病患者和非糖尿病患者的血糖数据,并引入随机噪声以模拟实际测量中可能遇到的不确定性。这样,我们就能更好地研究血糖水平和糖尿病状态之间的关系。

接着,我们有心率恢复时间的数据(简称ExerciseData)。通过模拟,我们得到了在不同运动强度后的心率恢复时间,用来研究运动如何影响心脏健康。

最后,我们还有血压数据(我们叫它MedicalSurvey),使用对数正态分布来生成,以便更准确地反映出血压在自然界的分布。这些数据帮助我们探索血压与多种健康状况之间的联系。

# 随便弄点数据,让模拟跟现实对上号 set.seed(42) # 让结果稳如老狗,每次都一样 # 使用不同分布生成数据 # 生成 HealthData blood_sugar_uniform <- runif(1000, min = 70, max = 200) # 使用均匀分布 blood_sugar_exponential <- rexp(1000, rate = 0.01) + 70 # 使用指数分布,调整以满足范围 group <- c(rep("diabetic", 1000), rep("non-diabetic", 1000)) blood_sugar <- c(blood_sugar_uniform, blood_sugar_exponential) + rnorm(2000, sd = 5) # 添加噪声 HealthData <- data.frame(blood_sugar, group) # 生成 ExerciseData recovery_time <- runif(3000, min = 30, max = 90) # 使用均匀分布来模拟恢复时间 intensity_levels <- c("low", "medium", "high") intensity <- sample(intensity_levels, 3000, replace = TRUE, prob = c(0.3, 0.4, 0.3)) # 分配不同的强度等级 ExerciseData <- data.frame(recovery_time, intensity) # 生成 MedicalSurvey blood_pressure <- rlnorm(3000, meanlog = log(120), sdlog = 0.2) # 使用对数正态分布 MedicalSurvey <- data.frame(blood_pressure)

血糖数据分析

接下来,我们要潜入数据的海洋,一探究竟:不同样本大小会如何影响糖尿病和非糖尿病患者之间血糖的差距。

Step 1:问题设定和数据准备

在这一步,我们定义了我们想要探索的样本大小范围,并准备了两个空数组用于存储后续分析的结果。这些结果包括t检验的统计量和对应的p值。

# 设置不同的样本大小范围(可以理解为空瓶子) sample_sizes <- seq(20, 400, by = 20) t_values_blood_sugar <- numeric(length(sample_sizes)) p_values_blood_sugar <- numeric(length(sample_sizes))

Step 2:数据抽样和分析

在这个步骤里,我们按照计划处理了每一个预设的样本大小:首先,我们从HealthData数据集里选取了对应数量的糖尿病患者和非糖尿病患者的血糖水平样本。接着,对这两批样本进行了独立样本t检验,以判断它们之间的血糖水平是否存在明显差异。这个过程一直重复,直到我们覆盖了所有预定的样本大小。

# 循环计算血糖数据 for (i in 1:seq_along(sample_sizes)) { n <- sample_sizes[i] # 分别对糖尿病患者和非糖尿病患者的血糖水平进行抽样 sample_diabetic <- HealthData %>% filter(group == 'diabetic') %>% sample_n(n, replace = TRUE) sample_non_diabetic <- HealthData %>% filter(group == 'non-diabetic') %>% sample_n(n, replace = TRUE) # 执行独立样本t检验 t_test <- t.test(sample_diabetic$blood_sugar, sample_non_diabetic$blood_sugar) t_values_blood_sugar[i] <- t_test$statistic p_values_blood_sugar[i] <- t_test$p.value }

Step 3:结果总结和可视化

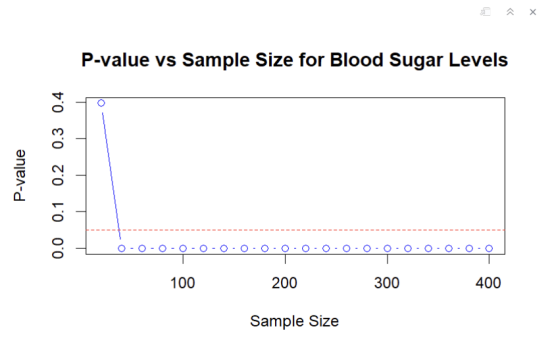

数据抽样与分析环节结束后,我们制作了一张图来展现各种样本大小对应的p值如何变化。这张图至关重要,因为它帮助我们揭示了样本大小对检验结果显著性的影响。图中的一条水平线标出了0.05的常规显著性水平,任何p值落在这条线以下,都意味着结果在统计学上是显著的。

# 绘制血糖数据分析结果 plot(sample_sizes, p_values_blood_sugar, type = "b", col = "blue", xlab = "Sample Size", ylab = "P-value", main = "P-value vs Sample Size for Blood Sugar Levels") abline(h = 0.05, col = "red", lty = 2)

结论:

随着样本大小的扩大,我们注意到p值趋向于跌破0.05的界限,暗示着在更大的样本中,糖尿病和非糖尿病个体之间的血糖差异更加明显,进而指向了统计上的显著性。这似乎在告诉我们,随着样本量的增加,我们的研究能力在悄悄地提升。

然而,有趣的是,在样本量增加到一定程度后,p值居然稳定在0,这强烈暗示着在大型样本中,这两组人的血糖水平差异不仅明显,而且非常显著。

但这里有个小插曲需要注意——显著性水平的考量。当样本足够庞大时,哪怕是微小的效应也可能被放大,成为统计上的显著。这就像是用放大镜观察,连一粒沙子都能看得清清楚楚。因此,在分析统计显著性时,我们需要同时考虑效应的大小和样本的大小。

血压数据分析

Step 1:问题设定和数据准备

在此环节,我们着手研究样本大小如何对血压测量的标准误差产生影响。在这里提一下:标准误差(SEM)代表了统计结果的精确性。它描述了样本均值分布的标准偏差,反映了样本均值作为总体均值估计的可靠程度。简而言之,SEM越小,表示我们从样本中估计出的均值越接近总体的真实均值,即统计结果越精确。

开始前,我们先确定了一系列样本大小,范围从20到400,每次增加20。同时,我们也准备了两组空数组--means和sems,它们将被用来记录不同样本大小下的血压测量平均值和相应的标准误差。

# 定义不同的样本大小范围 sample_sizes <- seq(20, 400, by = 20) # 准备存储结果的数组(和之前一样的空瓶子) means <- numeric(length(sample_sizes)) sems <- numeric(length(sample_sizes))

Step 2:数据抽样和分析

在此步骤中,我们将操作一个名为MedicalSurvey的数据集,该数据集收录了血压的测量值。面对每一个预先设定的样本大小,我们将执行以下抽样与分析步骤:起始步骤是从MedicalSurvey数据集里随机选取特定数量的血压数据;随后,计算这批数据的平均值及其标准误差。这样做使我们能够观察并理解样本大小对血压测量准确性及可靠性的具体影响。

# 循环计算每个样本大小下的均值和标准误差 for (i in 1:length(sample_sizes)) { sample_indices <- sample(1:nrow(MedicalSurvey), sample_sizes[i], replace = TRUE) # 放回抽样 sample_data <- MedicalSurvey[sample_indices, ] means[i] <- mean(sample_data) sems[i] <- sd(sample_data) / sqrt(sample_sizes[i]) }

Step 3:结果总结和可视化

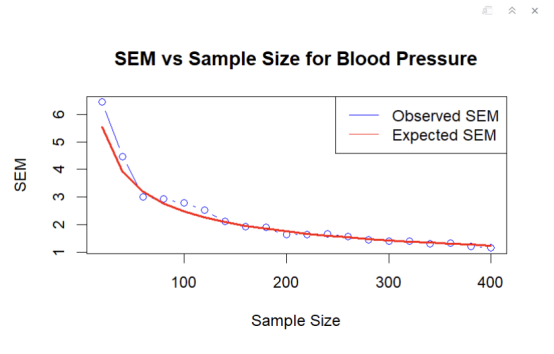

在完成了数据的抽样和分析之后,我们计算了整个MedicalSurvey数据集的标准差,并利用这一标准差以及各个样本的大小来计算预期的标准误差(SEM)。接下来,我们通过一个图表展示了随着样本大小的增加,观测到的SEM与预期SEM是如何变化的。

# 整个数据集的标准差 total_sd <- sd(MedicalSurvey$blood_pressure) # 根据整个数据集的标准差计算预期的SEM expected_sems <- total_sd / sqrt(sample_sizes) # 绘制结果 plot(sample_sizes, sems, type = "b", col = "blue", xlab = "Sample Size", ylab = "SEM", main = "SEM vs Sample Size for Blood Pressure") lines(sample_sizes, expected_sems, type = "l", col = "red", lwd = 2) legend("topright", legend = c("Observed SEM", "Expected SEM"), col = c("blue", "red"), lty = 1:1)

结论:

通过图表,我们注意到一个有趣的现象:样本量一旦上升,观察到的标准误差(SEM)就开始走低,好像是在告诉我们,随着样本数量的增加,对血压平均值的估计变得越来越接近精确无比。而且,当观察到的SEM开始和预期的SEM握手言和,简直就是在向我们证明,增加样本大小确实能让统计估计更加精准如射箭。

心率恢复时间数据分析

Step 1:问题设定和数据准备

在本步骤中,我们准备分析心率恢复时间如何随运动强度的不同而变化。为了探究这一问题,我们将通过不同的样本大小来分析数据,以观察样本大小如何影响ANOVA测试结果的稳定性和显著性。首先,我们定义了样本大小的范围,并初始化了两个空数组用于存储ANOVA测试的F值和p值。

f_values_recovery_time <- numeric(length(sample_sizes)) p_values_recovery_time <- numeric(length(sample_sizes))

Step 2:数据抽样和分析

在此步骤中,我们对每一个预定的样本大小,从ExerciseData数据集中抽样,这包含了不同强度下的心率恢复时间数据。对于每个样本,我们执行了ANOVA分析,来评估运动强度(低、中、高)对心率恢复时间的影响是否显著。我们记录了每个样本大小下的F值和p值,这些值将用于后续的分析和可视化。

# 循环计算心率恢复时间数据 for (i in 1:length(sample_sizes)) { n <- sample_sizes[i] # 对心率恢复时间进行抽样 sample <- ExerciseData %>% sample_n(n, replace = TRUE) # 执行ANOVA分析 aov_test <- aov(recovery_time ~ intensity, data = sample) f_values_recovery_time[i] <- summary(aov_test)[[1]]$F[1] p_values_recovery_time[i] <- summary(aov_test)[[1]]$`Pr(>F)`[1] }

Step 3:结果总结和可视化

# 绘制心率恢复时间数据分析结果 plot(sample_sizes, p_values_recovery_time, type = "b", col = "green", xlab = "Sample Size", ylab = "P-value", main = "P-value vs Sample Size for Recovery Time")

结论:

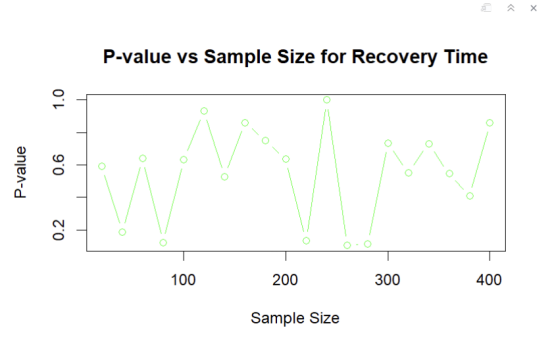

从这张图里我们可以看出,p值随着样本容量增大并没有趋近于降低而是比较动荡。这是因为与血糖不同,我们在模拟心率恢复时间数据时没有为两个组别创造实际差异,那么任何观察到的显著性可能都是由随机波动导致的。

关于样本大小与统计功效的这段探索,再次强调了一个道理:增加样本大小的确可以提高研究的灵敏度,让我们更有可能探测到实际存在的差异。不过,也别忘了,大样本也可能带来“过度检验”的陷阱,有时候,一些微不足道甚至没有实际意义的差异,也可能在统计测试中显得“惊人”。

最后的最后,要说的就是,合适的样本大小是科研路上的一盏明灯。只有选对了样本大小,我们才能在这条充满未知和挑战的科研道路上,走得更远,看得更清。而我,就是那个愿意在任何时候为你点亮这盏灯的数据侠客!

这就是样本大小的神奇之处,也是我今天要给你的小科普。别小看了这些看似简单的分析,背后的逻辑和技巧,可是深不可测。怎么样,我们一起在数据的世界里,继续冒险吧!