文章回顾

理论

实践

本地MAC环境配置

CPU数和内存大小

- 查看CPU数

sysctl machdep.cpu # 核数为4 machdep.cpu.core_count: 4 # cpu数量为8个,使用了超线程技术:四核八线程 machdep.cpu.thread_count: 8

- 内存大小

top -l 1 | head -n 10 | grep PhysMem PhysMem: 16G used (10G wired), 67M unused.

在本地开了3个虚拟机centos服务器

虚拟机服务器配置

服务器1 192.168.84.128 4核4G 服务器2 192.168.84.131 1核2G 服务器3 192.168.84.132 1核2G 因为服务器1上的按照的软件比较多 所以这样分配核数和内存 可以将大数据环境运行起来

虚拟机软件给一个虚拟机分配核数和内存的方式

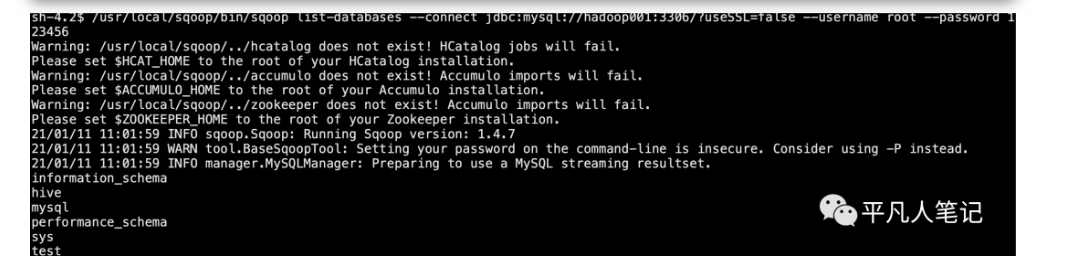

通过Sqoop查看Mysql数据库

/usr/local/sqoop/bin/sqoop list-databases --connect jdbc:mysql://hadoop001:3306/?useSSL=false --username

在Hive中创建测试表

创建test表

CREATE TABLE IF NOT EXISTS test ( id int ,uid int ,title string ,name string ,status int ,time timestamp) COMMENT '简介' ROW FORMAT DELIMITED FIELDS TERMINATED BY "\001" LINES TERMINATED BY "\n" STORED AS TEXTFILE;

创建test_out表

CREATE TABLE IF NOT EXISTS test_out ( name string , count int ,time date) COMMENT '简介' ROW FORMAT DELIMITED FIELDS TERMINATED BY '\001' LINES TERMINATED BY '\n' STORED AS TEXTFILE;

hive删除表

- 使用truncate仅可删除内部表数据,不可删除表结构

truncate table 表名 (truncate可删除所有的行,但是不能删除外部表)

- 使用shell命令删除外部表

hdfs -dfs -rm -r 外部表路径

- 使用 drop 可删除整个表

drop table 表名

查看hive表

- 查询hive所有表

hive -e "show databases ;" > databases.txt cat databases.txt default

- 指定default数据库

./hive -d default

在Mysql中创建测试表

- 创建test

DROP TABLE IF EXISTS `test`; CREATE TABLE `test` ( `id` int(10) DEFAULT NULL, `uid` int(10) DEFAULT NULL, `title` varchar(100) DEFAULT NULL, `name` varchar(100) DEFAULT NULL, `status` int(10) DEFAULT NULL, `time` timestamp NULL DEFAULT NULL ) ENGINE=InnoDB DEFAULT CHARSET=utf8;

插入3条测试数据

INSERT INTO `test`.`test`(`id`, `uid`, `title`, `name`, `status`, `time`) VALUES (1, 1, '第一条数据', '平凡人笔记', 1, '2021-01-11 16:30:02'); INSERT INTO `test`.`test`(`id`, `uid`, `title`, `name`, `status`, `time`) VALUES (2, 2, '第二条数据', '孟凡霄', 2, '2021-01-11 16:30:20'); INSERT INTO `test`.`test`(`id`, `uid`, `title`, `name`, `status`, `time`) VALUES (3, 3, '第三条数据', '平凡人', 3, '2021-01-11 16:30:41');

- 创建test_out

DROP TABLE IF EXISTS `test_out`; CREATE TABLE `test_out` ( `name` varchar(100) DEFAULT NULL, `count` int(10) DEFAULT NULL, `time` date DEFAULT NULL ) ENGINE=InnoDB DEFAULT CHARSET=utf8;