背景介绍

DataDog是一个用于云上应用的监控和分析平台,可以自动采集和分析日志、指标和链路追踪等数据,还可以用于基础设施和云服务的事件监控,对于服务器、应用程序以及采集到的各种数据提供了很好的可观测效果。但是DadaDog对于告警通知的管理功能比较缺乏,例如不支持短信、语音等通知渠道,也不支持用户组和值班组管理,还不具备动态发送告警通知的功能,因此不能覆盖用户的部分使用场景。SLS的告警功能很好地弥补了DataDog的这些不足之处,通过SLS提供的开放告警功能,用户也可以将DataDog的告警消息接入到SLS进行统一管理。本文将介绍如何快速创建DataDog的告警并将其告警消息接入到SLS中。

快速创建DataDog告警

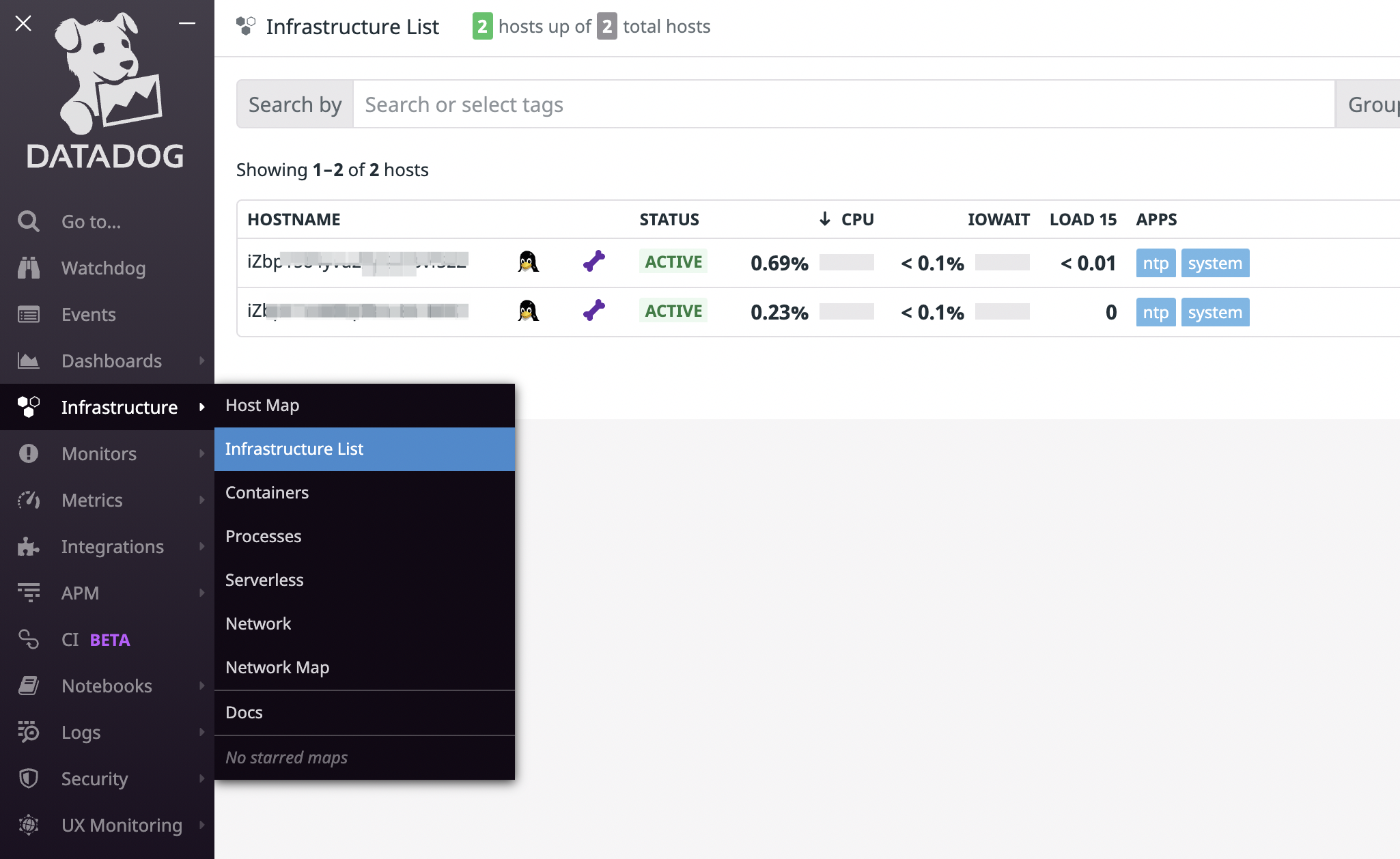

在创建告警之前,首先需要为DataDog添加数据来源,常见的两种添加数据来源的方式是通过Agent上报数据以及通过Integrations集成数据。Agent常用于上报基础设施(例如主机、集群和IoT设备)的日志和指标等数据,Integrations常用于集成云上服务或者其他数据平台(例如AWS CloudTrail和Splunk)的数据。本文的示例采用的数据来源为在主机上安装Agent。如下图所示为在两台服务器上安装成功了Agent后,在DataDog的基础设施列表里查看到的结果,安装方法参考Agent Usage。

添加了数据来源以后,就可以利用这些数据创建一个告警,用来监控你的设施或者服务。DataDog使用Monitor来管理告警,一条告警规则对应一个Monitor。点击Monitors->New Monitor,然后选择监视器类型就可以创建一个告警。如下图所示为检查主机是否向DataDog发送报告的监视器的配置界面,选择想要想要监控的主机,配置对应的参数,最后选择好通知渠道,对应的通知渠道就可以在DataDog检查不到主机发送的报告的时候收到告警消息了。

接入SLS开放告警

SLS的告警中心提供了开放告警的功能,可以将第三方的告警消息接入进来,目前已经支持了很多常见的告警监控平台,未来开放告警将提供让用户自己开发然后将告警消息接入SLS的能力。在SLS的开放告警中接入DataDog的告警数据分为以下几个步骤。

告警基础配置

告警基础主要是配置用户管理和通知管理,用户管理决定了您想指定谁接收到告警的消息,通知管理决定了消息通知的行为。通知管理主要包括内容模板和行动策略。内容模板决定了用户最终最终收到的告警内容,该功能近期会发布一个新版本,新版本支持用户在内容模板中使用处理函数、加入条件控制等强大的功能。行动策略可以参考创建行动策略,行动策略决定了在什么情况下,发送什么样的内容到您指定的通知渠道,用户可以在行动策略中决定在某种条件下进行对应的通知行动,如下图所示。

获取开放告警应用接口

在告警中心选择开放告警,创建一个开放告警服务。选择创建好的开放告警服务,添加一个开放告警应用,配置界面中的协议需要选择DataDog,行动策略选择上一步骤中配置好策略即可,其他的选项可以选择默认的配置。最后在创建的开放告警应用操作栏中点击接口,获取接口信息。需要注意的是获取的接口地址中,{ACCESS_KEY_ID}需要替换成用户自己的访问ID,具体内容可以参考配置开放告警对外接口。

DataDog配置

DataDog的配置主要是配置Webhook集成,并将其设置为对应的监视器的通知渠道,具体包括以下步骤:

- 在导航栏中,选 Integrations。

- 在Integrations页签中,找到webhooks,单击Install,安装完成后,单击Configure。

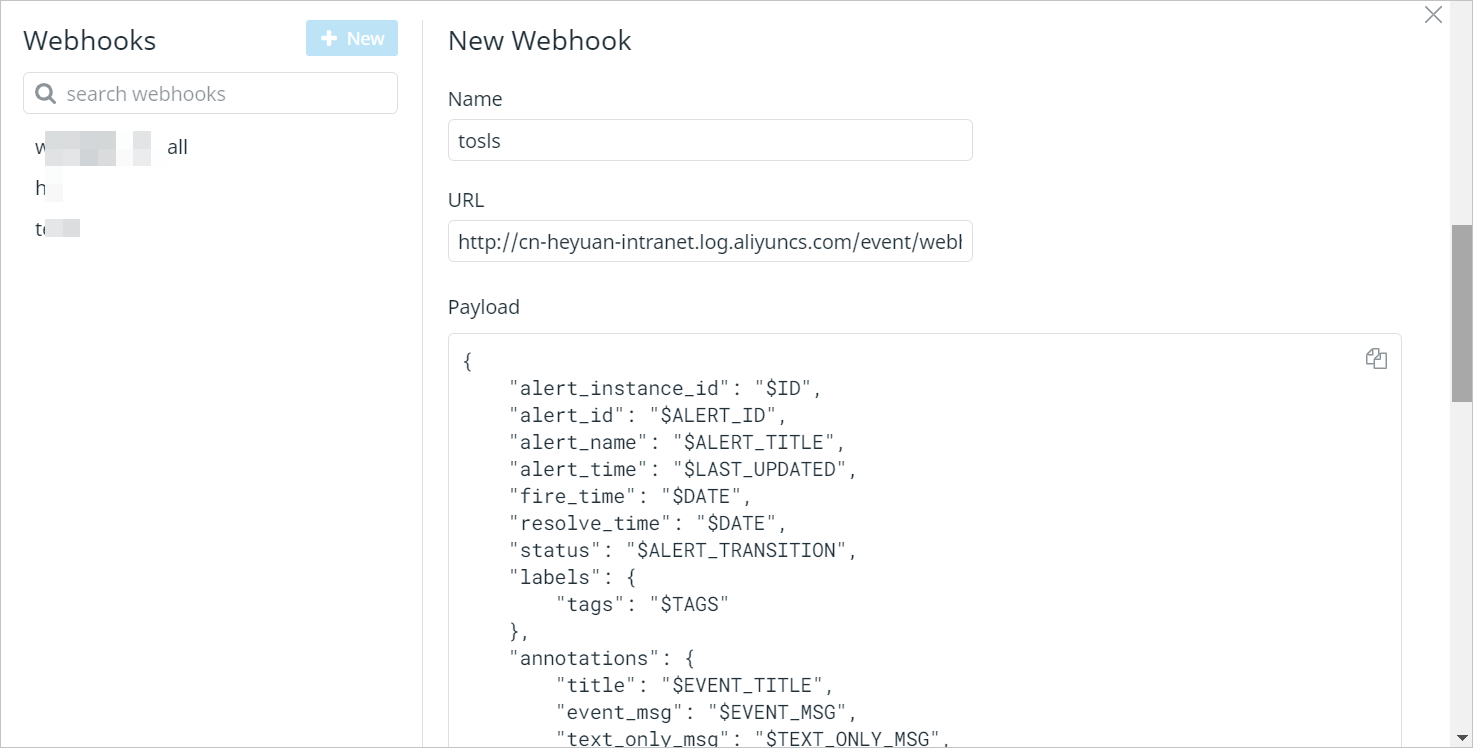

- 在Webhooks区域,单击New,在New Webhook区域,配置如下参数,然后单击Save。

其中Name为webhook的名称,URL为告警消息的接收端,此处配置为上一步骤获取的开放接口信息(完整URL),Payload为用户自定义告警消息的内容,DataDog提供了几十种告警消息变量,用户可以在Payload进行使用,具体可以参考DataDog官方文档,在配置Payload时,用户需要按照SLS的要求进行,具体可以参考接入DataDog告警。

- 编辑目标Monitor,在配置通知渠道的步骤中,选择上一步配置的Webhook,最后进行保存。

告警数据映射

用户按照SLS的要求配置好了DataDog的告警消息后,SLS将收到如下示例消息

{

"alert_instance_id": "123456",

"alert_id": "123456",

"alert_name": "STOP on host:abcdefgh",

"alert_time": "1628647425",

"fire_time": "1628647425",

"resolve_time": "1627561306",

"status": "Triggered",

"labels": {

"tags": "ali,host:abcdefgh,monitor"

},

"annotations": {

"title": "[P1] [Triggered on {host:abcdefgh}] STOP",

"event_msg": "%%%\nwarning\nhost stop\n @webhook-webhook-test-all\n\nThe monitor was last triggered at Thu Jul 29 2021 12:21:45 UTC.\n\n- - -\n\n[[Monitor Status](https://app.datadoghq.com/monitors/1234?to_ts=1234&group=host%3Aabcdefgh&from_ts=1627560405000)] \u00b7 [[Edit Monitor](https://app.datadoghq.com/monitors#1234/edit)] \u00b7 [[View abcdefgh](https://app.datadoghq.com/infrastructure?filter=abcdefgh)] \u00b7 [[Show Processes](https://app.datadoghq.com/process?sort=memory%2CASC&to_ts=1234&tags=host%abcdefgh&from_ts=1627560405000&live=false&showSummaryGraphs=true)]\n%%%",

"text_only_msg": "\nwarning\nhost stop\n @webhook-webhook-test-all\n\nMetric Graph: https://app.datadoghq.com/monitors/1234?to_ts=1627561365000&group=host%abcdefgh&from_ts=1627557705000 \u00b7 Monitor Status: https://app.datadoghq.com/monitors/1234?group=host%abcdefgh \u00b7 Edit Monitor: https://app.datadoghq.com/monitors#42655965/edit \u00b7 Event URL: https://app.datadoghq.com/event/event?id=1234 \u00b7 View abcdefgh: https://app.datadoghq.com/infrastructure?filter=abcdefgh \u00b7 Show Processes: https://app.datadoghq.com/process?sort=memory%2CASC&to_ts=None&tags=host%abcdefgh&from_ts=None&live=false&showSummaryGraphs=true",

"alert_metric": "null",

"alert_query": "\"datadog.agent.up\".over(\"host:abcdefgh\").by(\"host\").last(2).count_by_status()",

"alert_scope": "host:abcdefgh",

"alert_status": "",

"alert_type": "error",

"email": "",

"event_type": "service_check",

"hostname": "abcdefgh",

"logs_sample": "null",

"metric_namespace": "",

"priority": "normal",

"user": "null",

"username": "",

"__aggreg_key__": "a1b2c3",

"__alert_cycle_key__": "123456789",

"__incident_attachments__": "null",

"__incident_commander__": "null",

"__incident_customer_impact__": "null",

"__incident_fildes__": "null",

"__incident_public_id__": "null",

"__incident_title": "null",

"__incident_url__": "null",

"__org_id__": "123",

"__org_name__": "ali",

"__security_rule_name__": "null",

"__security_signal_id__": "null",

"__security_signal_severity__": "null",

"__security_signal_title__": "null",

"__security_signal_msg__": "null",

"__security_signal_attributes__": "null",

"__security_rule_id__": "null",

"__security_rule_query__": "$SECURITY_RULE_QUERY",

"__security_rule_group_by_fields__": "null",

"__security_rule_type__": "null",

"__link_snapshot_url__": "null",

"__synthetics_test_name__": "null",

"__synthetics_first_failing_step_name__": "null"

},

"severity": "P1",

"drill_down_query": "https://app.datadoghq.com/event/event?id=123456"

}

上述消息与SLS的标准告警消息基本一致,SLS只需要去掉其中的空字段和无效字段,然后加入DataDog告警消息不具备的一些字段,最后在labels和annotations字段中再加入一些信息,就可以将该消息转为SLS的标准告警消息。

总结

将DataDog的告警消息接入SLS后,极大地拓展了告警消息的后续处理,不止丰富了通知管理部分的功能,还对后续告警数据的应用提供了平台,从而更全面地保证了系统服务的稳定性。