分享人:DataWorks技术支持团队

我们在开发者社区学习路线里有发布一个DataWorks的学习路线,里面包含了入门讲解和熟能生巧系列的直播内容,大家可以去学习一下,需要主账号登陆学习哦:https://developer.aliyun.com/learning/course/81

本期视频地址:https://developer.aliyun.com/learning/course/81/detail/1242

数据集成的整库迁移、批量上云和分库分表功能,能够批量生成同步任务。

假设数据库内有100张表,原本可能需要配置100次数据同步任务,但通过整库迁移或批量上云可以一次性完成配置。

添加数据源

配置上面三种任务之前,要先添加数据源。

数据集成页面数据源菜单里有数据源配置页面的入口,点进去后可以配置数据源。

我们到数据源管理界面,这里可以选择添加单个的数据源,也可以批量添加数据源。我们选择添加单个的数据源,选择MySQL,再选择阿里云实例模式。

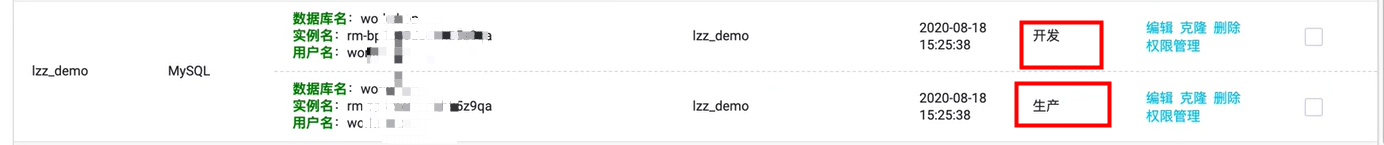

补充完信息之后,进行连通性测试,测试通过之后在配置整库迁移和批量上云的时候就能选择到相应的数据源。建议开发环境和生产环境都要添加数据源,否则看不到整库迁移的路口。

整库迁移

整库迁移的列表里我们点击对应数据源的整库迁移入口,一般在开发环境。示例以MySQL数据源同步到MaxCompute为例。

然后可以选择目标MaxCompute数据源以及同步任务的独享数据集成资源组进行数据同步。

批量上云

点击左侧批量上云菜单可以进入批量上云页,点击右上角“新建批量快速上云”来配置一个批量上云任务。

首先我们选择来源侧和目标端的数据源以及任务运行的资源组:

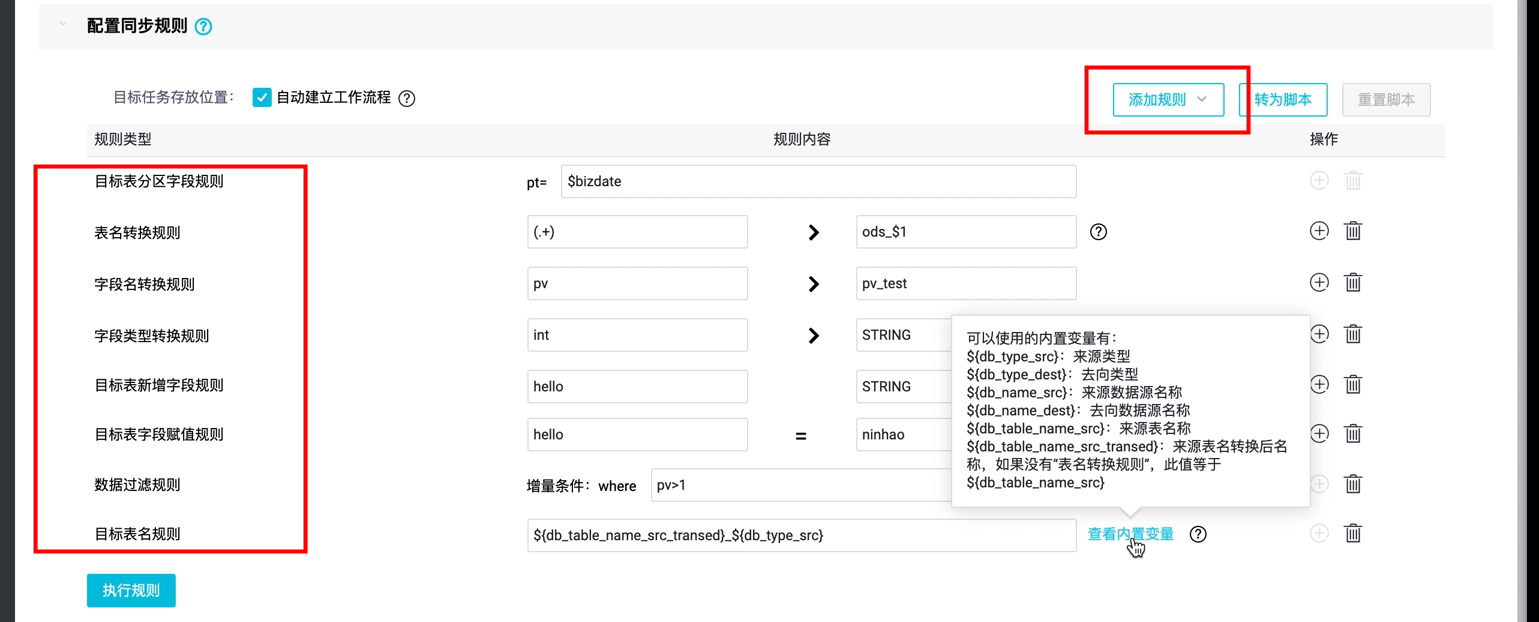

然后我们可以配置同步任务的一些转换规则。

其中表名转换规则和目标表名规则会影响目标端的表名,图片内配置效果如下:

目标表分区字段规则:按bizdate日期分区

表名转换规则:正则匹配,给目标表添加ods_$1前缀

字段名转换规则:pv字段改成pv_test

字段类型转换规则:int改成string

目标表新增字段规则:新增一个hello字段,string类型

目标表字段赋值规则:给hello字段赋值“ninhao”

数据过滤规则:pv要大于1

目标表明规则:目标表名为 来源表名+下划线+来源表类型(比如MySQL)

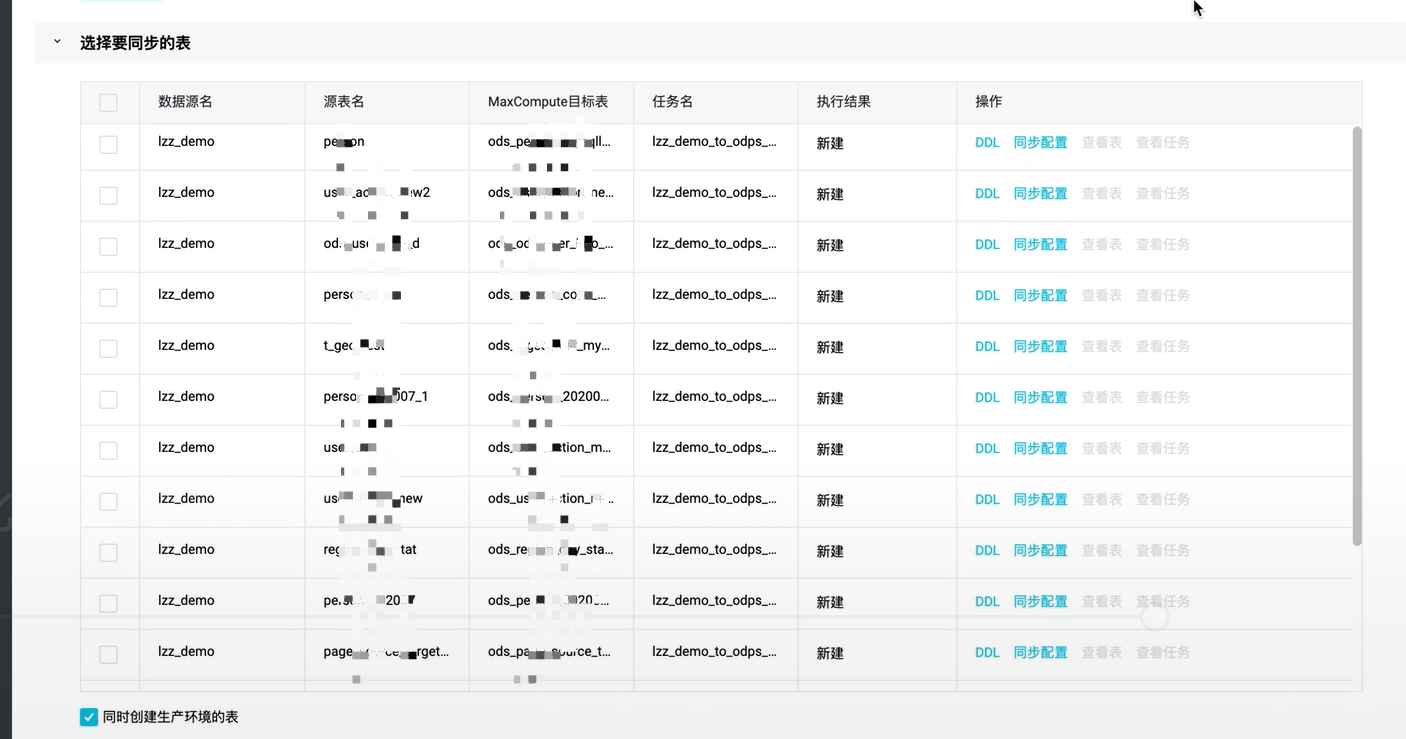

配置完规则后我们选择需要同步的表:

然后提交任务即可

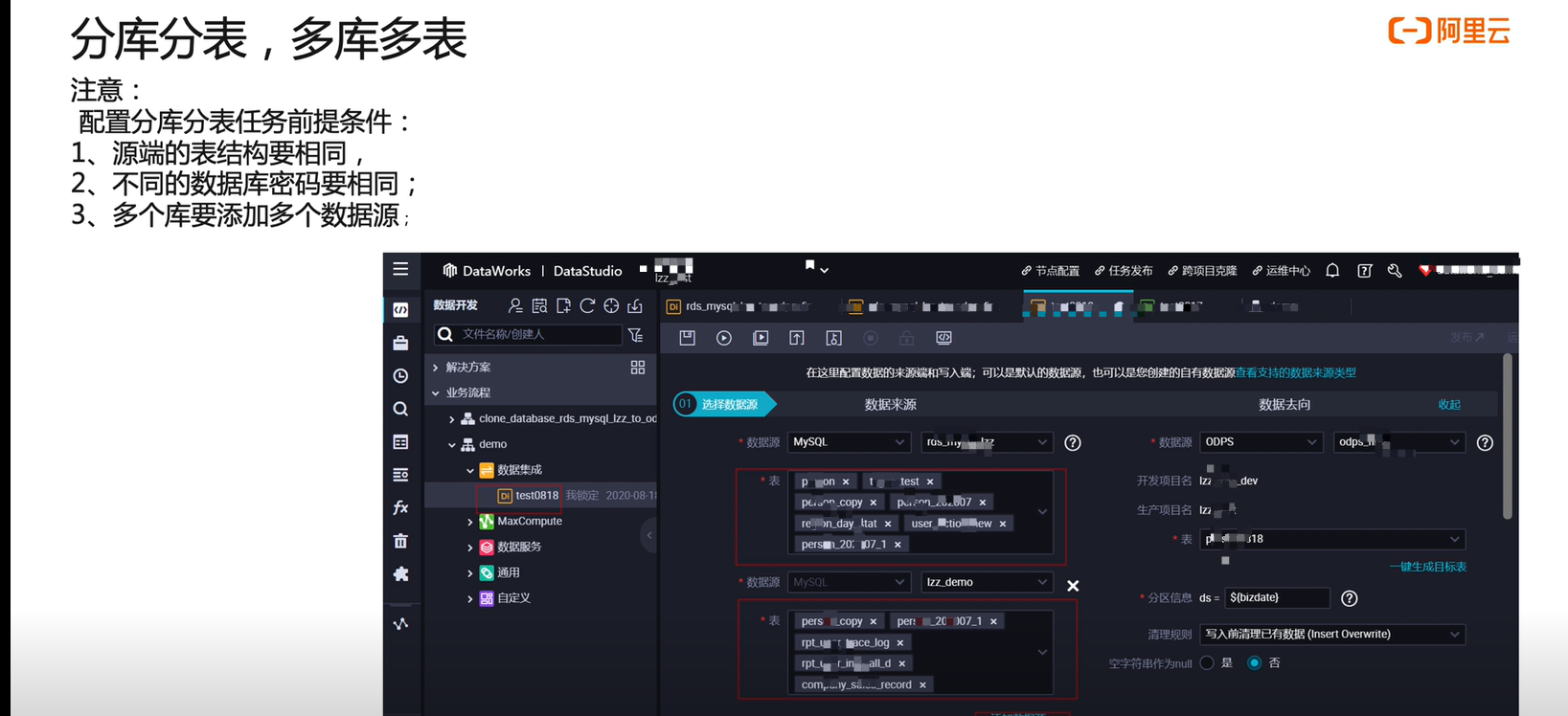

分库分表

分库分表需要需要满足一些条件:

以上就是本次“数据集成批量生成同步任务”讲解的全部内容,有问题需要解答的同学可以扫码加一下我们的钉钉大群,群里有直播回放可以观看,技术支持的同学们也会回答大家的问题。

感谢大家的关注!