客服系统一开始,几乎一定是“模型驱动”的

如果你回看绝大多数客服系统的第一版架构,都会发现一个非常一致的特征:

模型在最中心。

用户进来,模型理解;

模型判断,模型回答;

模型错了,再调模型。

这在项目早期是完全合理的,甚至是唯一可行的方式。

- 规则不全

- 场景不清楚

- 数据也不够

这时候不靠模型,系统根本跑不起来。

但问题在于:

几乎所有最终能长期稳定运行的客服系统,都会离开这个状态。

而这条从「模型驱动」走向「策略驱动」的路,

不是架构升级,

而是一种责任认知的变化。

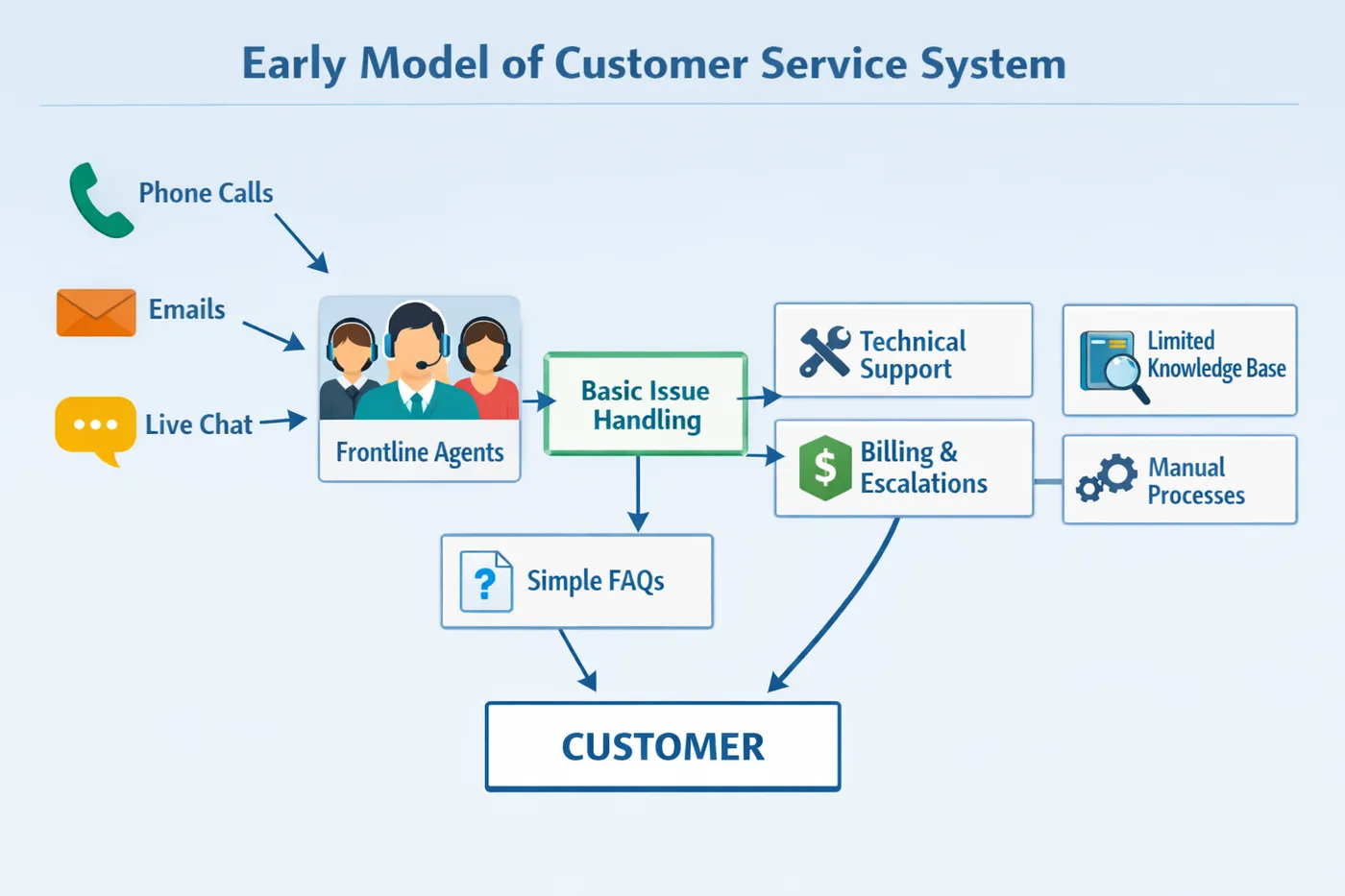

客服系统早期模型中心结构示意图

一个先给出的结论

在正式展开之前,我先把这篇文章的核心判断写出来:

客服系统的进化方向,从来不是“模型能力最大化”,

而是“模型决策权最小化”。

你后面看到的所有“策略层”“规则引擎”“人工兜底”,

本质上都在做同一件事:

把“是否承担后果”的权力,从模型手里拿回来。

第一阶段:模型驱动是必经之路,但只能是起点

在项目最初阶段,模型驱动几乎是不可避免的。

你需要它来做几件事:

- 把自然语言问题变成结构化理解

- 覆盖大量未知问题

- 快速验证“这个系统有没有用”

这一阶段的典型结构是:

用户 → 模型 → 回复

优点非常明显:

- 快

- 灵活

- 看起来很“智能”

但它也天然带着一个定时炸弹:

模型既在“理解”,又在“决策”,还在“承担结果”。

而这三件事,本来就不该由同一个组件完成。

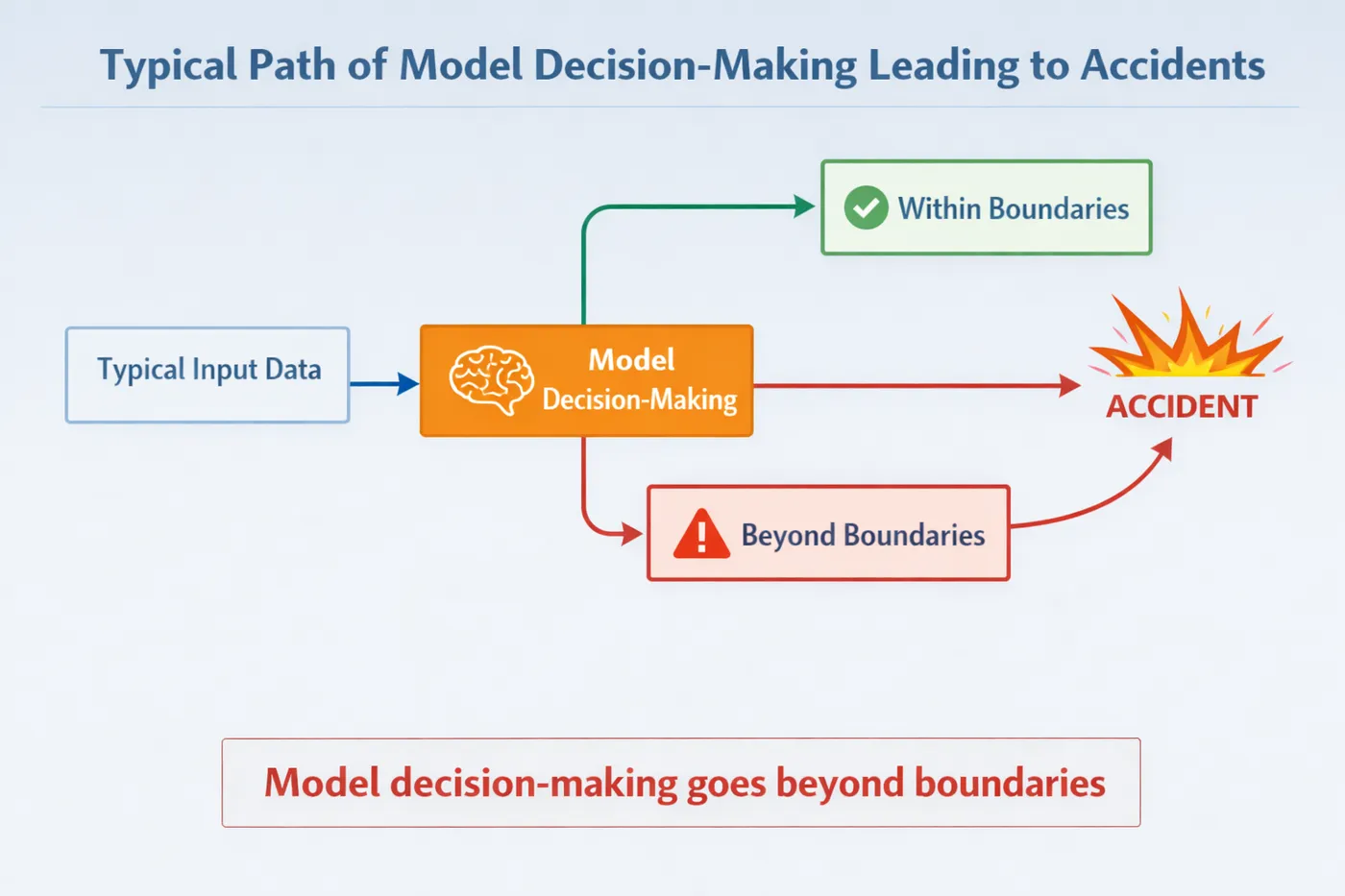

第二阶段:第一次事故,几乎一定来自“不该由模型决定的事”

模型驱动的客服系统,第一次出问题,往往不是因为模型完全答错了事实。

而是因为它:

- 给了不该给的承诺

- 在模糊条件下下了确定结论

- 在规则冲突时选择了“看起来最顺”的解释

比如:

- 退款条件没满足,但模型给了肯定答复

- 用户描述不完整,模型却直接判断结果

- 本该转人工的问题,被模型“好心”处理了

这类问题有一个共同点:

不是“模型不懂语言”,

而是“模型不该拥有这个判断权”。

模型决策越界导致事故的典型路径图

第三阶段:错误的第一反应——继续强化模型

几乎所有团队,在第一次事故之后,都会做同一件事:

再调一版模型。

- 补点数据

- 微调参数

- 加点拒答样本

- 强化安全指令

这些动作短期内往往确实有效:

- 某些问题不再出现

- 模型变得“更谨慎”

- 指标看起来变好了

但与此同时,一个更隐蔽的问题正在发生:

系统正在把“责任修复”这件事,继续往模型身上压。

这意味着:

- 模型越来越复杂

- 行为越来越难解释

- 风险不消失,只是被推迟

第四阶段:真正的转折点——开始质疑“这件事该不该交给模型”

所有最终走向策略驱动的客服系统,都会经历一个关键认知转折。

在这个转折点上,团队开始问一些不那么“技术”的问题:

- 如果这次判断错了,后果谁承担?

- 我们真的能接受模型在这里“自由发挥”吗?

- 这类问题,本来是不是就该走人工?

当这些问题开始出现,说明一件事:

团队已经意识到:

问题不在模型能力,而在决策结构。

第五阶段:策略层出现,模型开始被“限制”

这是很多工程师心理上最难接受的一步。

系统开始引入:

- 风险分类

- 明确的拒答条件

- 强制转人工策略

- 固定话术

- 规则优先级

模型第一次被明确告知:

有些问题,你不能答。

从表面看,这像是在“削弱模型”。

但在工程上,这一步意义非常重大:

系统终于开始主动承担风险。

模型不再是最后一道防线,

而只是系统中的一个能力模块。

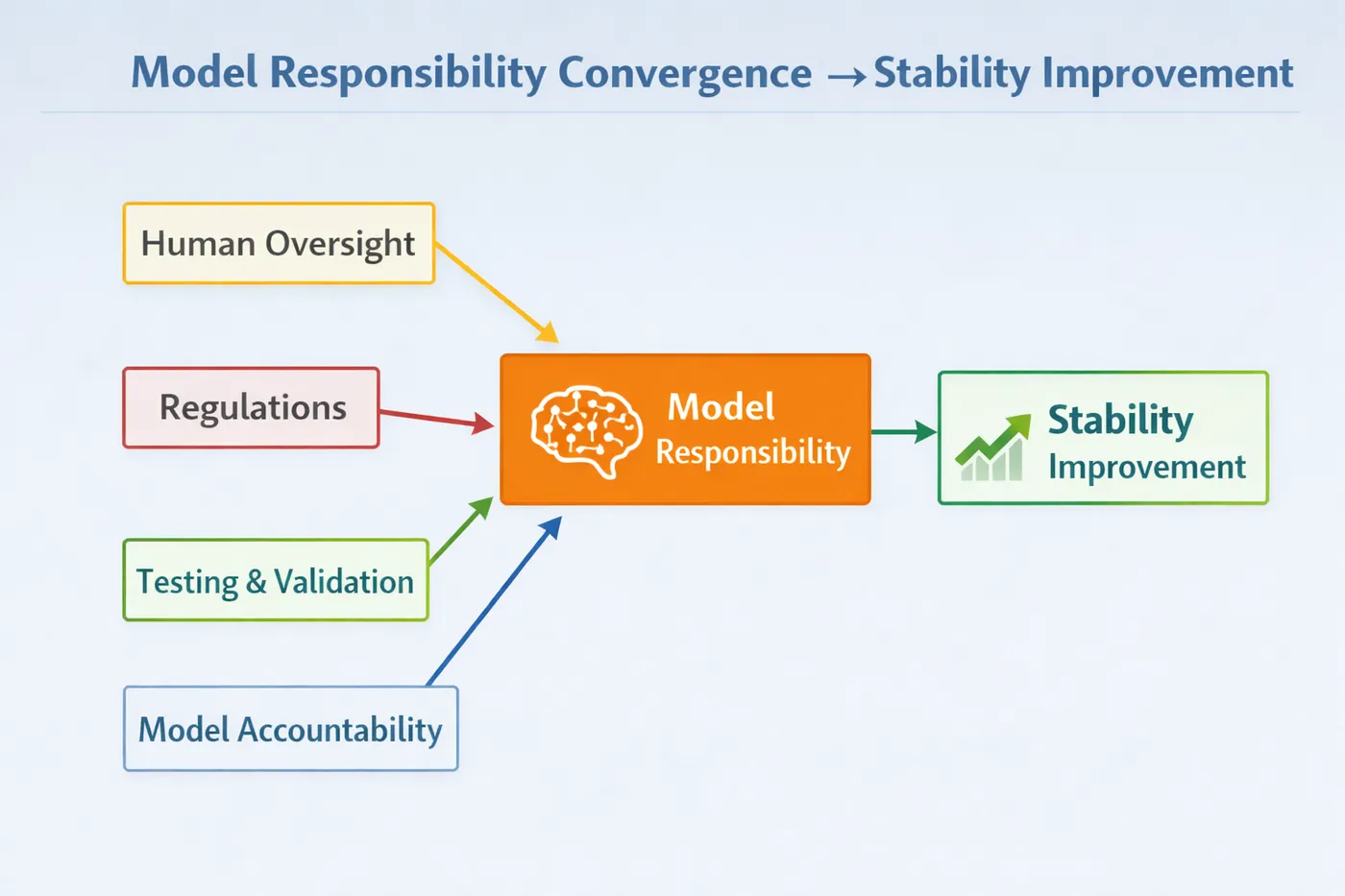

第六阶段:模型被“收权”之后,反而更好用了

这是一个很多人直到亲身经历才会相信的事实。

当模型不再负责:

- 是否合规

- 是否给承诺

- 是否兜底

它开始只负责:

- 解释

- 引导

- 安抚

- 语言组织

结果往往是:

- 输出更稳定

- 行为更可预期

- “奇怪回答”明显减少

不是模型变强了,

而是它终于不用再干不该干的活了。

模型职责收敛 → 稳定性提升 示意图

第七阶段:客服系统的评价标准发生根本变化

在模型驱动阶段,大家最爱看的指标是:

- 自动回复率

- 命中率

- 覆盖率

而在策略驱动阶段,真正重要的指标变成了:

- 越界率

- 投诉率

- 转人工是否及时

- 高风险场景是否被挡住

这标志着一个非常重要的转变:

客服系统的目标,从“尽量自动”,

变成了“可控自动”。

一个非常真实的演进路径总结

阶段一:模型负责一切 → 看起来很智能

阶段二:事故出现 → 再强化模型

阶段三:模型越来越复杂 → 系统越来越不安

阶段四:开始质疑模型决策权

阶段五:策略层收权 → 模型退居表达层

阶段六:系统稳定运行

注意:

这不是一次性设计完成的,而是被现实一点点逼出来的。

为什么“策略驱动”不是倒退,而是成熟

很多人一开始会抗拒策略驱动,因为它:

- 看起来没那么“智能”

- 自动化比例下降

- 需要承认模型能力的边界

但所有长期活着的客服系统,最后都会接受一个事实:

真正的智能,不是模型什么都敢做,

而是系统知道什么时候不该让模型做。

很多客服系统卡在“模型表现不错,但就是不敢放量”的阶段,问题往往不在模型本身,而在缺乏把模型能力与策略边界一起评估的视角。用LLaMA-Factory online把模型微调、行为评估和策略效果放在同一体系里对照,更容易判断:什么时候该继续优化模型,什么时候已经必须收回决策权。

总结:客服系统成熟的那一天,模型通常已经不在舞台中央

我用一句话,把这篇文章彻底收住:

客服系统的终点,从来不是“模型无所不能”,

而是“模型只做它该做的事”。

从模型驱动到策略驱动,

不是技术路线的摇摆,

而是工程责任的回归。

当你开始:

- 主动限制模型

- 明确拒答边界

- 把后果交给系统

你会发现:

- 系统更稳了

- 团队更安心了

- 模型反而更好用了

这条路,几乎所有成熟客服系统,

都会走一遍。