强化学习是一种机器学习方法,用于训练智能体(agent)在与环境的交互中学习如何做出最优决策。Q-learning是强化学习中的一种基于价值函数的方法,用于学习最优策略。本文将详细介绍Q-learning的原理、实现方式以及如何在Python中应用。

什么是Q-learning?

Q-learning是一种基于值函数的强化学习方法,用于学习在不同状态下采取不同行动的价值。它通过迭代地更新Q-value(行动-状态值函数),使得智能体可以根据当前状态选择最优的行动,并逐步优化策略以获得最大的累积奖励。

Q-learning的原理

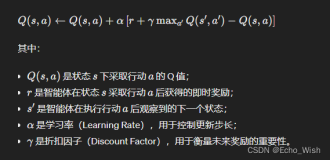

Q-learning的核心思想是通过不断地更新Q-value来逼近最优价值函数。其更新公式如下:

使用Python实现Q-learning

接下来,我们将使用Python来实现一个简单的Q-learning算法,并应用于一个简单的环境中。

首先,我们需要导入必要的库:

import numpy as np

然后,我们定义一个简单的迷宫环境,表示为一个二维数组,其中 0 表示可通行的空格,1 表示障碍物,2 表示目标位置:

# 定义迷宫环境

maze = np.array([

[0, 0, 0, 1],

[0, 1, 0, 1],

[0, 0, 0, 2]

])

接下来,我们定义Q-table,用于存储每个状态下的Q-value,并初始化为0:

# 初始化Q-table

Q_table = np.zeros((maze.shape[0], maze.shape[1], 4))

然后,我们定义Q-learning算法:

# 定义Q-learning算法

def q_learning(maze, Q_table, alpha=0.1, gamma=0.9, episodes=100):

for episode in range(episodes):

state = (0, 0) # 初始状态

while maze[state] != 2: # 直到到达目标位置

# 选择行动

action = np.argmax(Q_table[state])

# 获取奖励

reward = -1 if maze[state] == 0 else -10

# 更新Q-value

next_state = get_next_state(state, action)

Q_table[state][action] += alpha * (reward + gamma * np.max(Q_table[next_state]) - Q_table[state][action])

# 更新状态

state = next_state

return Q_table

# 获取下一个状态

def get_next_state(state, action):

next_state = list(state)

if action == 0: # 上

next_state[0] -= 1

elif action == 1: # 下

next_state[0] += 1

elif action == 2: # 左

next_state[1] -= 1

elif action == 3: # 右

next_state[1] += 1

return tuple(next_state)

最后,我们可以使用Q-learning算法来训练智能体,并获得学习后的Q-table:

Q_table = q_learning(maze, Q_table)

print("学习后的Q-table:", Q_table)

结论

Q-learning是一种经典的强化学习方法,通过迭代地更新Q-value来学习最优策略。在实际应用中,我们可以根据具体问题选择合适的参数和算法,并利用Q-learning来训练智能体在复杂环境中做出最优决策。

通过本文的介绍,相信读者已经对Q-learning这一强化学习方法有了更深入的理解,并且能够在Python中使用代码实现和应用Q-learning算法。祝大家学习进步!