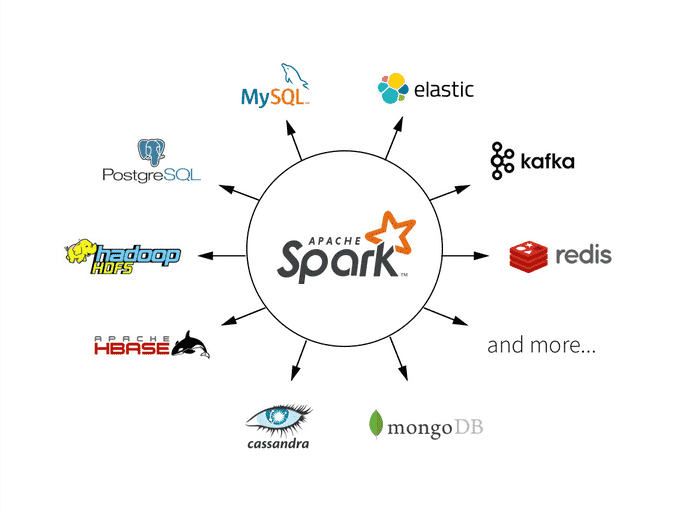

Apache Spark是一个强大的分布式计算框架,Spark SQL是其一个核心模块,用于处理结构化数据。性能优化是大数据处理中的一个关键问题,本文将深入探讨Spark SQL中的两个性能优化技术:谓词下推(Predicate Pushdown)和列式存储(Columnar Storage),以提高查询性能和降低资源消耗。

谓词下推(Predicate Pushdown)

谓词下推是一种优化技术,它可以将过滤条件推送到数据源引擎,以减少数据传输和计算开销。在Spark SQL中,谓词下推是通过将过滤条件应用于数据源的数据文件,以减少需要加载到内存中的数据量来实现的。这可以显著提高查询性能,尤其是当处理大量数据时。

示例:谓词下推

假设有一个包含销售订单的表,其中包括订单号、销售日期和销售额。希望查询某个日期范围内的销售订单。

# 创建DataFrame

orders_df = spark.read.parquet("orders.parquet")

# 定义过滤条件

start_date = "2023-01-01"

end_date = "2023-12-31"

# 应用谓词下推

filtered_orders = orders_df.filter((orders_df["sale_date"] >= start_date) & (orders_df["sale_date"] <= end_date))

# 执行查询

filtered_orders.show()

在上面的示例中,谓词下推将过滤条件(orders_df["sale_date"] >= start_date) & (orders_df["sale_date"] <= end_date)应用于数据文件,只加载满足条件的数据,从而减少了不必要的数据传输和计算。

列式存储(Columnar Storage)

列式存储是一种数据存储格式,它将数据按列存储,而不是按行存储。这种存储方式具有许多优点,包括更高的压缩率、更快的查询性能和更少的I/O开销。在Spark SQL中,列式存储通常与Parquet格式一起使用,Parquet是一种列式存储的开放性文件格式。

示例:使用列式存储

假设有一个包含用户数据的表,其中包括用户ID、姓名、年龄和地址。将数据保存为Parquet格式,以利用列式存储的性能优势。

# 创建DataFrame

users_df = spark.createDataFrame([(1, "Alice", 30, "123 Main St"), (2, "Bob", 25, "456 Elm St")], ["id", "name", "age", "address"])

# 保存数据为Parquet格式

users_df.write.parquet("users.parquet")

在上面的示例中,创建了一个包含用户数据的DataFrame,并将其保存为Parquet格式。Parquet格式将数据按列存储,使得查询时只需要加载所需的列,而不需要加载整个行,从而提高了查询性能。

性能优化案例

看一些性能优化案例,演示如何在实际情况下使用谓词下推和列式存储来提高性能。

1 数据仓库查询

假设你是一个数据工程师,负责维护数据仓库,数据仓库包含了大量的数据表。用户经常进行复杂的查询,例如按日期范围、地理区域、产品类别等条件进行过滤和聚合。为了提高查询性能,可以使用谓词下推来减少数据传输,并将数据保存为列式存储的Parquet格式。

# 应用谓词下推,只加载满足条件的数据

filtered_data = spark.read.parquet("data.parquet").filter(condition)

# 执行查询操作

result = filtered_data.groupBy("date", "region", "category").agg(sum("sales_amount"))

2 数据分析任务

假设你是一个数据分析师,负责分析大量的日志数据。任务包括统计每个用户的活动时长、计算每个页面的访问量等。为了提高数据分析性能,可以将日志数据保存为列式存储的Parquet格式,并使用谓词下推来过滤不必要的数据。

# 应用谓词下推,只加载指定日期范围内的数据

filtered_logs = spark.read.parquet("logs.parquet").filter((col("date") >= start_date) & (col("date") <= end_date))

# 执行数据分析任务

user_activity = filtered_logs.groupBy("user_id").agg(sum("activity_duration"))

page_views = filtered_logs.groupBy("page_url").count()

性能优化和注意事项

在使用谓词下推和列式存储时,以下是一些性能优化和注意事项:

合理选择过滤条件:选择合适的过滤条件以减少数据传输和加载。

使用合适的列式存储格式:选择适合您数据类型和查询模式的列式存储格式,例如Parquet。

缓存中间结果:如果您多次使用相同的数据集,可以考虑将中间结果缓存到内存中以避免重复计算。

总结

谓词下推和列式存储是Spark SQL中的两个重要性能优化技术,它们可以显著提高查询性能和降低资源消耗。本文深入探讨了这两个技术的原理和实际应用,以及性能优化的案例和注意事项。

希望本文能够帮助大家更好地理解和应用谓词下推和列式存储,以提高Spark SQL查询性能,从而更有效地处理和分析大规模数据。