正文

时间序列表示

虽然Transformer 再预测方向上的效果并不好,但在创建有用的时间序列表示方面Transformer还是取得了许多进展。我认为这是时间序列深度学习领域中一个令人印象深刻的新领域,应该进行更深入的探索。

5.TS2Vec: Towards Universal Representation of Time Series (AAAI 2022)

https://arxiv.org/abs/2106.10466

TS2Vec是一个学习时间序列表示/嵌入的通用框架。这篇论文本身已经有些过时了,但它确实开始了时间序列表示学习论文的趋势。

对使用表示进行预测和异常检测进行评估,该模型优于许多模型,例如 Informer 和 Log Transformer。

6.Learning Latent Seasonal-Trend Representations for Time Series Forecasting(Neurips 2022)

https://openreview.net/forum?id=C9yUwd72yy

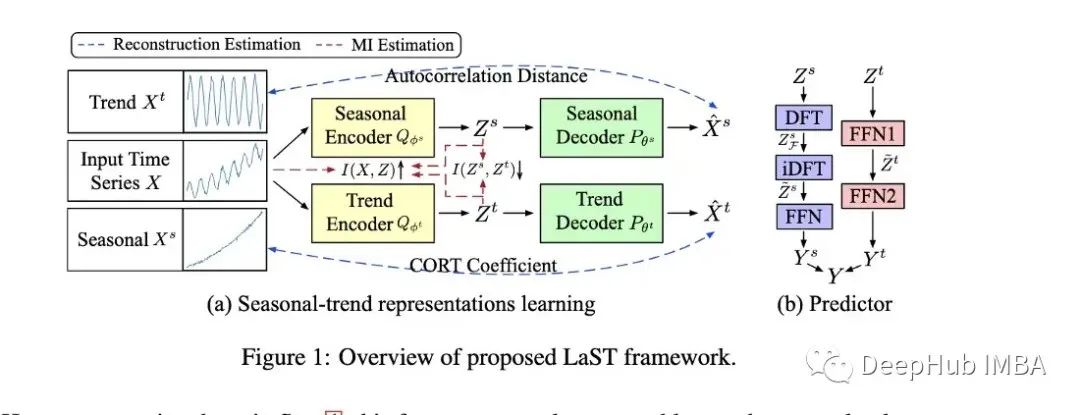

作者创建了一个模型(LAST),使用变分推理创建季节性和趋势的分离表示。

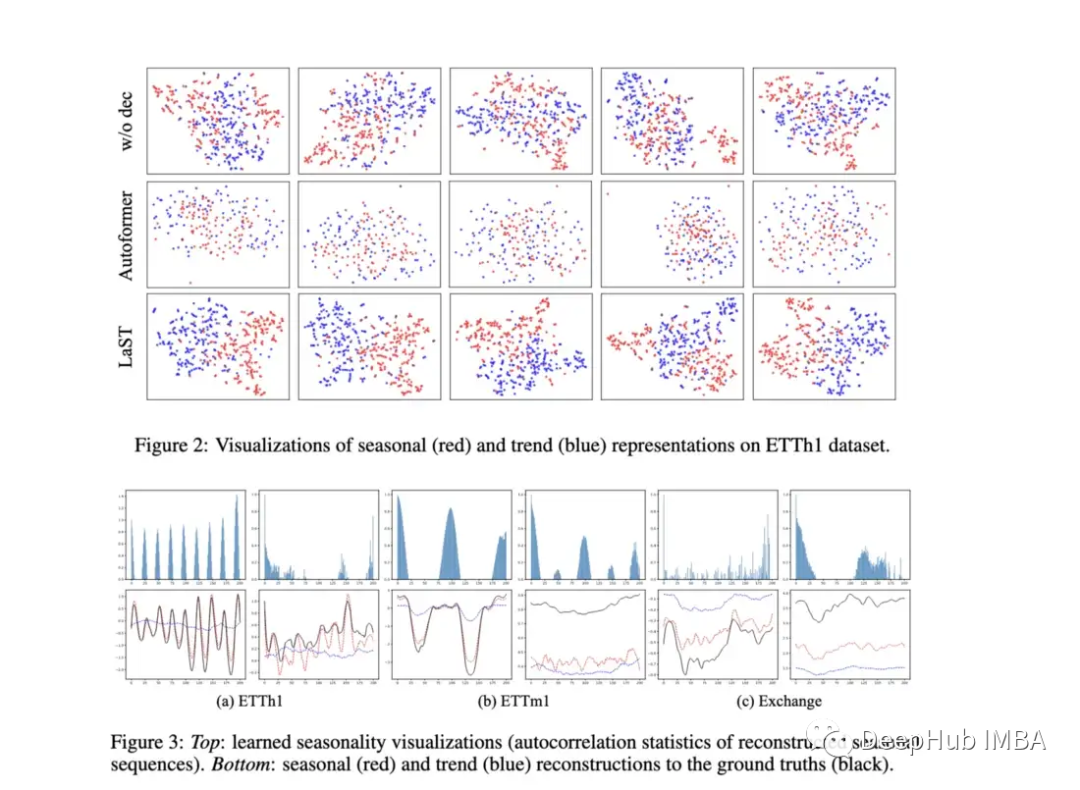

作者对他们的模型进行了下游预测任务的评价,他们通过在表示上添加一个预测器(见上图中的B)来做到这一点。它们还提供了有趣的图来显示表示的可视化。该模型在几个预测任务以及TS2Vec和成本方面都优于Autoformer。在一些预测任务上,它看起来也可能比上面提到的简单线性回归表现更好。

尽管我仍然对那些只评估标准预测任务的模型持怀疑态度,但这个模型的确很亮眼,因为它关注的是表征而不是预测任务本身。如果我们看一下论文中展示的一些图表,可以看到模型似乎确实学会了区分季节性和趋势。不同数据集的可视化表示也嵌入到相同的空间中,如果它们显示出实质性的差异,那将是很有趣的。

7.CoST: Contrastive Learning of Disentangled Seasonal-Trend Representations for Time Series Forecasting (ICLR 2022)

https://openreview.net/forum?id=PilZY3omXV2

这是2022年早些时候在ICLR上发表的一篇论文,在学习季节和趋势表示方面与LaST非常相似。由于LaST在很大程度上已经取代了它的性能,这里就不做过多的描述了。但链接在上面供那些想要阅读的人阅读。

其他有趣的论文

8.Domain Adaptation for Time Series Forecasting via Attention Sharing(ICML 2022)

https://arxiv.org/abs/2102.06828

当缺乏训练数据时,预测对 DNN 来说是一项挑战。这篇论文对具有丰富数据的领域使用共享注意力层,然后对目标领域使用单独的模块。

它所提出的模型使用合成数据集和真实数据集进行评估。在合成环境中,测试了冷启动学习和少样本学习,发现他们的模型优于普通 Transformer 和 DeepAR。对于真实数据集采用了 Kaggle 零售数据集,该模型在这些实验中大大优于基线。

冷启动、少样本和有限学习是极其重要的主题,但很少有论文涉及时间序列。该模型为解决其中一些问题提供了重要的一步。也就是说他们可以在更多不同的有限现实世界数据集上进行评估,并与更多基准模型进行比较, 微调或正则化的好处在于可以对任何架构进行调整。

9.When to Intervene: Learning Optimal Intervention Policies for Critical Events (Neurips 2022)

https://openreview.net/pdf?id=rP9xfRSF4F

虽然这不是一篇“典型的”时间序列论文,但我选择将其列入这个列表,因为本文的重点是在机器发生故障之前找到进行干预的最佳时间。这被称为OTI或最佳时间干预。

评估OTI的问题之一是潜在生存分析的准确性(如果不正确,评估也会不正确)。作者根据两个静态阈值评估了他们的模型,发现它表现得很好,并且绘制了不同政策的预期表现和命中与失败的比率。

这是一个有趣的问题,作者提出了一个新颖的解决方案,Openreview的一位评论者指出:“如果有一个图表显示失败概率和预期干预时间之间的权衡,那么实验可能会更有说服力,这样人们就可以直观地看到这个权衡曲线的形状。”

下面还有一些相关论文,如果你有兴趣可以看看。

10.FiLM: Frequency improved Legendre Memory Model for Long-term Time Series Forecasting (Neurips 2022)

https://openreview.net/forum?id=zTQdHSQUQWc

11.Adjusting for Autocorrelated Errors in Neural Networks for Time Series (Neurips 2021)

12.Dynamic Sparse Network for Time Series Classification: Learning What to “See” (Neurips 2022)

https://openreview.net/forum?id=ZxOO5jfqSYw

最近的数据集/基准

最后就是数据集的测试的基准

Monash Time Series Forecasting Archive (Neurips 2021):该存档旨在形成不同时间序列数据集的“主列表”,并提供更权威的基准。该存储库包含 20 多个不同的数据集,涵盖多个行业,包括健康、零售、拼车、人口统计等等。

Subseasonal Forecasting Microsoft (2021):这是 Microsoft 公开发布的数据集,旨在促进使用机器学习来改进次季节预测(例如未来两到六周)。次季节预报有助于政府机构更好地为天气事件和农民的决定做准备。微软为该任务包含了几个基准模型,与其他方法相比,一般来说深度学习模型的表现相当差。最好的 DL 模型是一个简单的前馈模型,而 Informer 的表现非常糟糕。

https://www.microsoft.com/en-us/research/project/subseasonal-climate-forecasting/

Revisiting Time Series Outlier Detection:本文评述了许多现有的异常/异常值检测数据集,并提出了35个新的合成数据集和4个真实世界数据集用于基准测试。

https://openreview.net/forum?id=r8IvOsnHchr

开源的时序预测框架FF

Flow Forecast是一个开源的时序预测框架,它包含了以下模型:

Vanilla LSTM (LSTM)、SimpleTransformer、Multi-Head Attention、Transformer with a linear decoder、DARNN、Transformer XL、Informer、DeepAR、DSANet 、SimpleLinearModel等等。

这是一个学习使用深度学习进行时间预测的很好的模型代码来源,有兴趣的可以看看。

https://github.com/AIStream-Peelout/flow-forecast

总结

在过去的两年里,我们已经看到了Transformer在时间序列预测中的兴起和可能的衰落和时间序列嵌入方法的兴起,以及异常检测和分类方面的额外突破。

但是对于深度学习的时间序列来说:可解释性、可视化和基准测试方法还是有所欠缺,因为模型在哪里执行,在哪里出现性能故障是非常重要的。此外,更多形式的正则化、预处理和迁移学习来提高性能可能会在未来中出现。

也许Transformer对时间序列预测有好处(也许不是),就像VIT那样如果没有Patch的出现Transformer可能还会被认为不行,我们也将继续关注Transformer在时间序列的发展或者替代。