2026年阿里云一件部署OpenClaw,OpenClaw怎么调用百炼模型,获取百炼API Key?参考:阿里云OpenClaw详细介绍及一键部署教程页;https://www.aliyun.com/activity/ecs/clawdbot

• 阿里云轻量应用服务器:https://www.aliyun.com/product/swas

• 阿里云百炼:https://www.aliyun.com/product/bailian

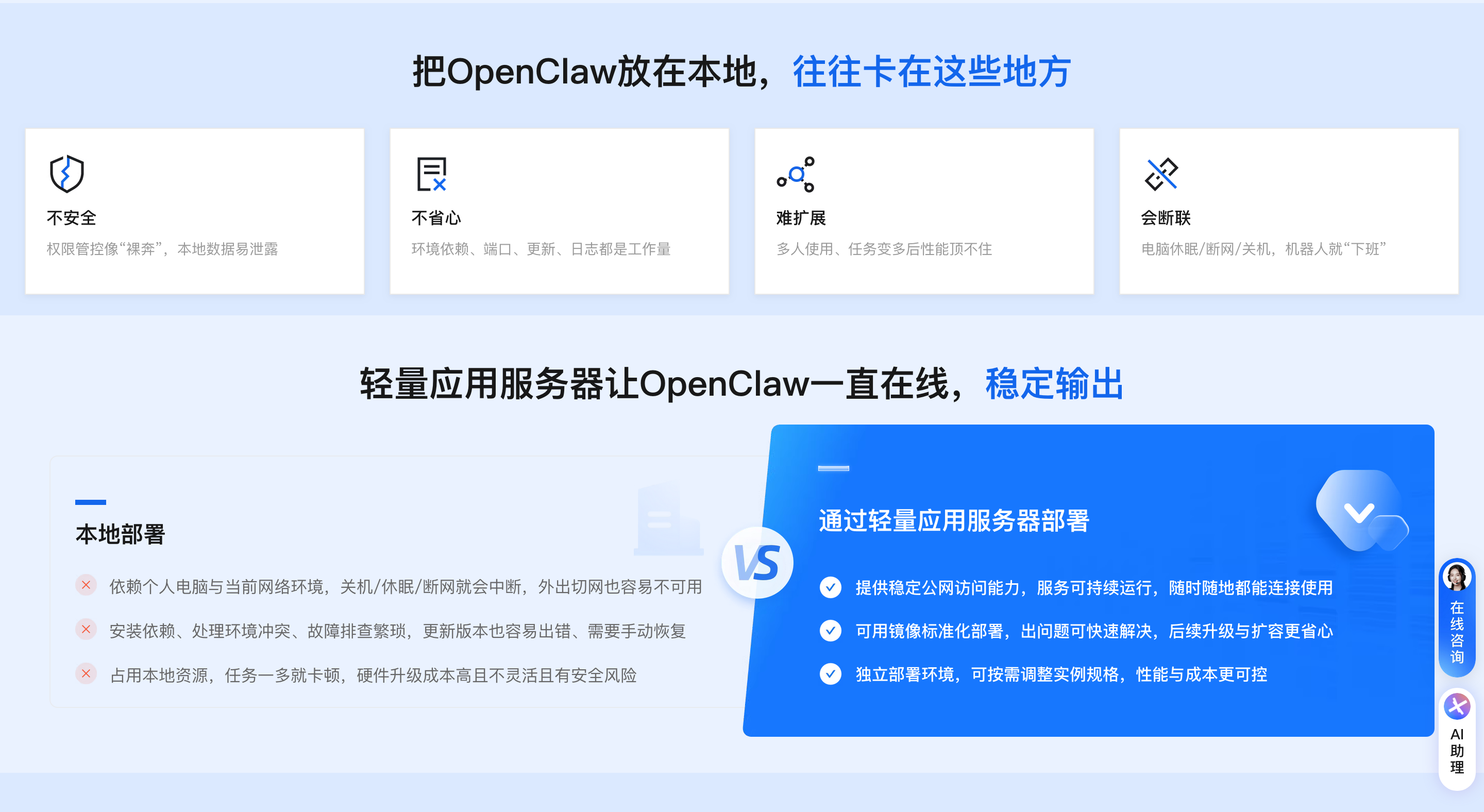

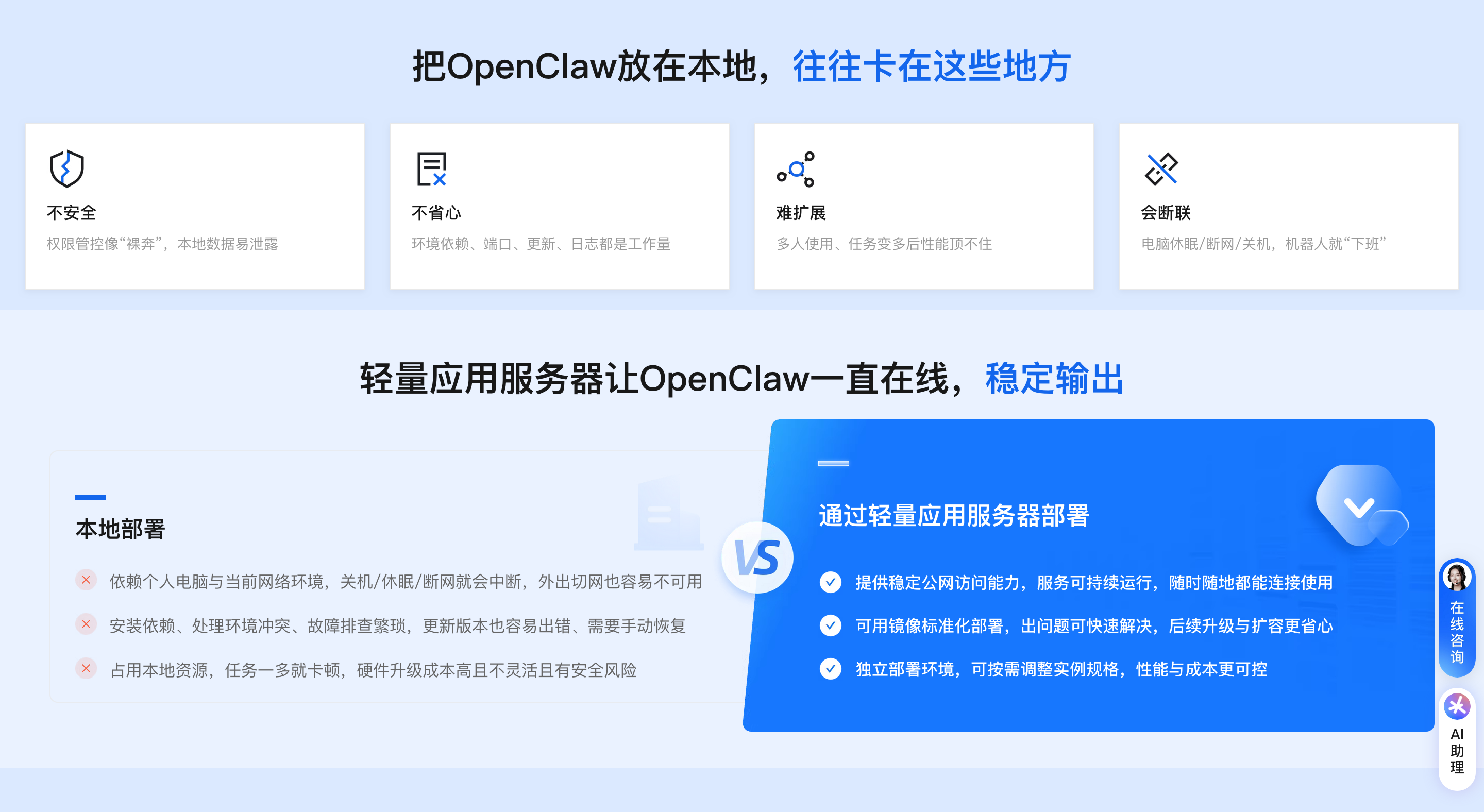

在OpenClaw中调用百炼模型,核心是获取百炼API Key、配置base_url与模型ID,通过WebUI或命令行完成基础配置与模型绑定,再测试验证即可,全程无需复杂开发。以下是2026年2月最新的完整流程(含新手可视化与命令行两种方式)。

阿里云OpenClaw(Clawdbot)快速部署步骤

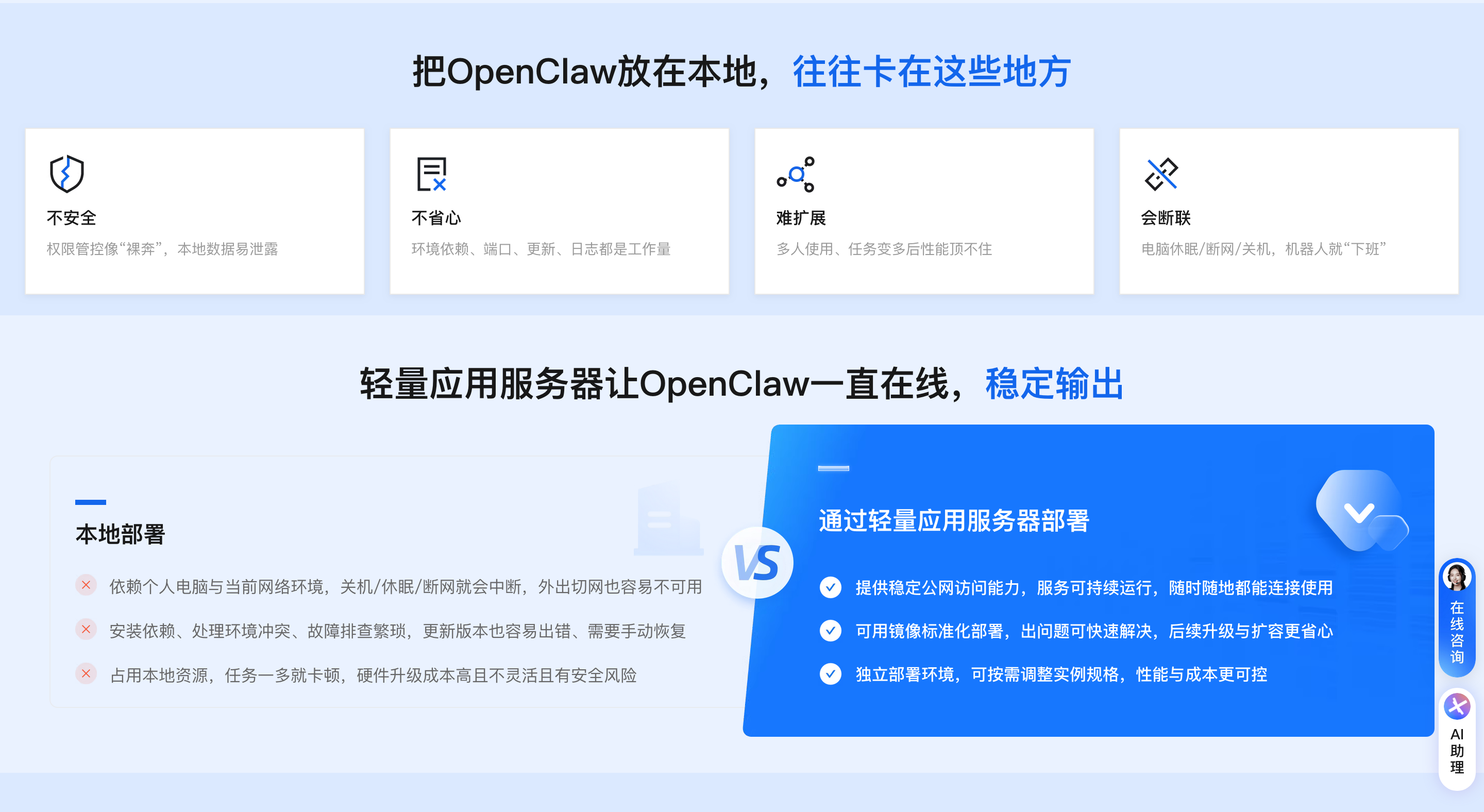

阿里云提供专属应用镜像与一键部署方案,无需复杂环境配置,30分钟即可完成,支持7×24小时稳定运行,具体步骤如下:

(一)部署前核心准备

- 账号与权限:注册阿里云账号 并完成实名认证(个人用户刷脸认证即时生效,企业用户需上传资质审核);若使用子账号操作,需由主账号分配“轻量应用服务器管理员”权限。

- 服务器配置:选购阿里云轻量应用服务器,内存需≥2GiB(低于该配置会导致服务启动失败),推荐操作系统为Alibaba Cloud Linux 3.2104 LTS 64位;地域优先选择中国香港或海外地域(国内除香港外地域联网搜索功能受限)。

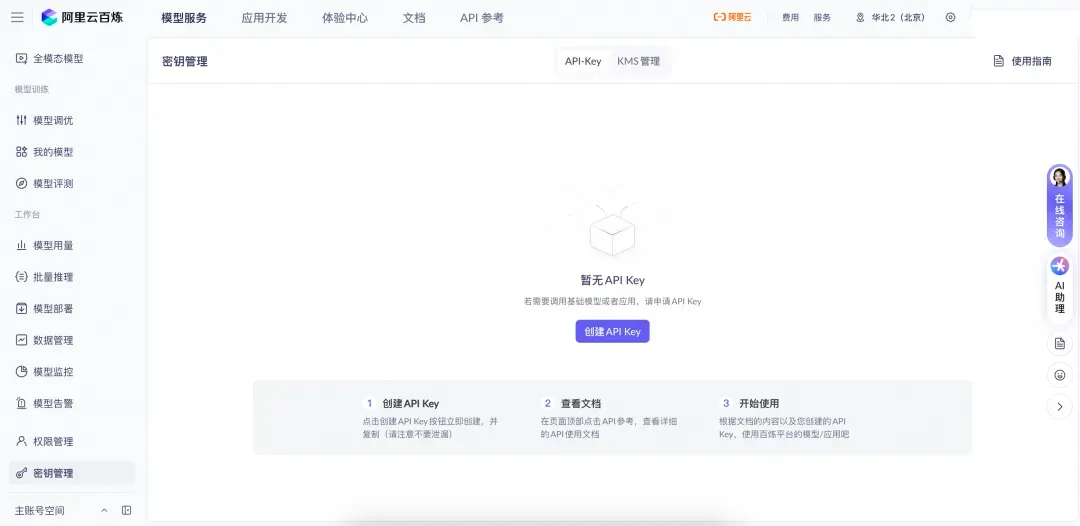

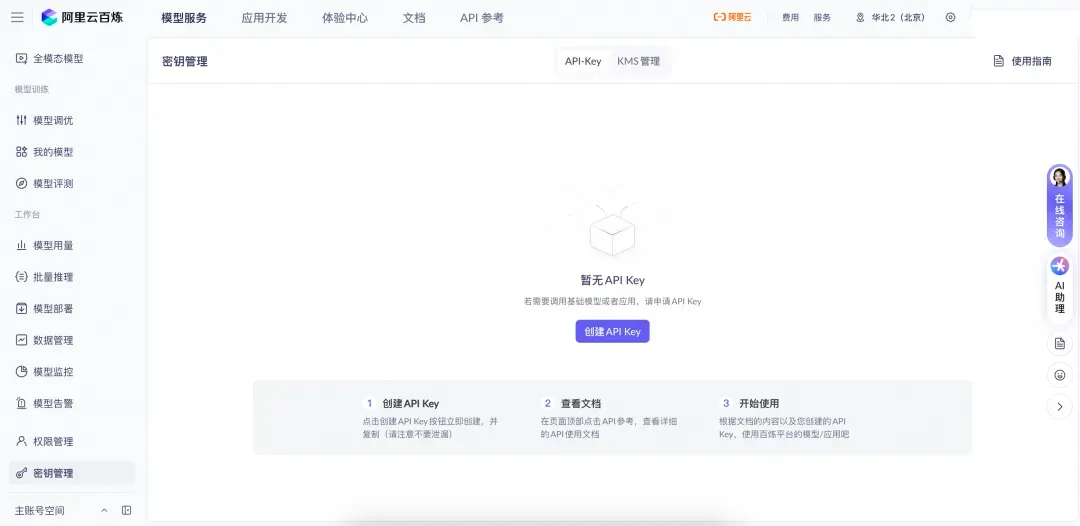

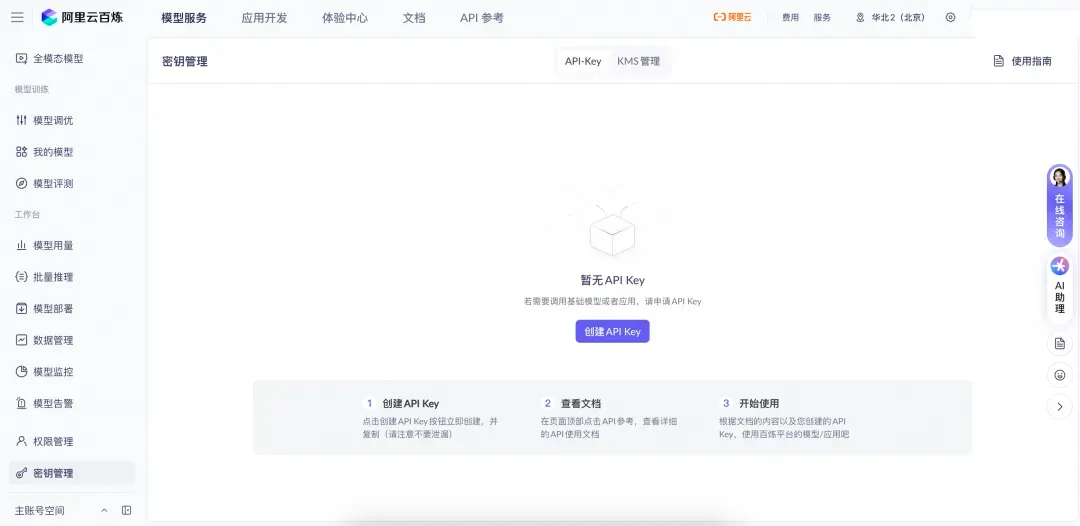

- 核心凭证:访问阿里云OpenClaw一键部署专题页面,进入“密钥管理”创建API-Key,获取Access Key ID与Access Key Secret并保存(严禁泄露给第三方)。

(二)一键部署操作

- 服务器创建或重置:

- 端口与API配置:

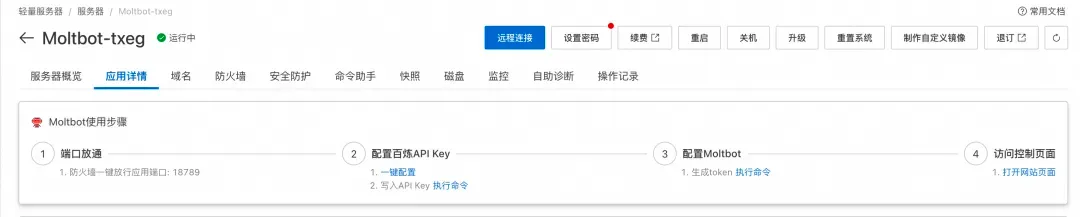

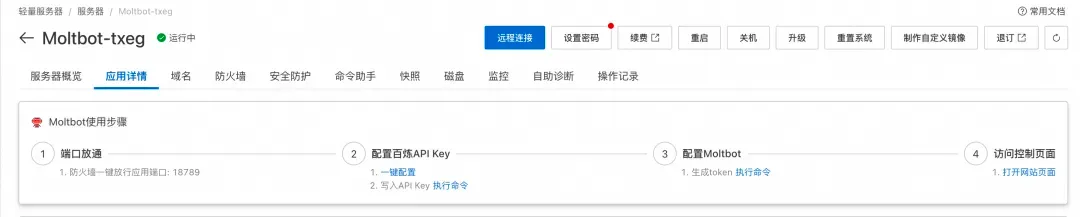

- 端口放行:OpenClaw默认使用18789端口,镜像已自动配置放行规则,可在服务器“应用详情”→“访问控制”中验证端口状态。

- API-Key配置:在“应用详情”→“配置OpenClaw”模块,点击“执行命令”,按提示粘贴百炼API-Key,系统自动完成配置并重启服务。

- 关键凭证获取:

ssh root@你的服务器公网IP

docker exec -it openclaw-2026 openclaw token generate

复制生成的Token,通过浏览器访问http://服务器公网IP:18789/chat,即可进入OpenClaw Web控制台,部署完成。

一、前置准备(3步)

- 开通百炼大模型并创建API Key:登录阿里云百炼控制台,完成实名认证,在“密钥管理”创建API Key并保存;若使用Coding Plan,需获取对应专属API Key。

- 确认地域与base_url匹配(关键,避免调用失败):

| 地域 | base_url |

| :--- | :--- |

| 华北2(北京) | https://dashscope.aliyuncs.com/compatible-mode/v1 |

| 新加坡 | https://dashscope-intl.aliyuncs.com/compatible-mode/v1 |

| 美国(弗吉尼亚) | https://dashscope-us.aliyuncs.com/compatible-mode/v1 | - 准备目标模型ID:百炼模型广场获取,如qwen3-max-2026-01-23(复杂推理)、qwen-plus(日常对话)、qwen3-coder-plus(代码场景)。

二、两种配置方式(新手/进阶)

方式1:WebUI可视化配置(小白优先,5分钟)

- 进入OpenClaw WebUI(公网IP:18789),登录后进入“系统设置→模型配置”。

- 新增百炼配置:选择“阿里云百炼”,填写配置名称、API Key、对应地域base_url,添加模型ID(如qwen3-max-2026-01-23),设置temperature(0.7)、max_tokens(2000)等高级参数。

- 测试连接:点击“测试”,提示“连接成功”后保存。

- 设置默认模型:“系统设置→全局配置”,将默认大模型设为刚配置的百炼模型,保存后重启网关(WebUI“服务管理”中操作)。

方式2:命令行配置(进阶用户,适合批量/自动化)

- 登录服务器(SSH),设置环境变量:

export DASHSCOPE_API_KEY="你的百炼API Key"

- 添加百炼模型配置:

openclaw models add --provider bailian --name qwen3-max --modelId qwen3-max-2026-01-23 --baseUrl "https://dashscope.aliyuncs.com/compatible-mode/v1"

- 设置默认模型并重启网关:

openclaw config set agents.default.model "bailian/qwen3-max"

openclaw gateway restart

- 验证配置:

openclaw models list

输出含“bailian/qwen3-max”即配置成功。

三、模型调用与验证

- 基础调用:WebUI对话窗口发送“生成一份活动策划案”,验证回复与模型能力匹配度。

- 工具调用:测试“查询天气+生成周报”等多步骤任务,确认模型调用工具正常。

- 日志排查:WebUI“日志中心”查看模型调用日志,定位API Key错误、base_url不匹配、模型权限不足等问题。

四、常见问题与避坑

| 问题 | 原因 | 解决 |

|---|

| 调用失败 | API Key/地域不匹配 | 核对API Key与base_url地域一致 |

| 模型无响应 | 权限不足 | 百炼平台开通对应模型权限 |

| 上下文截断 | max_tokens过小 | 调大max_tokens至2000+ |

| 推理慢 | 模型选择不当 | 轻量任务换qwen-plus,复杂任务用qwen3-max |

五、进阶优化

- 多模型切换:配置多个百炼模型,任务中通过指令指定(如“用qwen3-coder-plus生成Python代码”)。

- 成本控制:设置max_tokens上限,开启缓存(WebUI“性能设置”),减少重复调用。

- 流式输出:WebUI“高级设置”启用流式响应,提升对话体验。

六、总结

优先用WebUI完成基础配置,进阶用命令行批量管理;核心是确保API Key、地域base_url、模型ID匹配,配置后测试并设置默认模型,即可稳定调用百炼模型完成各类任务。