DataWorks如何使用terraform创建sls日志同步任务?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

Terraform是基础设施即代码工具,虽然DataWorks本身不直接支持通过Terraform创建任务,但可以间接实现:

虽然Terraform直接创建DataWorks数据源的资源可能不存在,但你可以预先在阿里云控制台创建SLS(LogHub)和目标数据源(如MaxCompute、Hologres等),然后在Terraform中引用这些已创建资源的ID。

Terraform目前可能没有直接支持创建DataWorks数据集成任务的资源类型。但是,你可以考虑使用阿里云API调用或者Local Exec Provisioner来间接实现这一目的。例如,通过调用DataWorks OpenAPI来创建同步任务。

假设存在一个脚本create_sls_sync.sh,该脚本通过阿里云CLI或SDK调用DataWorks OpenAPI来创建SLS到目标存储的实时同步任务。

resource "null_resource" "create_sls_sync_task" {

provisioner "local-exec" {

command = "bash create_sls_sync.sh ${var.sls_project_name} ${var.sls_logstore_name} ${var.target_database} ${var.target_table}"

}

}

在这个示例中,你需要事先编写create_sls_sync.sh脚本来实现具体的逻辑,包括认证、构造请求体和调用API。变量如${var.sls_project_name}应事先在Terraform变量文件中定义。

相关链接

LogHub(SLS)实时ETL同步至Hologres 任务运维 https://help.aliyun.com/zh/dataworks/user-guide/abc

创建一个 Terraform 配置文件(例如 main.tf),定义所需的资源,例如 SLS 日志项目和日志库。

provider "alicloud" {

region = "cn-hangzhou"

}

resource "alicloud_sls_project" "default" {

name = "example-log-project"

description = "Example log project for DataWorks integration"

}

resource "alicloud_sls_logstore" "default" {

name = "example-logstore"

project_name = alicloud_sls_project.default.name

retention_period = 30

}

在 Terraform 配置文件所在的目录下,运行 terraform init 来初始化 Terraform 工作目录。

运行 terraform apply 来创建和配置资源。

要在DataWorks中使用Terraform创建SLS日志同步任务,您需要遵循以下步骤:

安装Terraform:首先,确保您已经安装了Terraform。如果没有,请访问https://www.terraform.io/downloads.html 下载并安装适合您操作系统的Terraform版本。

配置阿里云账号:在使用Terraform之前,您需要配置您的阿里云账号。您可以在命令行中运行aliyun configure命令,然后按照提示输入您的AccessKey ID和AccessKey Secret。

创建Terraform配置文件:创建一个名为main.tf的文件,其中包含以下内容:

复制代码运行

provider "alicloud" {

access_key = ""

secret_key = ""

region = "cn-hangzhou"

}

resource "alicloud_log_store" "example" {

project = ""

name = "example"

shard_count = 2

}

resource "alicloud_log_shipper" "example" {

project = ""

name = "example"

store = alicloud_log_store.example.name

source = ""

target = ""

filter = ""

buffer_interval = 60

buffer_size = 1000

status = "Enable"

}

请将、、、、和替换为您的实际值。

初始化Terraform:在命令行中,导航到包含main.tf文件的目录,然后运行以下命令以初始化Terraform:

bash

复制代码运行

terraform init

应用Terraform配置:运行以下命令以应用Terraform配置并创建SLS日志同步任务:

bash

复制代码运行

terraform apply

验证任务:登录到阿里云DataWorks控制台,检查是否已成功创建了SLS日志同步任务。

注意:在实际使用中,您可能需要根据您的需求调整Terraform配置文件中的参数。有关更多详细信息,请参阅阿里云官方文档:https://www.alibabacloud.com/help/doc-detail/98724.htm

用Terraform创建DataWorks与SLS日志同步任务的具体步骤在参考资料中未直接说明,但可以指导您一般性的思路。首先确保已安装和配置好Terraform,然后需要编写Terraform配置文件来定义DataWorks和SLS资源。

配置阿里云身份信息和地域。

使用alicloud_dataworks_project资源创建或引用DataWorks项目。

使用alicloud_log_project资源创建SLS日志项目。

使用alicloud_log_datahub资源创建DataHub topic(日志同步源)。

使用alicloud_log_consumer_group创建消费者组。

使用alicloud_log_shipper配置日志同步规则,指定DataHub topic和SLS日志库、日志集。

由于Terraform可能未直接提供DataWorks内日志同步的资源,您可能需要结合DataWorks API或者使用DataWorks控制台来配置同步任务。建议您在DataWorks控制台上完成日志同步的配置,然后使用Terraform进行状态管理,或者考虑使用阿里云提供的SDK或CLI工具来完成自动化。可参考文档

要在DataWorks中使用Terraform创建SLS日志同步任务,您需要遵循以下步骤:

安装Terraform:首先,确保您已经安装了Terraform。您可以从官方网站(https://www.terraform.io/downloads)下载适用于您操作系统的Terraform版本,并按照安装说明进行安装。

准备Terraform配置文件:创建一个名为main.tf的文件,其中包含您的Terraform配置。在这个文件中,您需要定义一个资源来创建SLS日志同步任务。以下是一个简单的示例:

复制代码运行

provider "alicloud" {

access_key = "your_access_key"

secret_key = "your_secret_key"

region = "cn-hangzhou"

}

resource "alicloud_log_store" "example" {

project = "your_project_name"

name = "example"

shard_count = 3

ttl = 30

shard_duration = 60

}

resource "alicloud_log_shipper" "example" {

project = "your_project_name"

name = "example"

store_name = alicloud_log_store.example.name

source = "your_source"

target = "your_target"

filter = "your_filter"

description = "example log shipper"

}

请确保替换your_access_key、your_secret_key、your_project_name、your_source、your_target和your_filter为您的实际值。

初始化Terraform:在包含main.tf文件的目录中,运行以下命令以初始化Terraform:

bash

复制代码运行

terraform init

应用Terraform配置:运行以下命令以应用您的Terraform配置并创建SLS日志同步任务:

bash

复制代码运行

terraform apply

验证任务创建:Terraform将输出创建的任务的详细信息。您可以登录到阿里云控制台,导航到日志服务页面,查看新创建的日志库和日志传输器。

注意:这个示例仅用于演示目的,实际使用时可能需要根据您的需求进行调整。

DataWorks使用Terraform创建SLS(Simple Log Service)日志同步任务的过程涉及几个关键步骤。首先,确保你已经安装了Terraform并在本地配置了必要的环境变量,如阿里云访问密钥(AccessKey ID和AccessKey Secret)以及区域(Region)等。

接下来,你需要创建一个Terraform配置文件(如terraform.tf),在该文件中定义SLS日志同步任务的具体配置。这包括指定日志源(如哪个Logstore)、目标存储(如阿里云数据仓库ADB等)、同步规则(如同步频率、同步时间范围等)。

然后,使用Terraform的init命令初始化工作目录,确保Terraform能够识别并加载所有必要的provider和插件。随后,通过plan命令预览将要进行的更改,以确保一切符合预期。

最后,使用apply命令执行配置文件中的定义,Terraform将根据你的配置自动创建SLS日志同步任务。在这个过程中,Terraform会处理所有必要的API调用和依赖关系,确保同步任务能够成功创建并运行。

请注意,由于Terraform和阿里云服务的不断更新,具体的配置细节可能会有所变化。因此,建议参考最新的Terraform文档和阿里云SLS服务文档来获取最准确的信息。

要在DataWorks中使用Terraform创建SLS(Serverless Log Service)日志同步任务,你需要先了解Terraform的基本概念以及如何使用阿里云Terraform Provider来实现这一目标。

以下是创建SLS日志同步任务的一般步骤:

安装和配置Terraform:

编写Terraform配置文件:

.tf文件,例如dataworks_sls.tf,并在其中定义你的资源。定义阿里云Provider:

定义SLS日志同步任务:

alicloud_dataworks_sls_task资源来定义日志同步任务。下面是一个简单的示例配置文件,用于创建一个SLS日志同步任务:

provider "alicloud" {

region = "your_region"

access_key = "your_access_key_id"

secret_key = "your_secret_access_key"

}

resource "alicloud_dataworks_project" "example_project" {

name = "my-dataworks-project"

description = "This is an example DataWorks project."

}

resource "alicloud_dataworks_sls_task" "example_sls_task" {

project_name = alicloud_dataworks_project.example_project.name

task_name = "my-sls-task"

type = "SLSTask"

schedule_type = "Once"

schedule_content = "0 0 * * ? *"

owner = "your_username"

description = "An example SLS sync task."

configuration = jsonencode({

slsConfig = {

logStore = "my-log-store"

project = "my-sls-project"

region = "your_sls_region"

accessKeyId = "your_access_key_id"

accessKeySecret = "your_secret_access_key"

}

dataworksConfig = {

projectName = alicloud_dataworks_project.example_project.name

tableName = "my_table"

partition = "dt=${bdp.system.bizdate}"

}

})

}

请注意以下几点:

alicloud_dataworks_project 是用来创建一个DataWorks项目的资源。alicloud_dataworks_sls_task 是用来创建SLS日志同步任务的资源。configuration 中的jsonencode 函数是用来将JSON对象转换成字符串的。configuration 中,slsConfig 包含了SLS的日志存储和项目信息,以及阿里云账号认证信息。dataworksConfig 包含了DataWorks项目的名称以及同步数据的目标表名和分区信息。初始化Terraform:

terraform init

验证配置文件:

terraform validate

显示将要创建的资源:

terraform plan

应用更改:

terraform apply

请确保替换上述示例代码中的占位符(如your_access_key_id等)为你自己的实际值。

如果你需要更详细的配置选项或者遇到了具体的问题,请告诉我,我会尽力提供帮助。

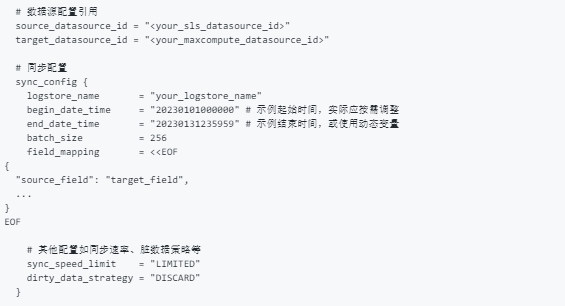

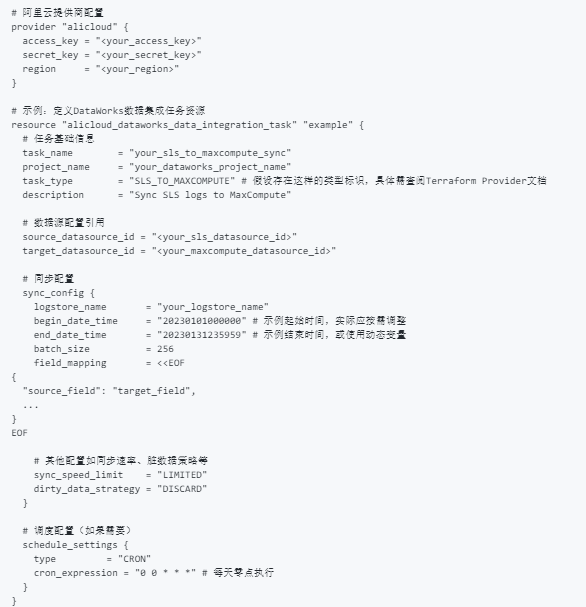

在DataWorks中使用Terraform来创建SLS(LogHub)日志同步任务至其他数据存储服务(如MaxCompute)的过程涉及几个关键步骤。虽然直接的Terraform配置示例未在提供的文档中明确给出,但我们可以基于Terraform对阿里云资源的支持和DataWorks的API接口,推断出一个大致的实现框架。以下是创建此类同步任务的概要指导:

安装Terraform: 确保本地环境已安装Terraform并配置好阿里云提供商。这包括设置provider块,配置阿里云访问密钥等。

创建数据源: 在DataWorks控制台手动完成LogHub(SLS)和目标数据存储(如MaxCompute)的数据源配置。这些配置细节通常不直接通过Terraform管理,但配置信息(如数据源名称、Endpoint等)将用于后续Terraform脚本中。

假设数据源已经创建,接下来通过Terraform创建DataWorks数据集成任务(同步任务)的逻辑框架如下:

虽然直接通过Terraform创建DataWorks中SLS日志同步任务的文档不详,但通过组合使用Terraform的阿里云Provider资源和必要的API调用,可以实现自动化创建和配置。务必参考最新的Terraform文档和阿里云API指南,以确保配置的准确性和可行性。

安装与配置Terraform:确保本地环境已安装Terraform并配置了阿里云提供商。这通常涉及设置provider块,包括access_key, secret_key, 和region等信息。

创建必要的数据源:在Terraform脚本中,首先定义LogHub(SLS)和Hologres的数据源资源。这可能需要使用alicloud_sls_project、alicloud_sls_log_store、alicloud_hologres_database等相关资源类型。

配置数据源

假设你有一个脚本create_data_integration.sh负责通过API创建同步任务

resource "null_resource" "create_sls_hologres_sync" {

provisioner "local-exec" {

command = "bash create_data_integration.sh ${alicloud_sls_project.example_project.name} ${alicloud_sls_log_store.example_logstore.name} ${alicloud_hologres_database.example_db.db_cluster_id}"

}

}

在create_data_integration.sh脚本中,你需要使用阿里云的SDK(如Python SDK)或者直接调用DataWorks OpenAPI来创建同步任务。这包括但不限于:

认证与初始化客户端。

构造任务配置,包括源LogStore、目标Hologres数据库、同步类型、网络配置等。

调用API创建任务。

根据需要配置任务的详细属性,如字段映射、数据处理逻辑、调度配置等。

貌似没有太明显的文档给出,但你可以参考这个

数据源配置:首先需要在DataWorks中配置好源端和目标端数据库的数据源信息,这是创建同步任务的前提条件

。

资源组配置:购买合适规格的独享数据集成资源组,并确保资源组与数据源网络已打通

。

创建同步任务:在DataWorks的控制台中,进入数据集成页面并创建同步任务。选择适当的同步方案,配置网络和资源

。

编写Terraform配置:使用Terraform的配置文件来定义DataWorks的资源和属性。Terraform的配置文件通常以.tf为扩展名,其中包含了资源定义和属性设置。

初始化Terraform:在Terraform配置文件所在目录执行terraform init命令来初始化Terraform工作目录,并下载所需的插件

本文介绍如何使用Terraform调用接口配置日志审计服务。

使用Terraform配置Logtail采集配置

配置步骤

步骤一:配置AccessKey和日志服务的中心化地域

步骤二:创建日志服务Project

步骤三:创建Logstore

步骤四:创建Logtail采集配置

步骤五:创建机器组

步骤六:应用Logtail采集配置到机器组

DataWorks基于MaxCompute/Hologres/EMR/CDP等大数据引擎,为数据仓库/数据湖/湖仓一体等解决方案提供统一的全链路大数据开发治理平台。