"

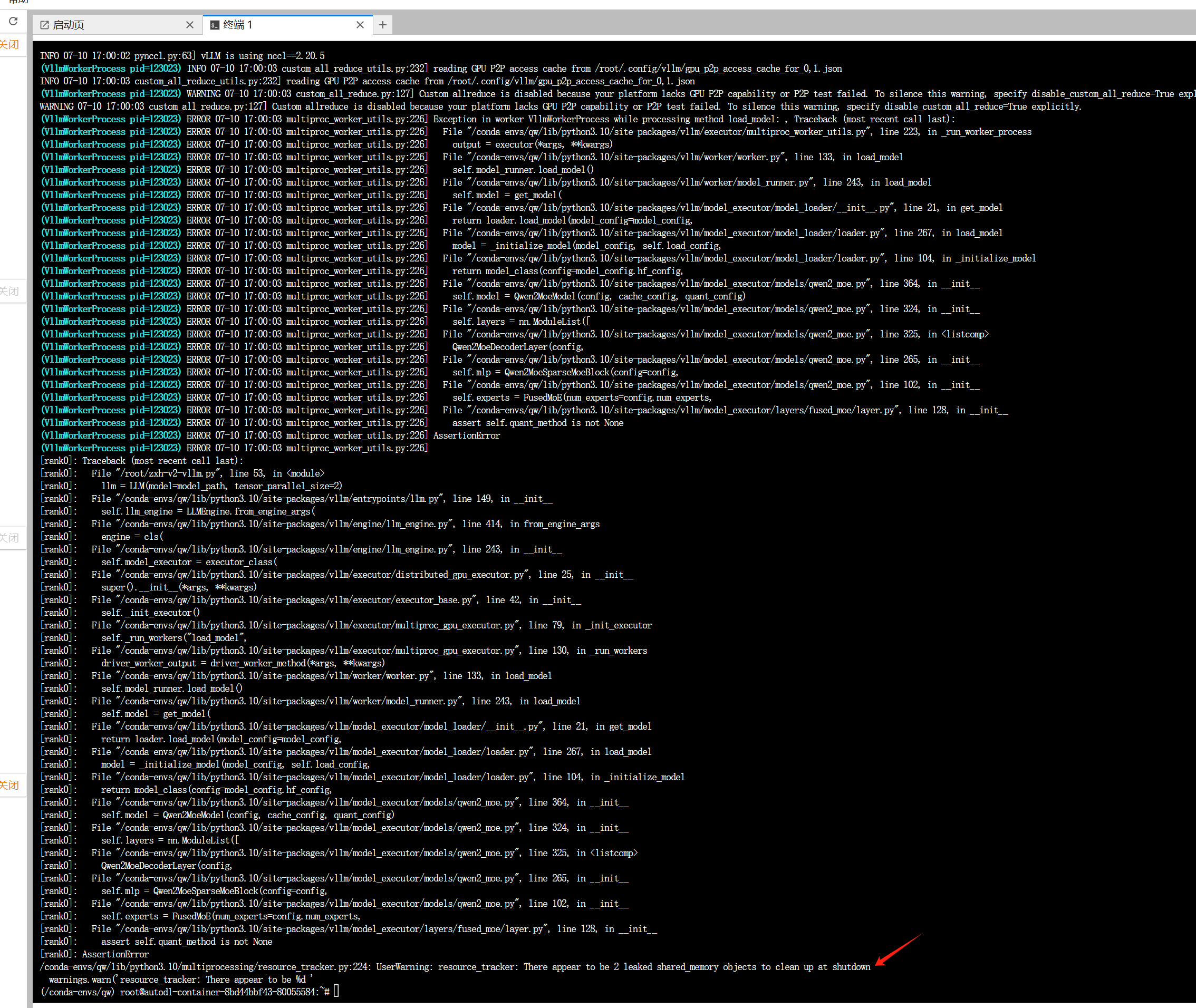

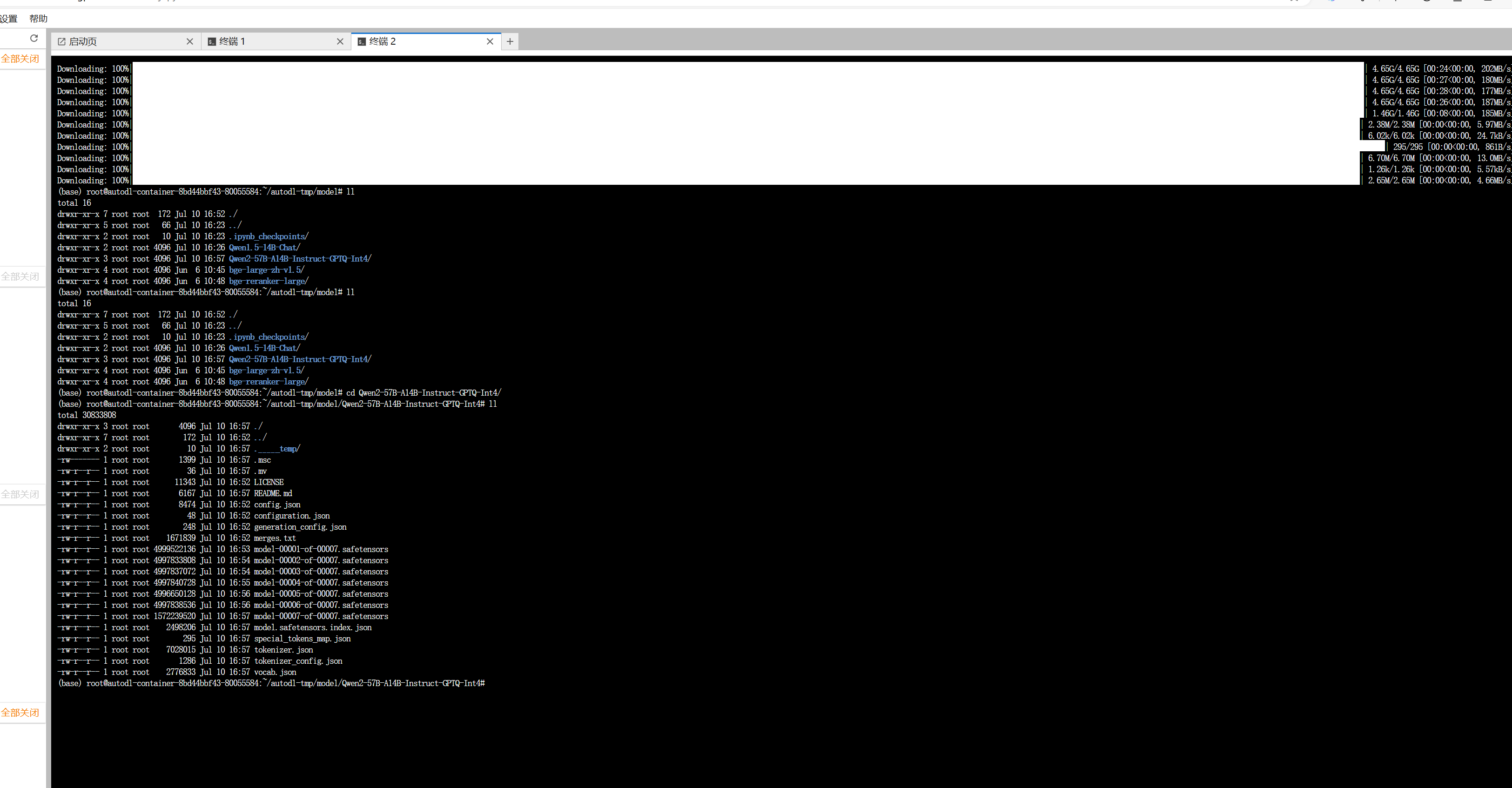

ModelScope使用vllm启动Qwen2-57B-A14B-Instruct-GPTQ-Int4,报这个错是什么意思? 模型下载我使用modelscope download --model 'qwen/Qwen2-57B-A14B-Instruct-GPTQ-Int4' --local_dir './Qwen2-57B-A14B-Instruct-GPTQ-Int4'

"

"

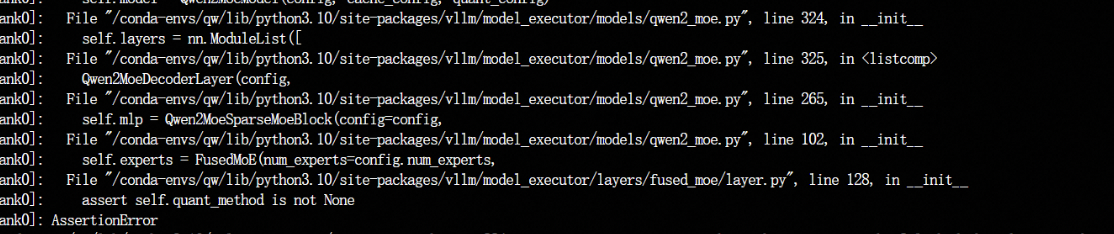

这个才是比较关键的日志,看错误应该是vllm对这个模型的支持仅限于量化版本,可以查看下vllm官方文档是否如此 。 --quantization参数会比较有用。参考以下链接

https://docs.vllm.ai/en/latest/quantization/auto_awq.html

此回答整理自钉群“魔搭ModelScope开发者联盟群 ①”"

ModelScope旨在打造下一代开源的模型即服务共享平台,为泛AI开发者提供灵活、易用、低成本的一站式模型服务产品,让模型应用更简单!欢迎加入技术交流群:微信公众号:魔搭ModelScope社区,钉钉答疑群:44837352