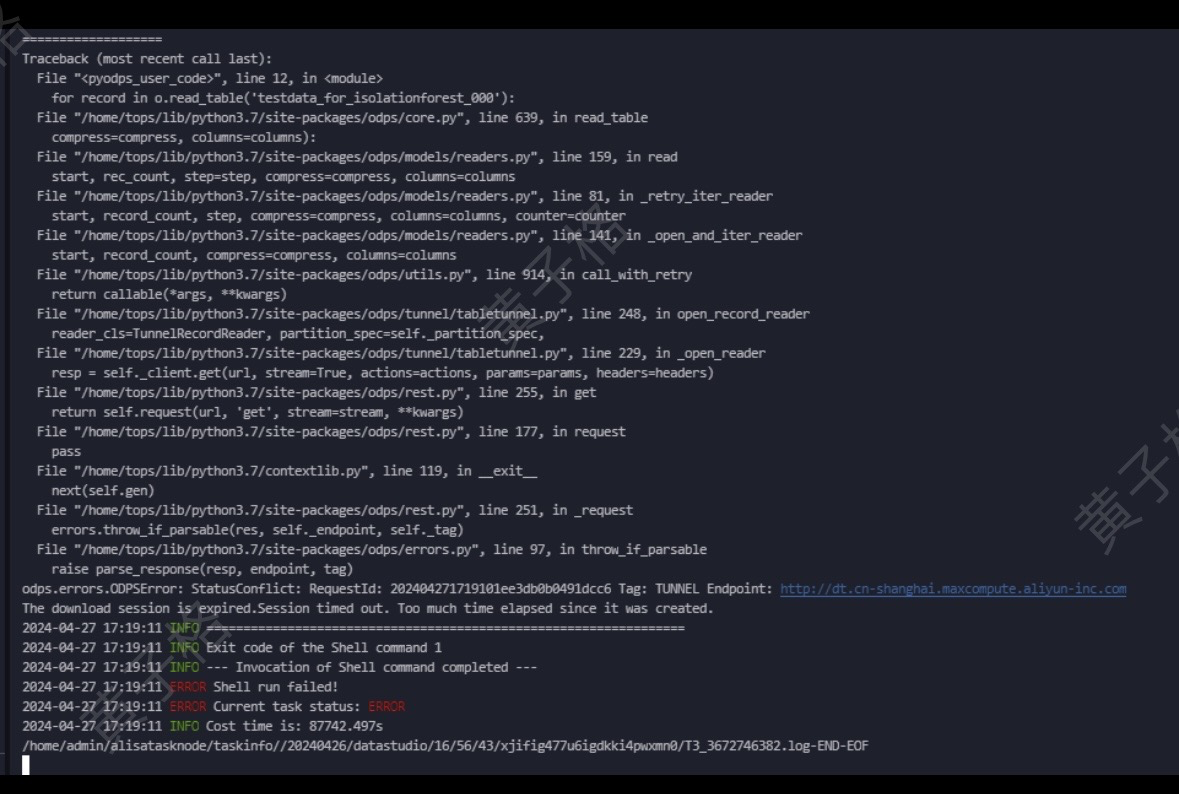

大数据计算MaxCompute中pyodps想读四千万条数据进行训练,但是跑了一天,最后显示会话过期怎么处理呢。odps.errors.ODPSError: StatusConflict: RequestId: 202404271719101ee3db0b0491dcc6 Tag: TUNNEL Endpoint: http:// dt.cn-shanghai.maxcompute.aliyun-inc.com

The download session is expired.Session timed out. Too much time elapsed since it was created.?sklearn里的随机森林

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在MaxCompute中使用PyODPS读取大规模数据(如四千万条记录)进行训练时,如果遇到会话过期的问题(odps.errors.ODPSError: StatusConflict: The download session is expired),通常是因为Tunnel下载会话的生命周期有限,而处理大量数据的时间超出了会话的有效时间。以下是针对该问题的解决方案和优化建议:

Tunnel会话默认有时间限制,若任务运行时间较长,可能导致会话过期。可以通过以下方式延长会话时间或避免会话过期: - 开启Instance Tunnel并关闭limit限制

在调用open_reader()方法时,显式启用Instance Tunnel,并关闭limit限制,以确保能够读取全量数据且避免受限模式。示例代码如下:

with instance.open_reader(tunnel=True, limit=False) as reader:

for record in reader:

# 处理每条记录

pass

注意:如果Project本身被保护,即使设置了tunnel=True和limit=False,也无法解除保护限制,需联系Project Owner开放权限。

分批次读取数据

如果单次读取四千万条数据耗时过长,可以将数据分批次读取,避免单次会话超时。例如,通过SQL语句中的LIMIT和OFFSET实现分页读取:

batch_size = 1000000 # 每批次读取100万条

offset = 0

while True:

sql = f"SELECT * FROM your_table LIMIT {batch_size} OFFSET {offset}"

with o.execute_sql(sql).open_reader(tunnel=True) as reader:

records = list(reader)

if not records:

break

# 处理当前批次数据

process_records(records)

offset += batch_size

PyODPS默认的连接超时时间为5秒,可能不足以处理大规模数据。可以通过调整options.connect_timeout参数增加超时时间:

from odps import options

options.connect_timeout = 60 # 设置超时时间为60秒

此外,还可以捕获异常并重试,以应对网络波动或临时性错误。

如果直接使用SQL读取数据效率较低,可以尝试使用PyODPS的DataFrame API进行数据处理。DataFrame支持分布式计算,能够更高效地处理大规模数据。例如:

from odps.df import DataFrame

# 获取表数据

iris = DataFrame(o.get_table('your_table'))

# 筛选数据并分批处理

batch_size = 1000000

for i in range(0, 40): # 假设总数据量为4000万条

subset = iris[i * batch_size:(i + 1) * batch_size]

result = subset.execute() # 执行并获取结果

process_records(result)

如果数据量过大且无法直接读取,可以考虑在MaxCompute中对数据进行预处理或脱敏后导出到非保护Project中再读取: - 预处理:通过SQL或DataFrame API对数据进行筛选、聚合等操作,减少需要读取的数据量。 - 脱敏:使用DataWorks或其他工具对敏感数据进行脱敏处理,然后导出到非保护Project中。

在部分环境中(如DataWorks),由于沙箱限制可能导致网络访问受限,从而引发连接失败或超时问题。建议使用独享调度资源组执行任务,以避免此类问题。

在使用sklearn的随机森林模型训练时,建议结合上述数据读取优化方法,同时注意以下几点: - 分批次训练:如果数据量过大,可以将数据分批次读取并训练模型,最后合并模型结果。 - 特征选择:通过特征选择减少输入数据的维度,提升训练效率。 - 分布式训练:如果单机训练性能不足,可以考虑使用分布式机器学习框架(如阿里云PAI平台)进行训练。

open_reader(limit=False)解除限制。options.verbose选项,查看详细的运行日志,便于排查问题。通过以上方法,您可以有效解决会话过期问题,并高效完成大规模数据的读取与训练任务。您可以复制页面截图提供更多信息,我可以进一步帮您分析问题原因。

MaxCompute(原ODPS)是一项面向分析的大数据计算服务,它以Serverless架构提供快速、全托管的在线数据仓库服务,消除传统数据平台在资源扩展性和弹性方面的限制,最小化用户运维投入,使您经济并高效的分析处理海量数据。