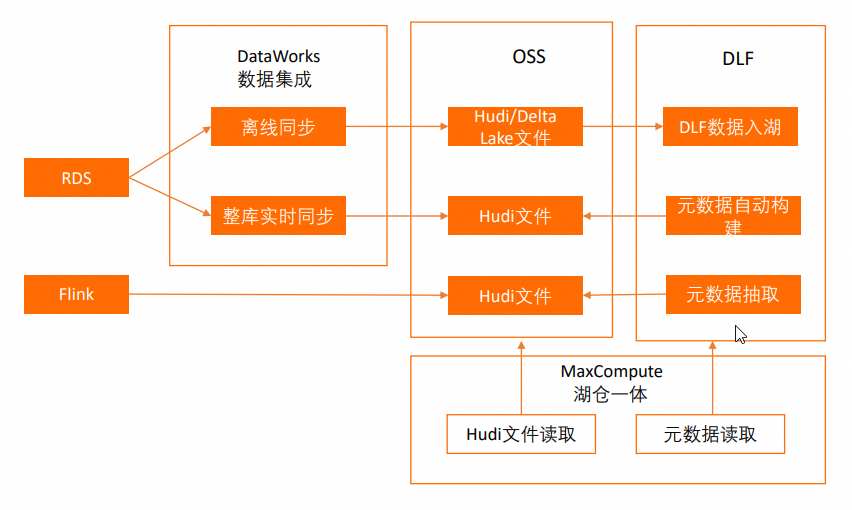

大数据计算MaxCompute文档中有 spark 访问 OSS 部分。我想实现的是 通过 spark 写入 hudi 文件到 oss ,再用 maxcomputer 进行读取外部表。但是我 spark 访问 oss 一直说我证书错误。这个您知道是什么问题吗?

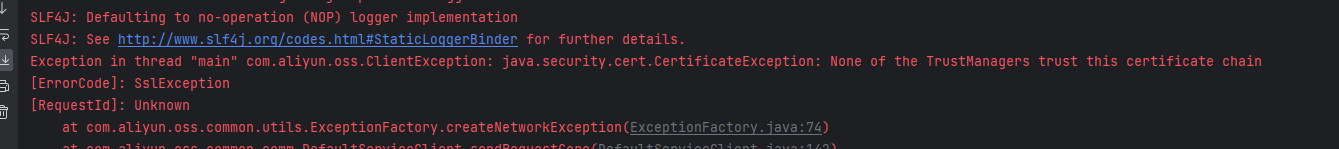

Exception in thread "main" com.aliyun.oss.ClientException: java.security.cert.CertificateException: None of the TrustManagers trust this certificate chain

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在Spark访问OSS时出现证书错误的问题,可能是由于以下几个原因造成的:

spark.hadoop.fs.oss.credentials.provider和spark.hadoop.fs.oss.ststoken.roleArn这两个配置项已经被正确设置。综上所述,在处理这类问题时,您可以从上述几个方面进行排查和调整。如果问题依旧无法解决,建议查阅阿里云官方文档或联系阿里云技术支持获取更专业的帮助。同时,确保您的操作符合最佳安全实践,避免泄露敏感信息。

看上去不是MaxCompute侧抛出的,我理解和本机有关系。查到一篇文章,可以参考下

https://developer.aliyun.com/article/1323030 ,此回答整理自钉群“MaxCompute开发者社区2群”

关于Spark访问OSS出现证书错误的问题,这通常是由于SSL/TLS连接配置不正确导致的信任链验证失败。以下是可能的原因及解决方案:

证书未被信任:确认您使用的JVM或Spark集群中是否包含了阿里云OSS服务端证书的信任根证书。如果未包含,则需要将有效的CA证书添加到您的Java Keystore中,或者在客户端配置中指定正确的信任存储路径和密码。

自签名证书:若OSS使用了自签名证书,请确保该自签名证书已被客户端接受或导入到信任库中。

配置问题:检查您的Spark连接OSS的相关配置项,比如spark.hadoop.fs.oss.ssl.enabled、spark.hadoop.fs.oss.client.ssl.provider等,确保它们指向了正确的安全配置。

网络代理影响:如果有网络代理介入并修改了SSL连接,可能会导致证书验证失败。确保代理配置正确,并且不会干扰HTTPS连接的安全性。

过期或无效证书:确认阿里云OSS服务端证书是否有效,有时服务端更新了证书而客户端未及时更新也会导致此类错误。

解决此问题通常涉及以下步骤:

MaxCompute(原ODPS)是一项面向分析的大数据计算服务,它以Serverless架构提供快速、全托管的在线数据仓库服务,消除传统数据平台在资源扩展性和弹性方面的限制,最小化用户运维投入,使您经济并高效的分析处理海量数据。