实时计算 Flink版1.18提交到k8s 任务过一会自动cancel 有人遇到同样的问题嘛?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

实时计算Flink版1.18在K8s上提交的任务自动取消可能是由于多种原因,如资源不足、配置错误或K8s集群问题等。建议检查以下几点:

在 Kubernetes (k8s) 上运行 Apache Flink 实时计算任务时,如果任务在提交后不久自动取消(cancel),这可能是由于多种原因造成的。以下是一些可能导致这种情况的常见因素,以及相应的排查步骤:

kubectl get events 命令查看与 Flink 任务相关的 Kubernetes 事件。kubectl get pods 和 kubectl describe pod <pod-name> 来检查 Pod 的状态和事件。针对您提到的实时计算Flink版1.18提交到Kubernetes(k8s)环境中,任务在运行一段时间后自动取消(CANCELLED)的问题,尽管提供的参考资料未直接涵盖该特定场景,但可以提供一些可能的原因分析和解决思路:

资源限制:检查Kubernetes集群中是否有资源限制(如CPU、内存)导致任务被Kubernetes自动终止。确保为Flink作业预留足够的资源,并监控作业运行时的资源使用情况

作业配置问题:确认作业配置中是否存在导致自动取消的设置,比如超时时间、故障重试策略等。检查作业的yaml配置,确保没有意外设置了短时间的生命周期管理或不恰当的取消策略。

系统或版本兼容性:虽然问题未直接提及版本不兼容,但不同版本的Flink与Kubernetes可能存在特定的兼容性问题。确认Flink 1.18与您的Kubernetes版本以及其他组件(如Hadoop、Hive等)之间是否存在已知的兼容性问题。

日志分析:查看Flink作业的运行日志,包括Kubernetes事件日志和Flink作业管理器的日志,以获取取消任务的具体原因。错误信息或警告通常能提供问题发生的直接线索。

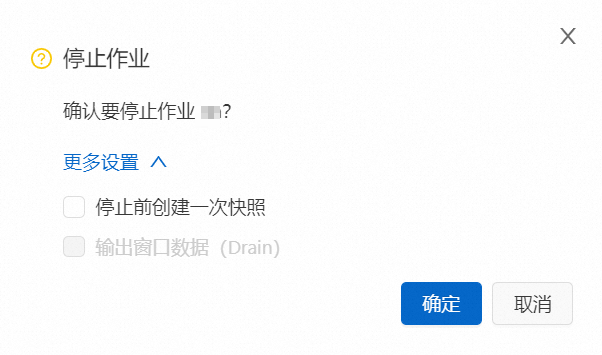

强制停止机制:虽然您的情况是任务自动取消,不是主动操作的结果,但参考文档中提到的强制删除方法(通过编辑yaml添加特定注解来强制停止作业)展示了作业控制的一种高级手段。这不一定直接解决您的问题,但了解这些高级操作可能在排查过程中有所启发。

社区与官方支持:考虑到问题的特殊性,如果上述步骤不能定位问题,建议在阿里云官方论坛、Flink社区或者通过阿里云技术支持寻求帮助,可能有其他用户遇到过类似问题或有更具体的解决方案。

综上所述,自动取消问题可能涉及多个方面,需要从资源、配置、日志等多个角度综合排查。希望这些建议能帮助您定位并解决问题。

Apache Flink 在 Kubernetes 上部署时遇到任务自动取消的问题可能是由多种因素引起的。在 Flink 1.18 版本中部署到 Kubernetes 集群时,如果任务过一会儿自动被取消,可以尝试从以下几个方面排查问题:

我没遇到,但这有可能你是任务处于TRANSITIONING>CANCELLED状态,想要强制删除,可以通过编辑作业的YAML文件,在annotation中添加特定配置来实现强制取消。

然后重新部署作业,注意不要改变部署目标。

你试试嘞

Apache Flink在Kubernetes上运行时,任务自动取消(cancel)可能由多种原因造成。在Flink 1.18版本中部署到Kubernetes环境,如果任务过一段时间自动取消,以下是一些可能的原因和排查步骤:

资源限制:

Kubernetes的资源限制(如CPU、内存)可能被耗尽,导致Pods被驱逐或Flink任务被终止。检查你的JobManager和TaskManager的资源请求和限制是否合理,以及Kubernetes集群的资源使用情况。

Flink配置:

检查你的Flink配置是否正确,特别是在Kubernetes上的特定配置,例如jobmanager.kubernetes.watch-dog.enabled是否被错误地设置为true,这会导致任务在完成或失败后自动删除。

Kubernetes配置:

查看你的Kubernetes配置,确保没有设置任何自动清理完成任务的策略,例如Job控制器的completions和parallelism参数,以及是否有TTLAfterFinished注释。

Flink重启策略:

检查Flink的重启策略是否配置得过于严格,例如restart-strategy.attempts设置得太低,或者restart-strategy.failure-rate-time和restart-strategy.failure-rate配置不当,导致在短时间内多次失败后任务被永久停止。

健康检查:

Kubernetes的健康检查(liveness probes)或就绪检查(readiness probes)可能触发Pods的重启,检查这些配置是否过于敏感或设置不当。

网络问题:

网络分区或连接超时也可能导致任务自动取消,检查网络配置和连通性。

存储问题:

如果Flink作业依赖于外部存储系统(如StateBackend),则该系统的不稳定可能导致任务失败。

日志和指标:

查看Flink和Kubernetes的日志,以及Flink和Kubernetes的监控指标,以获取关于任务为何取消的线索。

Flink和Kubernetes版本兼容性:

确保你正在使用的Flink版本与Kubernetes版本兼容,有时候版本不匹配也会导致问题。

如果你在排查过程中发现具体错误信息或异常行为,可以针对性地调整配置或修复问题。另外,Flink社区和Kubernetes社区都有丰富的文档和论坛资源,你可以在那里搜索类似问题或提问以获得帮助。

如果你正在使用阿里云的实时计算Flink版,可能还涉及到云平台特定的配置和限制,建议查阅阿里云的官方文档或联系技术支持获取更详细的指导。

资源不足:Kubernetes集群可能没有足够的资源(如CPU、内存)来运行Flink作业。

配置问题:Flink配置或Kubernetes配置可能有误,例如,资源请求和限制设置不当,或者与Kubernetes的集成配置不正确。

任务失败:如果Flink作业因为某些错误而失败,它可能会被自动取消。

JobManager问题:JobManager可能由于某种原因崩溃或重启,导致作业被取消。

超时:如果Flink作业启动超时,Kubernetes可能会自动终止它。

自动缩放策略:Kubernetes的自动缩放策略可能导致作业在不满足某些条件时被自动取消。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。