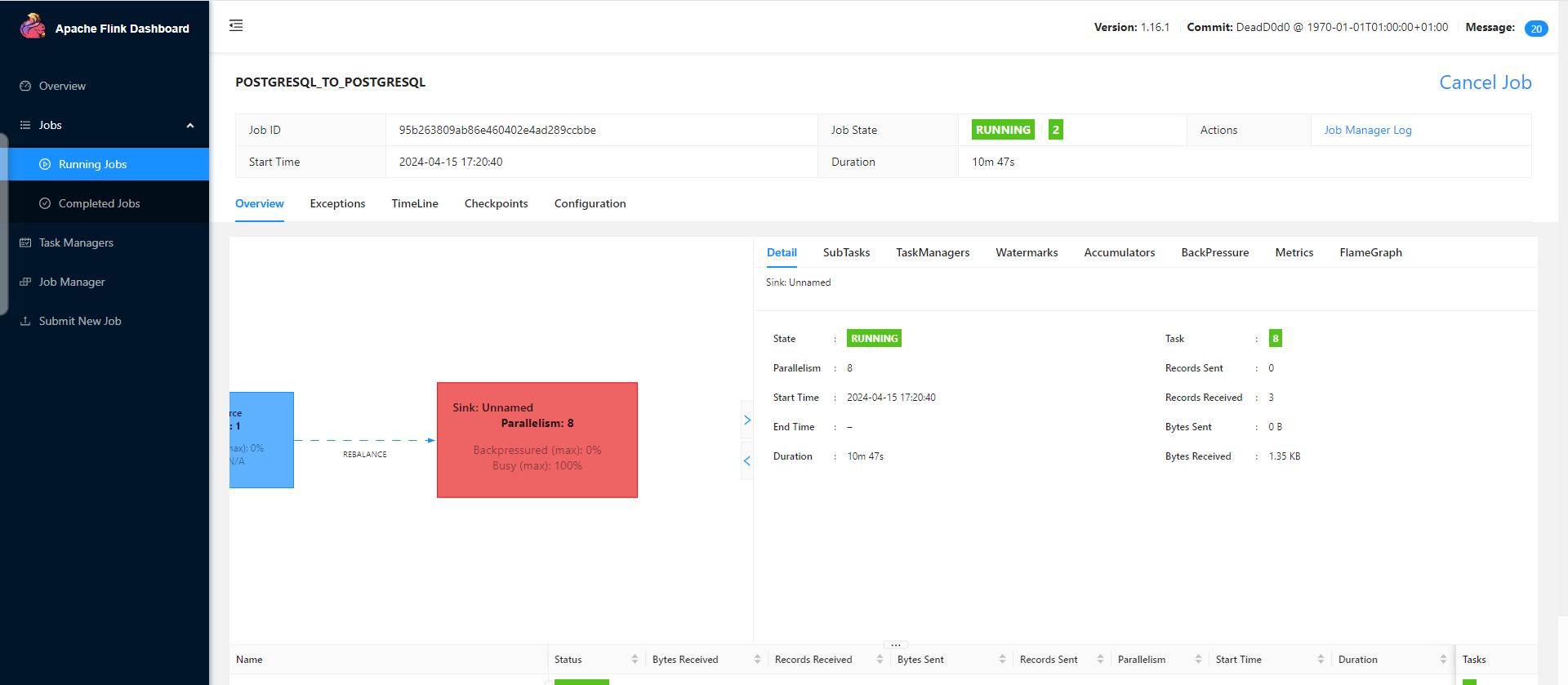

Flink CDC里修改一条数据,怎么就背压了啊? 没报错。

没报错。 调试就两张表,2条数据,这种情况要怎么处理啊?

调试就两张表,2条数据,这种情况要怎么处理啊?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在Flink CDC中,即使只有两张表和两条数据的情况下,仍然可能出现背压(BackPressure)现象。背压通常表明作业的某些算子处理能力不足,导致数据在流处理管道中堆积。尽管没有报错,但背压可能会影响作业的性能和实时性。

根据知识库中的信息,背压的原因可能与以下几个方面相关: 1. 数据拉取能力不足:Source算子从上游系统(如MySQL Binlog)拉取数据的速度较慢。 2. 数据处理能力不足:下游算子处理数据的速度跟不上数据流入的速度。 3. 网络或资源瓶颈:网络I/O或CPU、内存等资源不足可能导致背压。

通过Flink Web UI或监控指标定位背压的具体原因: - 查看current Fetch Event Time Lag和current Emit Event Time Lag指标: - 如果两个延迟非常接近,说明Source算子从MySQL Binlog拉取数据的能力不足(可能是网络I/O或并发数限制)。 - 如果两个延迟差值较大,说明作业的处理能力不足,导致数据在Source中有滞留。 - 检查BackPressure页面: - 在Flink Web UI中,进入目标作业的状态总览页签,查看BackPressure页面,定位有问题的Vertex拓扑。 - 进一步分析Thread Dump页面,查看堆栈信息以定位瓶颈点。

如果背压是由于Source端拉取数据能力不足导致的,可以尝试以下优化措施: - 增加Task Manager的CPU资源: - 如果Source出现finish split response timeout异常,可能是因为Task的CPU使用率过高。可以在资源配置页面增加Task Manager的CPU资源。 - 启用CDC Source复用: - 如果Binlog包含整个MySQL实例的所有变更数据,而Flink CDC仅过滤特定表的变更记录,可以通过启用Source复用来减少带宽消耗。

如果背压是由于下游算子处理能力不足导致的,可以尝试以下优化措施: - 检查数据处理逻辑: - 确保作业代码逻辑正确,避免不必要的计算或转换操作。 - 如果使用了transform模块进行数据转换,检查转换规则是否过于复杂。 - 调整并行度: - 增加作业的并行度,提升下游算子的处理能力。 - 在Flink作业配置中,调整parallelism.default参数。

针对当前场景(两张表、两条数据),可以按照以下步骤逐步排查和解决问题: 1. 简化作业逻辑: - 暂时移除复杂的转换逻辑,确保作业仅包含基本的CDC数据同步功能。 2. 监控指标验证: - 部署简化后的作业,观察numRecordsIn和numRecordsOut指标,确认数据是否正常流入和流出。 3. 逐步增加复杂度: - 在确认基本功能正常后,逐步添加转换逻辑或其他功能模块,观察背压是否再次出现。

背压问题的根本原因可能涉及数据拉取能力、处理能力或资源瓶颈。通过监控指标定位问题后,可以针对性地优化Source端配置、调整数据处理逻辑或增加资源分配。对于当前场景,建议先简化作业逻辑,逐步排查问题根源。您可以复制页面截图提供更多信息,我可以进一步帮您分析问题原因。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。