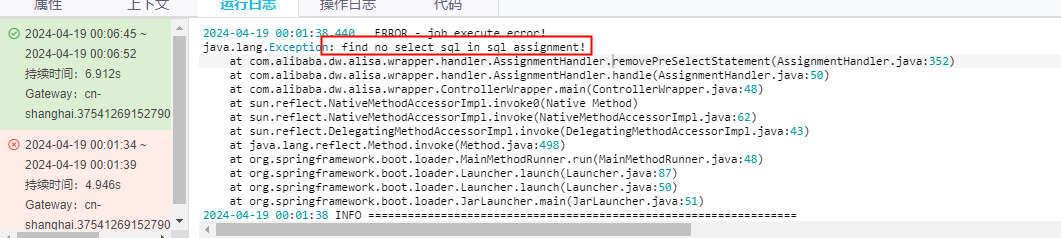

大数据计算MaxCompute赋值截点为啥会报这种错误,重试又成功了?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在MaxCompute中,出现赋值截点(如Transaction timeout because cannot acquire exclusive lock)错误的原因通常与并发写入操作有关。以下是详细分析和解决方法:

该错误的核心原因是表级元数据锁冲突。具体表现为: - MaxCompute允许多个作业同时写入同一张表或分区。 - 当多个作业同时处于元数据提交阶段时,每个作业都需要对表的元数据加锁、写入、再解锁。 - 如果并发写入的作业过多,或者写入的数据量较大(如涉及大量分区),可能会导致某些作业在尝试加锁时超时,从而报错。

关键点: - 加锁粒度为表级,即所有写入操作共享同一把锁。 - 作业尝试加锁的超时时间约为半分钟,超过此时间未获取锁则会报错。

重试成功的原因可能包括以下几点: 1. 资源竞争缓解: - 在第一次尝试失败后,其他并发作业可能已完成写入并释放了锁,减少了锁竞争。 - 系统资源(如CPU、内存、磁盘I/O)的压力可能有所缓解,使得后续重试能够成功。

随机化重试机制:

短暂的网络或系统波动:

为了避免类似问题频繁发生,建议采取以下措施:

set odps.transaction.timeout=60; -- 单位为秒,默认为30秒

注意:此参数需要根据实际业务需求谨慎调整,过长的超时时间可能导致其他作业等待过久。

alter table <table_name> merge smallfiles;

通过以上分析和优化措施,可以有效减少赋值截点错误的发生概率,并提升MaxCompute作业的稳定性和效率。

MaxCompute(原ODPS)是一项面向分析的大数据计算服务,它以Serverless架构提供快速、全托管的在线数据仓库服务,消除传统数据平台在资源扩展性和弹性方面的限制,最小化用户运维投入,使您经济并高效的分析处理海量数据。