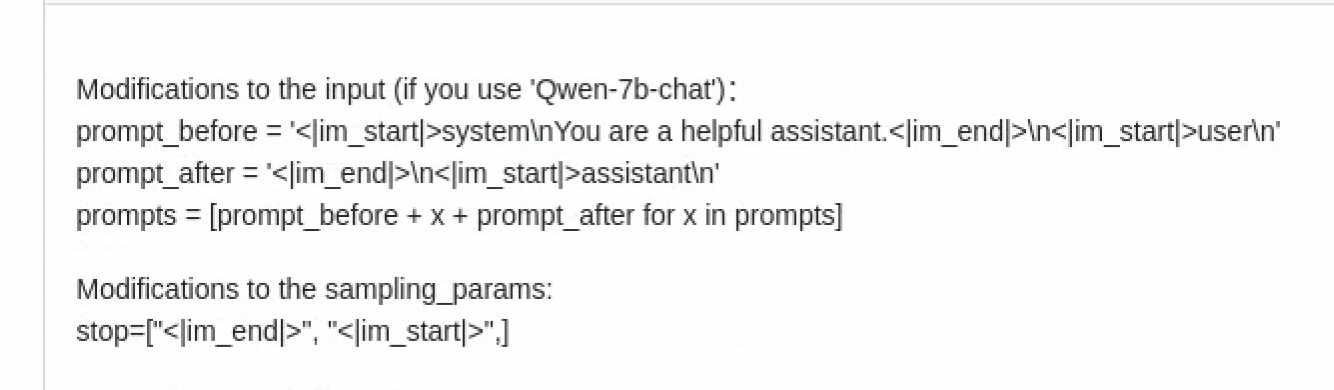

"如果在用qwen-chat做推理的时候,产生的回答会包含prompt以及<|im_end|>\n<|im_start|>,ModelScope按照下面的格式改过输入格式,但是还是不行 ?

"

这边的ms-swift也提供了vllm部署,您测一下看看会不会出现这个问题。文末,https://github.com/modelscope/swift/blob/main/docs/source/LLM/VLLM%E6%8E%A8%E7%90%86%E5%8A%A0%E9%80%9F%E4%B8%8E%E9%83%A8%E7%BD%B2.md 此回答整理自“魔搭ModelScope开发者联盟群 ①”。

ModelScope旨在打造下一代开源的模型即服务共享平台,为泛AI开发者提供灵活、易用、低成本的一站式模型服务产品,让模型应用更简单!欢迎加入技术交流群:微信公众号:魔搭ModelScope社区,钉钉群号:44837352