Flink CDC里能够读取到库表,读不到表中的数据怎么办?checkpoint默认开启的,别的库是可以的,这个库不行。

Flink CDC里能够读取到库表,读不到表中的数据怎么办?checkpoint默认开启的,别的库是可以的,这个库不行。

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在使用Flink CDC读取MySQL库表时,如果能够正常识别到库表但无法读取表中的数据,而其他库可以正常工作,可能是由于以下原因导致的。以下是详细的排查步骤和解决方案:

SELECT、REPLICATION SLAVE和REPLICATION CLIENT权限。GRANT SELECT, REPLICATION SLAVE, REPLICATION CLIENT ON <database_name>.* TO '<username>'@'<host>';

FLUSH PRIVILEGES;

ROW模式:

SHOW VARIABLES LIKE 'binlog_format';

如果结果不是ROW,需要修改配置文件(如my.cnf)并重启MySQL服务:

[mysqld]

log-bin=mysql-bin

binlog_format=ROW

server-id=1

binlog-ignore-db或replicate-ignore-db配置)。SET 'execution.checkpointing.interval' = '5min';

Finished reading snapshot for table的信息。DESCRIBE命令检查表结构是否与物理表一致:

DESCRIBE `<catalogname>`.`<dbname>`.`<tablename>`;

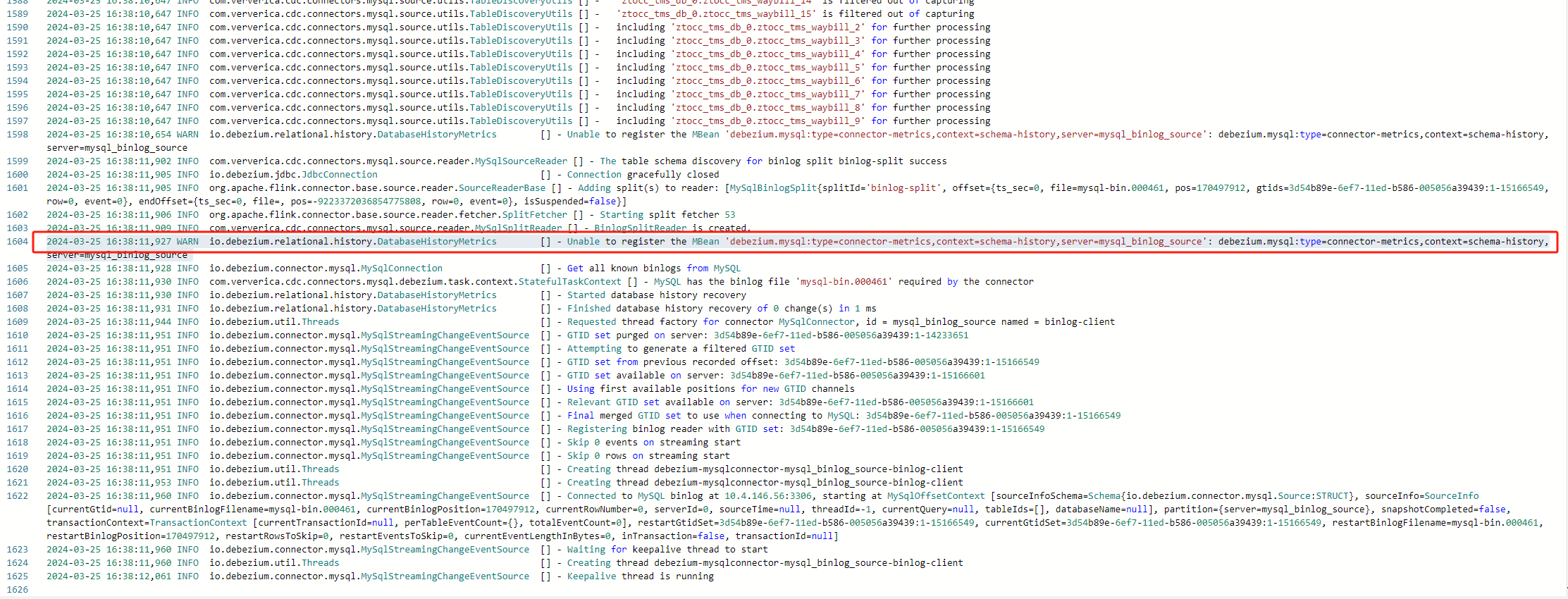

Open TaskManager Log Page。Caused by信息,分析根因。server-id参数,确保其范围足够大以支持并发读取。server-id范围:

/*+ OPTIONS('server-id'='6000-6018') */

server-id数量大于等于并发度。以上步骤涵盖了从权限、binlog配置、Checkpoint设置、字段映射到网络连通性等多个方面的排查方法。如果按照上述步骤仍无法解决问题,请提供更详细的日志信息以便进一步分析。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。