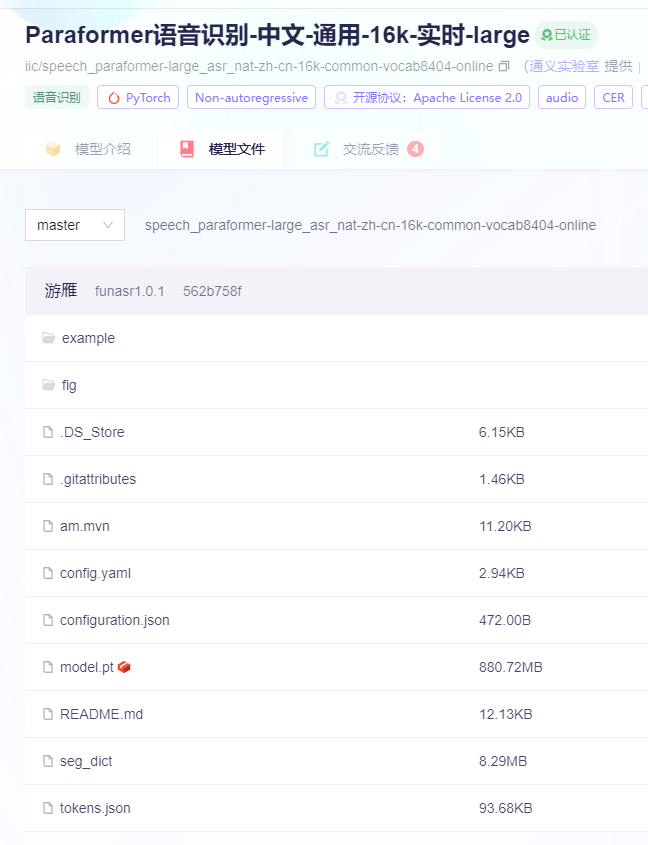

像这种模型 没有model.onnx和model_quant.onnx文件的话,开启funasr_wss_server服务端要怎么调用呢?modelscope-funasr有没有什么办法去处理一下?

在使用ModelScope-Funasr进行语音识别时,如果没有model.onnx和model_quant.onnx文件,确实可能会遇到无法直接使用现有服务端调用模型的问题。以下是一些建议来解决这个问题:

总之,请根据实际情况尝试上述建议,希望能够帮助您解决ModelScope-Funasr模型在没有model.onnx和model_quant.onnx文件时的服务端调用问题。如果问题依然存在,建议直接联系技术支持获取更专业的指导。

在使用ModelScope-Funasr时,如果遇到没有model.onnx和model_quant.onnx文件的情况,可以尝试以下方法来处理:

torch.onnx.export()函数进行导出。总的来说,通过上述方法,您应该能够找到合适的解决方案来处理没有model.onnx和model_quant.onnx文件的问题,并成功在Funasr服务端调用模型。