在ModelScope中,如果遇到loss不稳定的情况,通常需要调整以下关键参数以优化模型训练效果。这些参数的调整可以帮助提升模型的稳定性和性能:

1. 学习率(Learning Rate)

- 学习率是影响模型训练稳定性的重要参数之一。如果学习率设置过高,模型参数可能会剧烈变化,导致loss波动较大;如果学习率过低,模型可能收敛缓慢或陷入局部最优。

- 建议调整方法:

- 从较小的学习率(如

1e-5)开始尝试。

- 如果loss波动较大,可以逐步减小学习率(如缩小10倍)。

- 使用动态学习率调整策略(如

cosine),通过lr_scheduler_type参数设置。

2. 批次大小(Batch Size)

- 批次大小决定了每次训练时送入模型的数据量。较小的批次可能导致loss波动较大,而较大的批次则有助于稳定训练过程。

- 建议调整方法:

- 推荐使用默认值(如8、16或32),并根据实际训练效果进行微调。

- 如果loss不稳定,可以尝试增大批次大小以平滑梯度更新。

3. 循环次数(Epochs)

- 循环次数决定了模型遍历整个训练数据集的次数。过多的循环可能导致过拟合,尤其是在数据量较少的情况下;过少的循环可能导致模型欠拟合。

- 建议调整方法:

- 根据数据量和任务复杂度调整

n_epochs参数。对于复杂任务,建议至少训练20轮左右。

- 监控验证集上的loss(Validation Loss),当其开始上升时,停止训练以避免过拟合。

4. 裁剪阈值(Clipping Threshold)

- 裁剪阈值用于限制梯度的范围,防止梯度爆炸问题。如果loss波动较大,可能是梯度不稳定导致的。

- 建议调整方法:

- 增大裁剪阈值以减少梯度截断的影响,但需注意过大的裁剪阈值可能降低模型的收敛速度。

5. 正则化项(Regularization)

- 正则化项(如L1或L2正则)可以防止模型过拟合,从而提高训练的稳定性。

- 建议调整方法:

- 增加权重衰减项(

weight_decay),取值范围为[0, 1)之间的浮点数。

- 根据任务需求选择合适的正则化类型(L1或L2)。

6. 验证步数(Eval Steps)

- 验证步数决定了模型在训练过程中进行验证的频率。过于频繁的验证可能导致loss波动,而验证不足则无法及时发现问题。

- 建议调整方法:

- 设置合理的

eval_steps参数(如50),以平衡验证频率和训练效率。

7. 序列长度(Max Length)

- 序列长度限制了单条训练数据的最大token数量。如果数据长度超出设定值,可能会导致部分数据被丢弃,从而影响训练稳定性。

- 建议调整方法:

- 确保

max_length参数设置合理(如2048),以覆盖大部分训练数据的长度。

8. 学习率预热比例(Warmup Ratio)

- 学习率预热比例控制了训练初期学习率的增长速度。如果预热比例设置不当,可能导致训练初期loss波动较大。

- 建议调整方法:

- 设置合理的

warmup_ratio(如0.05),以帮助模型在训练初期更稳定地收敛。

重要提醒

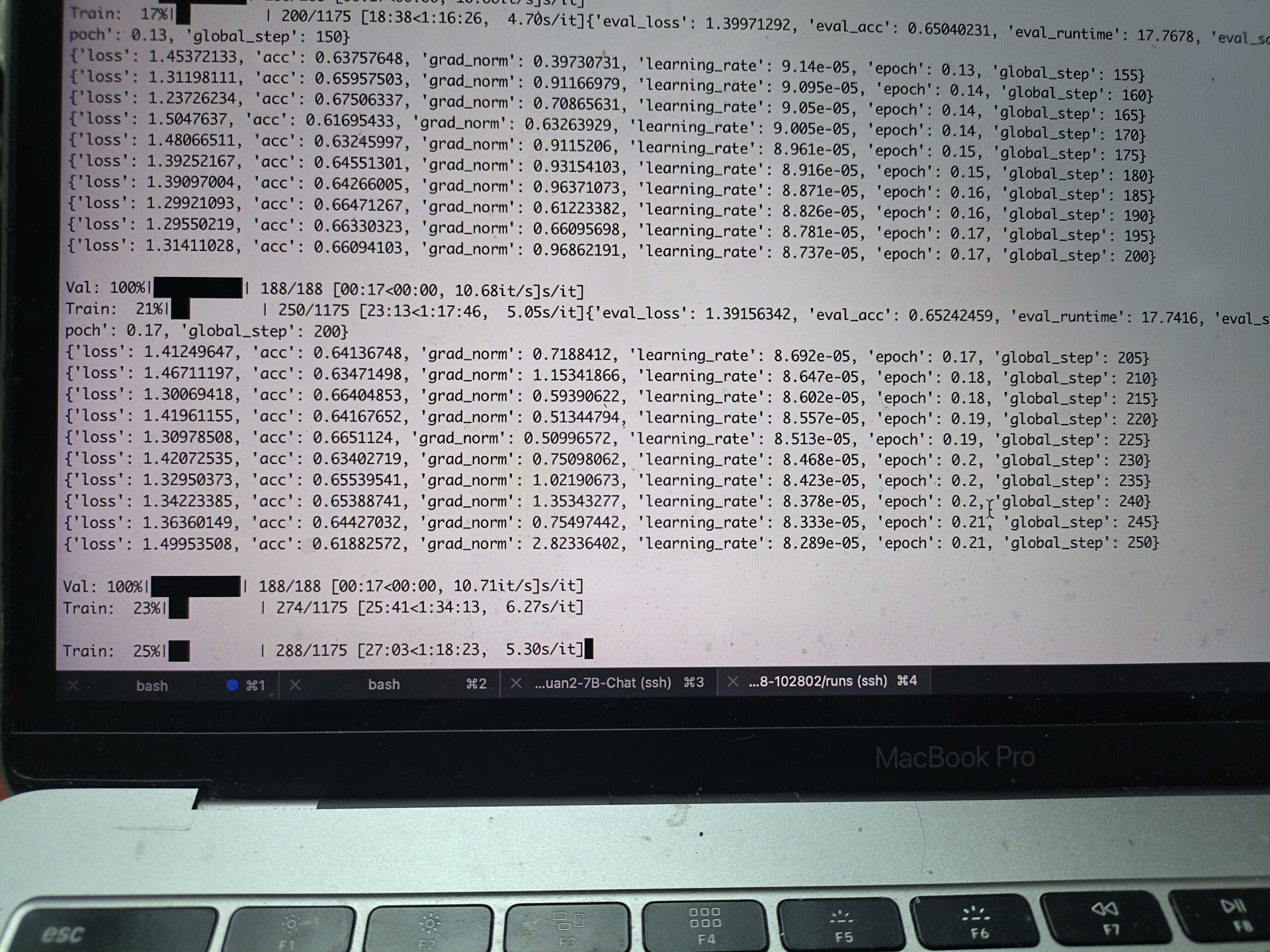

- 监控训练指标:在训练过程中,实时监控

Training Loss、Validation Loss和Validation Token Accuracy的变化趋势。如果Validation Loss呈现先下降后上升的趋势,说明模型可能开始过拟合,应及时调整超参数。

- 实验与调优:不同任务对超参数的需求可能有所不同,建议通过多次实验找到最佳配置。

通过以上参数的调整和优化,可以有效解决ModelScope中loss不稳定的问题,提升模型的训练效果和稳定性。