modelscope-funasr通义听悟里面的语音识别和声纹识别 ,用的是funasr框架里面可组合的模型吗?

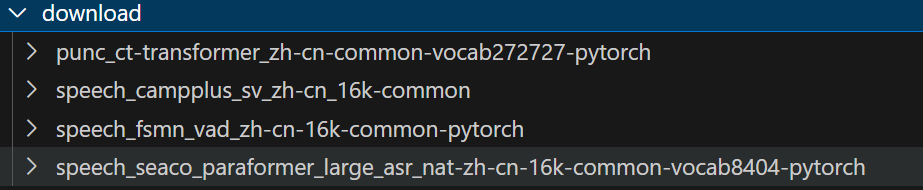

是这四个吗?我测的听悟里面的转文字和声纹 感觉都比我自己测的好,是模型不一样还是他们做了一些别的处理?

ModelScope-Funasr通义听悟里面的语音识别和声纹识别确实使用了Funasr框架里面可组合的模型。

ModelScope-Funasr是一个基于深度学习的语音识别模型,它利用了阿里达摩院自研的技术和模型。具体来说,通义听悟中的语音识别功能主要依托于Paraformer非自回归端务。此外,Funasr还支持标点符号识别、低语音识别、音频-视觉语音识别等功能,这些功能的加入可以显著提高语音转写的准确性和可用性。

至于您提到的转文字和声纹识别感觉比自己测试的好,这可能是因为他们使用了更先进的模型或者是进行了一些额外的优化处理。例如,他们可能对模型进行了特定的训练,或者在后处理阶段加入了一些算法来提高识别结果的质量。此外,专业的语音识别服务通常会有一套完整的数据清洗和模型调优流程,这些都是提升识别效果的重要因素。

总的来说,ModelScope-Funasr通义听悟的语音识别和声纹识别功能得益于Funasr框架的强大模型和技术支持,以及可能的额外优化措施,从而确保了较高的识别准确率和用户体验。