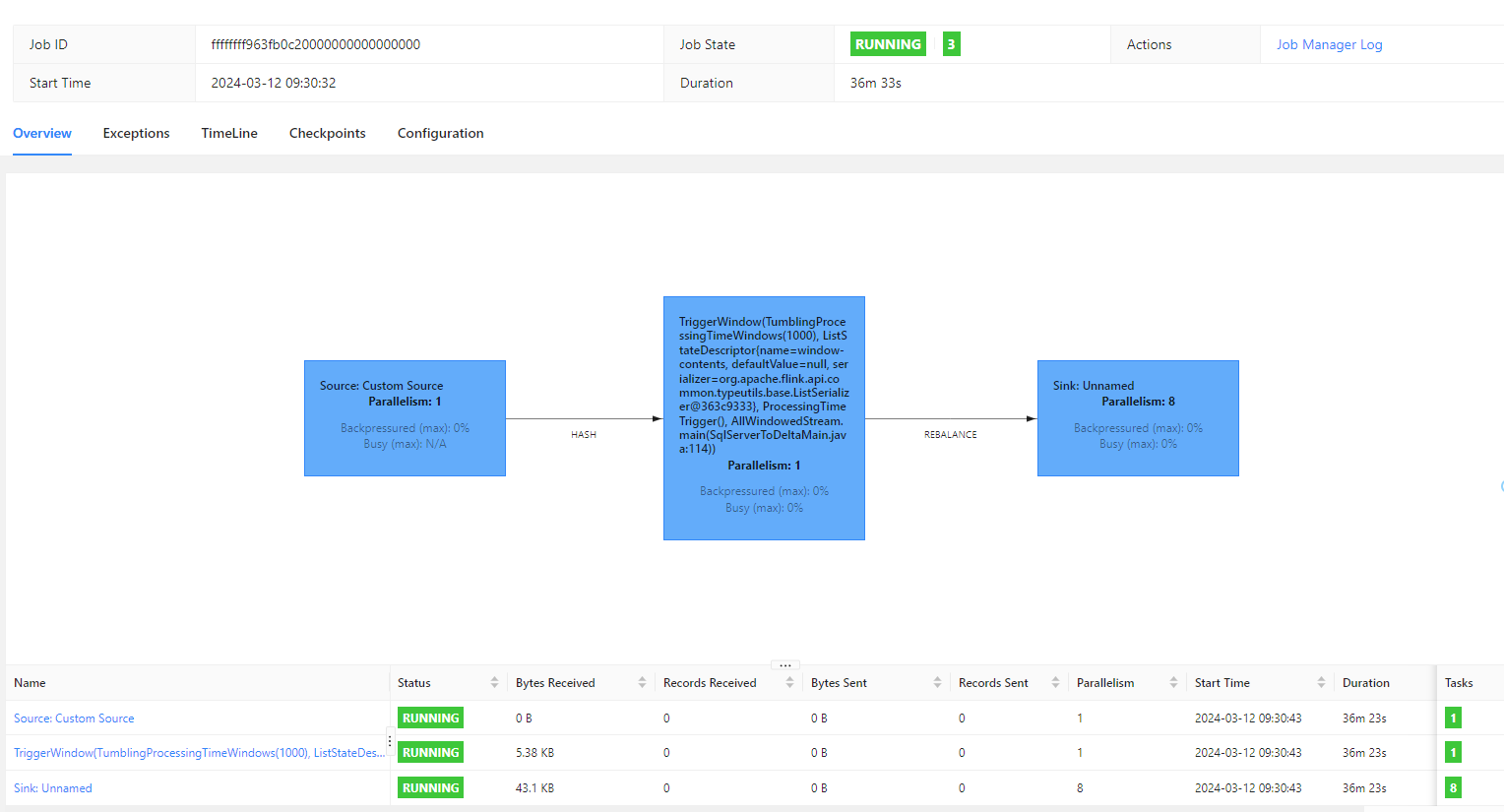

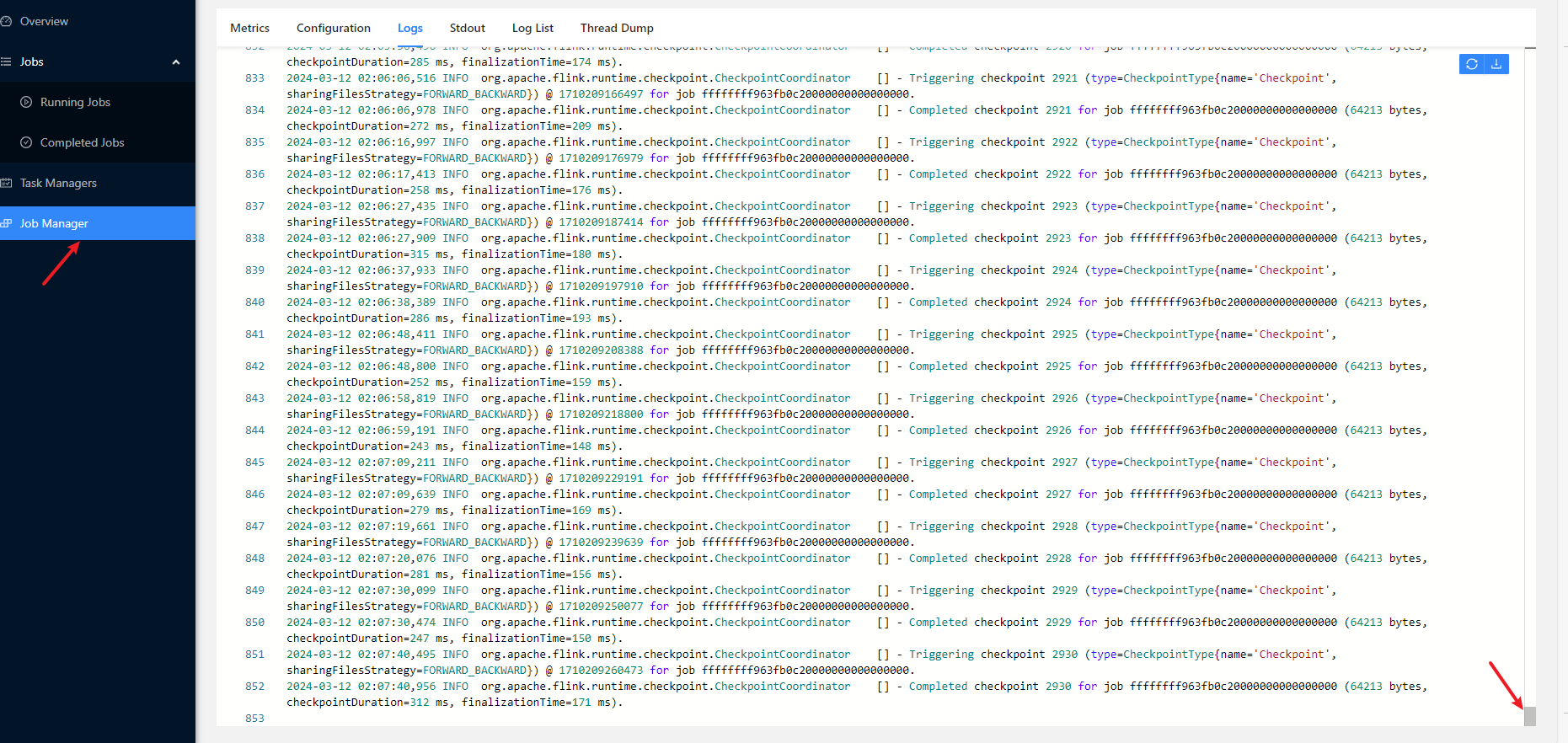

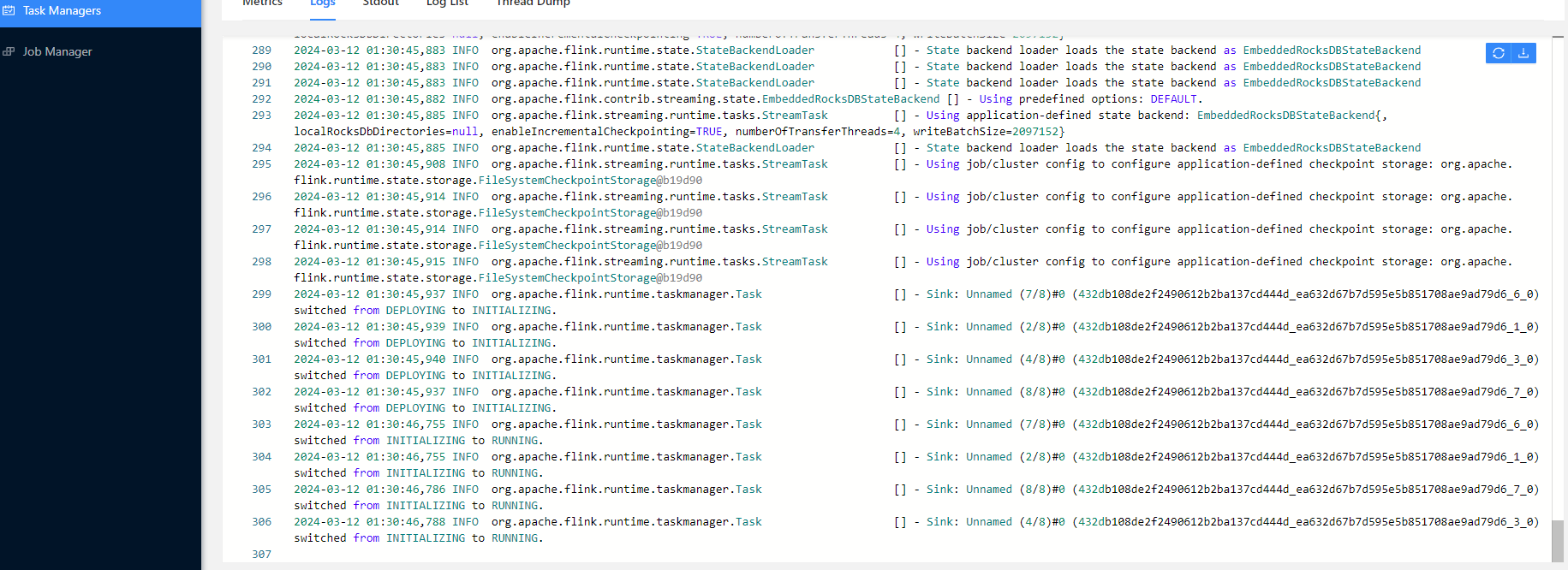

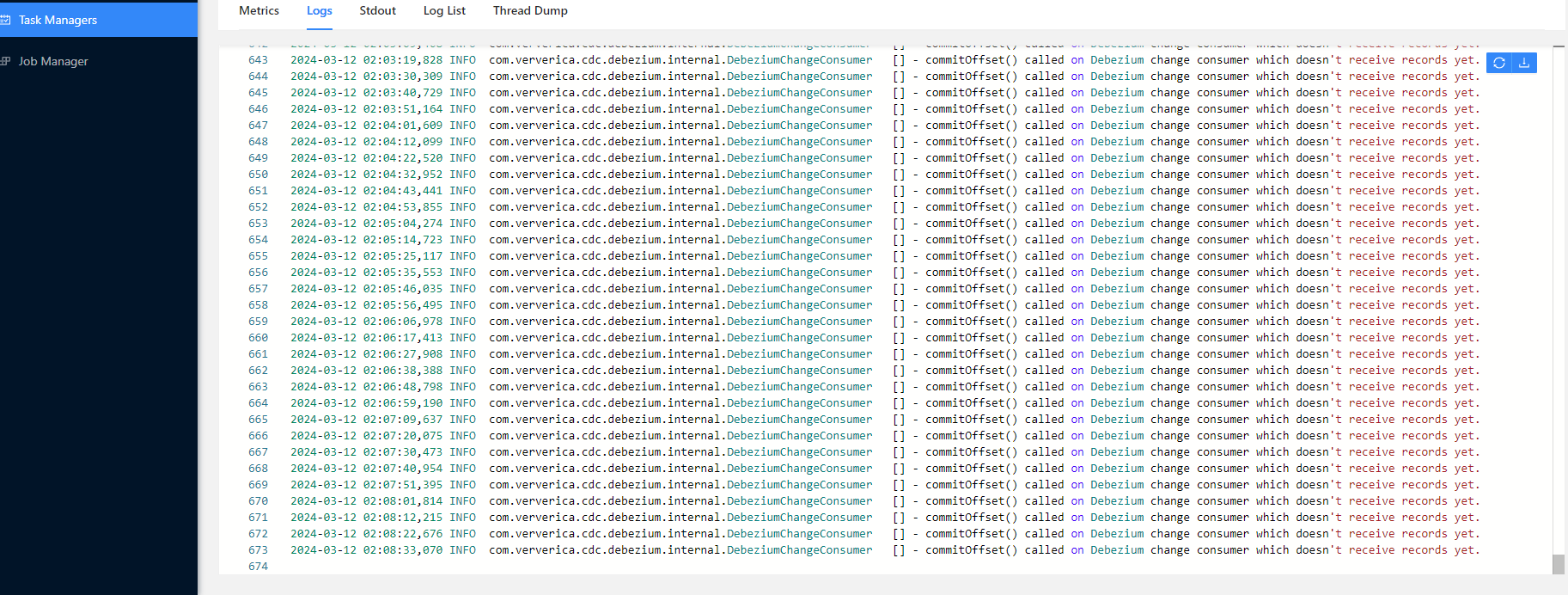

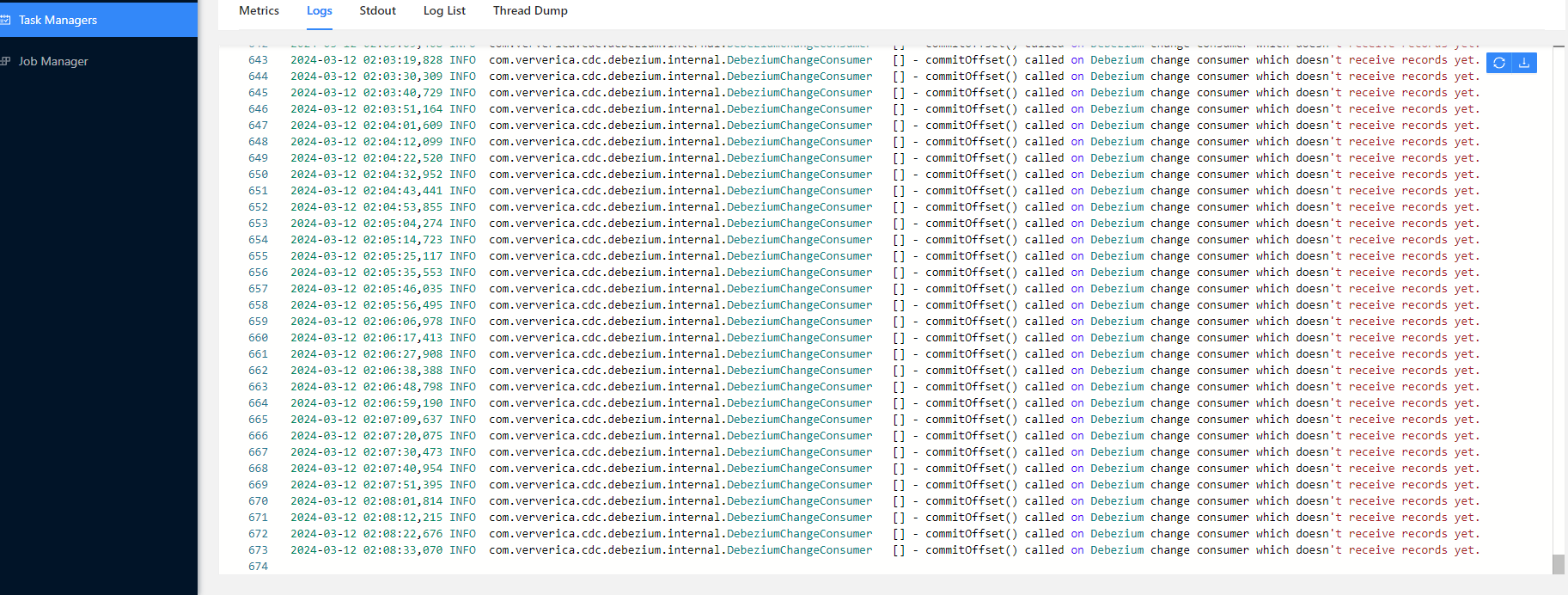

flincdc 忽然收不到数据,我又开启了一遍cdc 还不行,为什么?日志都是info正常,无报错信息,面是日志还有执行图,我又请dba开了一下cdc,代码验证我本地的表是没有问题的,没有思路排查了。

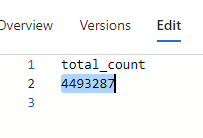

里面有数据

里面有数据

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

根据您描述的情况,Flink CDC作业忽然收不到数据,日志显示正常且无报错信息,同时DBA已确认CDC功能开启,本地表验证也无问题。以下是可能的原因及对应的排查和解决方案:

排查方法:

SHOW VARIABLES LIKE 'expire_logs_days';

如果值过小(如默认的0或1天),可能导致Binlog被清理。

解决方案:

SET GLOBAL expire_logs_days = 7;

排查方法:

execution.checkpointing.interval

解决方案:

execution.checkpointing.interval=10s

排查方法:

scan.startup.mode 参数控制消费起始位置,可能值包括:earliest-offset:从最早可用的Binlog位点开始消费。latest-offset:从最新的Binlog位点开始消费。timestamp:从指定时间戳开始消费。specific-offset:从指定的Binlog位点开始消费。解决方案:

'scan.startup.mode' = 'latest-offset'

排查方法:

SHOW VARIABLES LIKE 'max_connections';

REPLICATION SLAVEREPLICATION CLIENTSELECT 权限解决方案:

排查方法:

解决方案:

排查方法:

table-name参数是否正确匹配目标表。解决方案:

table-name参数正确配置,例如:'table-name' = 'your_table_name'

'table-name' = 'user_.*'

排查方法:

BinlogSplitReader is created的日志,确认是否已完成全量数据同步。解决方案:

根据上述排查步骤,建议优先检查以下内容: 1. MySQL Binlog的可用性:确保Binlog未被清理且保留时间足够长。 2. Checkpoint配置:调整Checkpoint间隔时间以加快增量数据读取。 3. 消费位置:确认作业重启后的消费模式是否正确。 4. 数据库连接与权限:确保Flink CDC具备足够的连接数和权限。 5. 反压情况:优化下游算子性能以避免反压。

如果以上步骤仍无法解决问题,请提供更多详细信息(如Flink作业配置、MySQL版本、日志片段等),以便进一步分析。您可以复制页面截图提供更多信息,我可以进一步帮您分析问题原因。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。