"

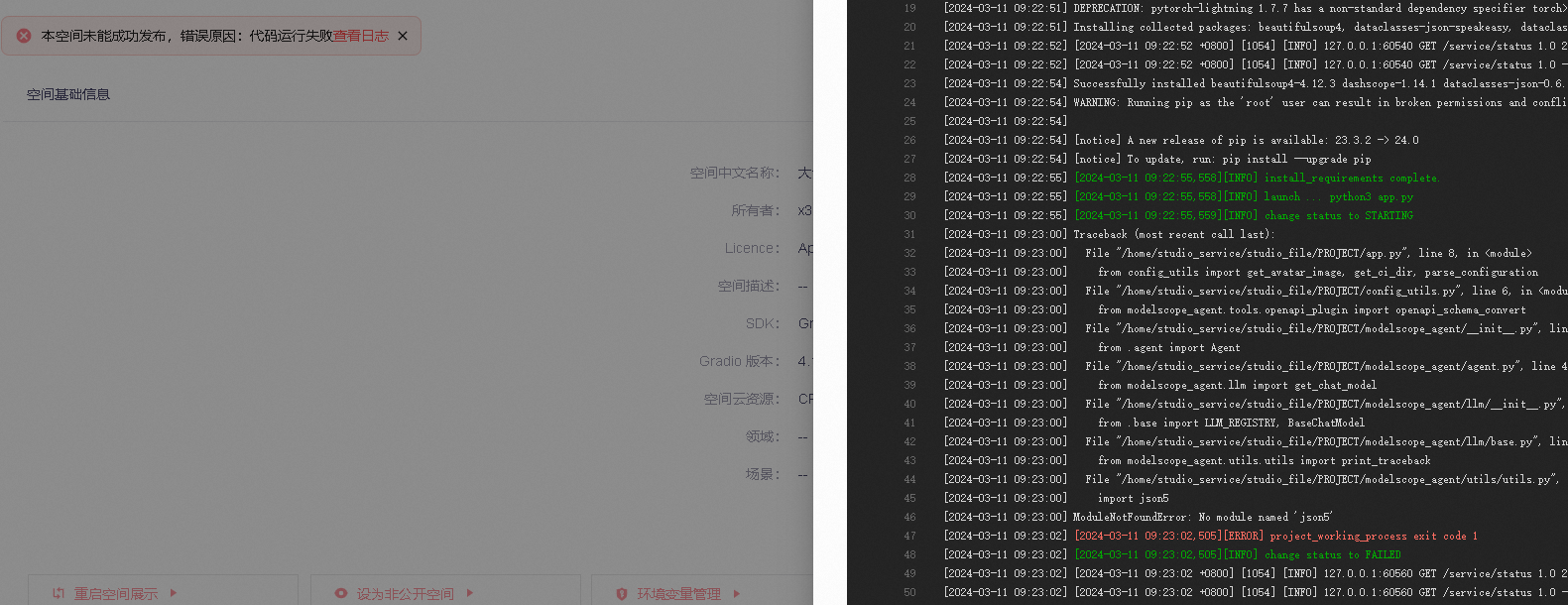

ModelScope本地能运行,怎么上传到平台发布就报错呢?"

在将ModelScope模型从本地上传到平台发布时出现报错,可能与以下几个关键因素有关。以下是详细分析和解决方法:

如果您的模型在本地运行正常,但在上传到平台后报错,可能是由于JAR包或依赖冲突导致的。

pom.xml中设置scope为provided,以避免重复加载。ModelScope中的大语言对话模型(如Llama、Baichuan系列)对GPU资源要求较高。如果平台上的资源配置不足,可能会导致部署失败。

ml.gu7i.c16m60.1-gu30实例规格。在自定义模型部署时,如果未正确配置MODEL_ID、TASK、REVISION等参数,可能导致服务无法正常启动。

MODEL_ID:模型的唯一标识符。TASK:模型对应的任务类型。REVISION:模型的具体版本号(例如v1.0.1,不能使用master)。如果模型服务已成功部署,但调用时仍然报错,可能是API请求格式或参数配置有误。

service_url和token正确无误。{

"prompt": "浙江的省会是哪里?",

"history": []

}

如果上述方法仍无法解决问题,可以通过日志进一步排查错误原因。

request_id字段追踪具体请求的执行情况。根据知识库资料,ModelScope模型上传到平台发布时的常见问题主要包括依赖冲突、资源配置不足、模型配置不完整以及API调用错误。建议按照以下步骤逐一排查: 1. 检查依赖冲突并调整打包方式。 2. 确保平台资源配置满足模型需求。 3. 验证模型配置参数的完整性。 4. 检查API请求格式和服务状态。 5. 查看日志信息以定位具体问题。

如果问题仍未解决,请提供具体的错误日志或报错信息,以便进一步分析。您可以复制页面截图提供更多信息,我可以进一步帮您分析问题原因。

ModelScope旨在打造下一代开源的模型即服务共享平台,为泛AI开发者提供灵活、易用、低成本的一站式模型服务产品,让模型应用更简单!欢迎加入技术交流群:微信公众号:魔搭ModelScope社区,钉钉群号:44837352