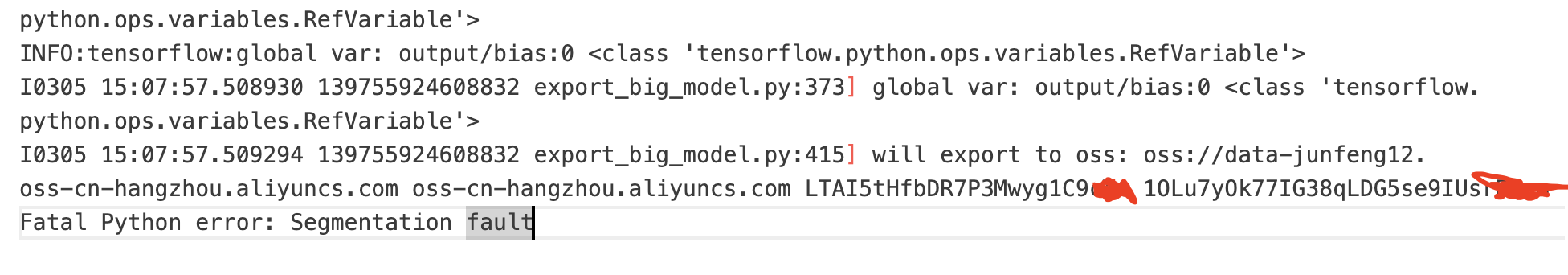

机器学习PAI在导出增量模型到oss时报段错误,是因为oss配置不对吗?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在机器学习PAI中,导出增量模型到OSS时出现段错误(Segmentation Fault),可能的原因有多种,并不一定完全由OSS配置问题引起。以下是可能导致该问题的原因及对应的解决方案:

如果OSS路径配置不正确或权限不足,可能会导致模型导出失败。请检查以下内容: - OSS路径格式:确保路径符合oss://<bucketname>/<path>的格式。 - 权限配置:确认使用的AccessKey ID和AccessKey Secret具有对目标OSS路径的读写权限。如果使用RAM角色授权,请确保角色已正确绑定并具备访问OSS的权限。

解决方法: - 检查OSS路径是否正确,例如:oss://my-bucket/models/。 - 如果权限不足,可以通过以下方式解决: - 使用正确的AccessKey ID和AccessKey Secret。 - 或者在PAI控制台中为服务绑定具有OSS访问权限的RAM角色。

段错误可能是由于模型文件本身存在问题,例如文件损坏、格式不兼容或未正确保存为支持的格式。

解决方法: - 确保模型文件是完整且未损坏的。可以尝试重新训练或下载模型文件。 - 如果使用的是PyTorch模型,请确保模型已保存为TorchScript格式(.pt或.pth)。PAI EAS预置的PyTorch Processor仅支持加载TorchScript模型。参考以下代码将模型转换为TorchScript格式:

import torch

# 假设model是您的PyTorch模型

scripted_model = torch.jit.script(model)

scripted_model.save("model.pt")

如果导出过程中内存不足,也可能导致段错误。尤其是在处理大模型时,内存需求较高。

解决方法: - 增加Worker的内存配置。在模型导出的参数中,调整Worker Memory用量,例如设置为80000 MB(即80 GB)。 - 如果使用的是EAS在线服务部署,确保服务的内存配置足够。可以在JSON配置文件中增加memory参数,例如:

{

"memory": "80000"

}

如果Processor配置不正确,可能会导致模型加载失败,从而引发段错误。

解决方法: - 确保processor_path和processor_entry参数正确配置。例如,如果使用自定义Processor,请指定主文件路径(如libprocessor.so或app.py)。 - 如果使用官方预置Processor,请确认Processor Code与模型类型匹配。

如果上述方法无法解决问题,建议通过日志进一步排查: - 查看PAI平台的日志信息,定位具体的错误原因。 - 如果日志中提示“Fail to load model”或“istream reader failed”,则可能是模型文件格式或路径问题。 - 根据日志中的错误信息,手动下载相关依赖或模型文件,并上传至OSS进行挂载。

oss_endpoint参数。例如,当服务部署在北京地域,而模型存储在杭州地域时,需指定杭州地域的公网Endpoint。通过以上步骤逐一排查,应该能够解决导出增量模型到OSS时报段错误的问题。如果问题仍然存在,建议联系阿里云技术支持,提供详细的日志信息以便进一步分析。

人工智能平台 PAI(Platform for AI,原机器学习平台PAI)是面向开发者和企业的机器学习/深度学习工程平台,提供包含数据标注、模型构建、模型训练、模型部署、推理优化在内的AI开发全链路服务,内置140+种优化算法,具备丰富的行业场景插件,为用户提供低门槛、高性能的云原生AI工程化能力。